@bolide154 Xin chào bạn. Đầu tiên, xin cảm ơn bạn đã gửi ý kiến tại Viblo.

Viblo hoàn toàn không ủng hộ việc copy hoàn toàn nội dung của người khác về mà không hề xin phép tác giả hay để lại backlink đến bài gốc, nếu bạn có thấy bài nào như vậy xin hãy phản ánh để Viblo Team tiến hành xoá bài viết nhé

Còn về bài viết này thì xin được đính chính với bạn rằng: techblog.vn là một trang chuyên đi clone bài viết của Viblo về (và họ có để lại backlink đến bài viết gốc, nếu bạn để ý kỹ). Bài viết này cũng được bên đó bê nguyên từ Viblo, chứ hoàn toàn không có chuyện user của Viblo ăn cắp bài như bạn nói nhé

Hy vọng từ giờ bạn có thể trực tiếp ghé thăm Viblo để theo dõi những nội dung gốc, thay vì vào những trang như techblog ở trên, để ủng hộ Viblo

Trong trường hợp mình dùng BEM với các framework không BEM (Bootstrap, Semantic-UI, ...) thì sao Tín? Mình nên đối xử với mấy component có sẵn của nó như thế nào?

THẢO LUẬN

Bài viết rất hay và đánh giá cặn kẽ chi tiết

Em đã tạo thành công con bot, có điều nó chỉ reply mỗi mình em thôi, còn người dùng khác thì không rep. Em miss ở đâu sao ạ !

@bolide154 Xin chào bạn. Đầu tiên, xin cảm ơn bạn đã gửi ý kiến tại Viblo.

Viblo hoàn toàn không ủng hộ việc copy hoàn toàn nội dung của người khác về mà không hề xin phép tác giả hay để lại backlink đến bài gốc, nếu bạn có thấy bài nào như vậy xin hãy phản ánh để Viblo Team tiến hành xoá bài viết nhé

Còn về bài viết này thì xin được đính chính với bạn rằng: techblog.vn là một trang chuyên đi clone bài viết của Viblo về (và họ có để lại backlink đến bài viết gốc, nếu bạn để ý kỹ). Bài viết này cũng được bên đó bê nguyên từ Viblo, chứ hoàn toàn không có chuyện user của Viblo ăn cắp bài như bạn nói nhé

Hy vọng từ giờ bạn có thể trực tiếp ghé thăm Viblo để theo dõi những nội dung gốc, thay vì vào những trang như techblog ở trên, để ủng hộ Viblo

Cảm ơn bạn rất nhiều

Toàn đi ăn cắp bài của người khác. https://techblog.vn/index.php/lam-quen-voi-laravel-va-vuejs-su-dung-webpack

xúc động cá

trụ cột của team là đây

t biết Quân viết 1 bài về cái này lâu rồi nhá, troll bạn quá rồi (huhu)

giỏi quá, có vẻ là sắp lên div rồi.

Great post!

bài viết hay quá :v

Em cảm ơn vì bài viết hữu ích của anh.

Tạo cấu trúc thư mục deploythì chúng ta tạo thư mục từ~của ubuntu trên server hay ở trong/etc/nginx/conf.dcủa server ạcap production deploythì app của mình tự lên dc ạ ???Cảm ơn bạn với bài viết hữu ích. Mình thấy có 1 số lỗi typo, phần $http và $location và $filter. Bạn có thể sửa lại để bài viết trọn vẹn hơn.

cảm ơn bạn nhiều nhé ^^

trước cũng một thời tung hoành với VBA ... mà lâu quá không đụng tới nó rồi, chắc chẳng nhớ gì nữa

lỗi api là sao anh

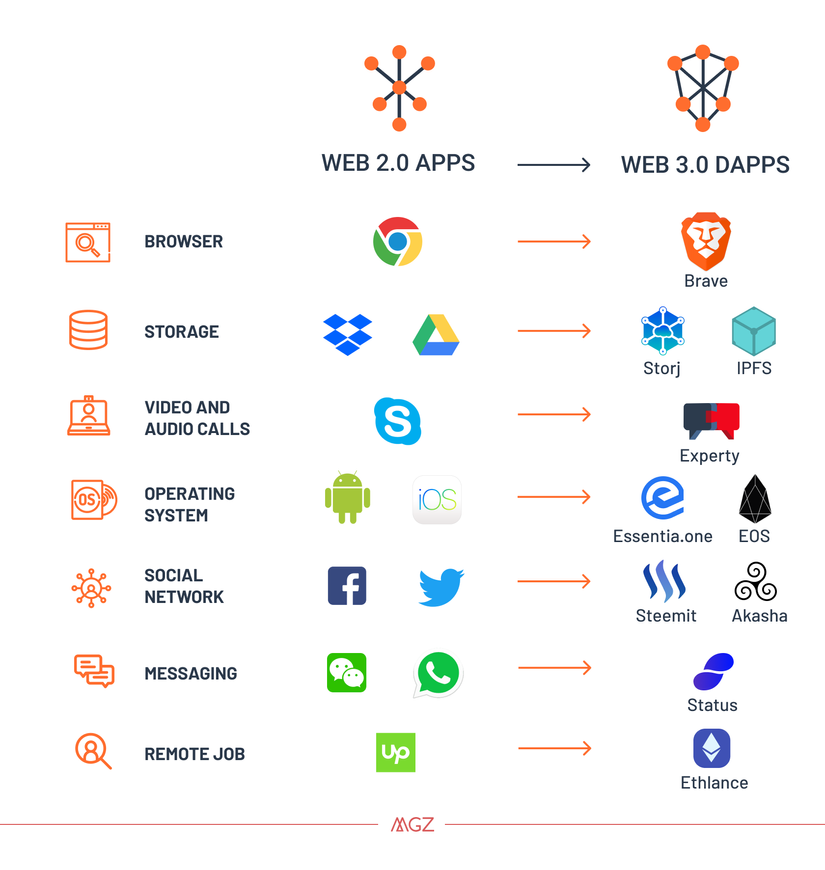

Vậy 3.0 là gì chưa nói gì về 4.0 cả chỉ đc cái tiêu đề cho độc bạn à nhìn hình này đi giống cây view nhỉ -_-

Trong trường hợp mình dùng BEM với các framework không BEM (Bootstrap, Semantic-UI, ...) thì sao Tín? Mình nên đối xử với mấy component có sẵn của nó như thế nào?

Chắc bạn đang muốn tìm hiểu sự thay đổi của 1 model "Bài viết" khi update phải không nhỉ, nếu không nhầm bạn có thể tìm hiểu Observers https://laravel.com/docs/5.6/eloquent#observers

Hot author

chừng nào có bài vậy bác :v giới thiệu cách cài đặt luôn nha bác

Hình như Mongodb nó hết cho tải free rồi ạ