Em cảm ơn anh đã bỏ thời gian ra chia sẻ những bài viết có ích như thế này. Em có một thắc mắc mong anh giải đáp: "Trong global context, this trỏ đến global object (trong trình duyệt là window), và status global là "😎". ". Em tưởng là this trỏ đến obj window -> nhưng thuộc tính window.status chưa đc định nghĩa (biến status="😎" không phải là của obj window) -> kết quả là undefined

Miễn phí thì không hoàn toàn nhé, ví dụ nếu code C# thì các gói extension vẫn duy trì license như bên visual studio, không miễn phí cho các cty có doanh thu trên 1m USD

@refacore vì em có dùng php ở trong nên dùng nginx làm webserver đứng trước á bác. Vì traefik không dùng trực tiếp với php được, hoặc em chưa tìm được cấu hình đúng

Đúng ra hệ thống của bạn không cần nginx cũng được vì mình thấy con Traefik kia cũng đủ vai trò trong việc cân bằng tải và đưa port TCP của ứng dụng thành port HTTP rồi

Có thể dùng trực tiếp Traefik + php mà không cần thông qua 1 thằng webserver được à anh

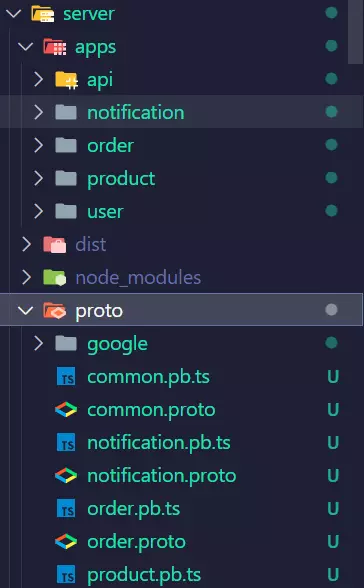

Thì nếu mà ở khúc tải ts-proto vẫn ko compile đc thì các bạn thử npm i -D ts-proto @protobuf-ts/protoc và ở trong package.json thêm "proto:user": "protoc --plugin=node_modules/.bin/protoc-gen-ts_protoc.cmd -I=./proto --ts_proto_out=proto proto/user.proto --ts_proto_opt=nestJs=true --ts_proto_opt=fileSuffix=.pb". Lưu ý đây là code mẫu mọi người thay thế đường dẫn cho phù hợp

THẢO LUẬN

Hay quá anh ơi, ra tiếp cách làm với Literal.club chia sẽ sách đang đọc đi anh

Đúng nè , App banking không có refresh Token

Em cảm ơn anh đã bỏ thời gian ra chia sẻ những bài viết có ích như thế này. Em có một thắc mắc mong anh giải đáp: "Trong global context, this trỏ đến global object (trong trình duyệt là window), và status global là "😎". ". Em tưởng là this trỏ đến obj window -> nhưng thuộc tính window.status chưa đc định nghĩa (biến status="😎" không phải là của obj window) -> kết quả là undefined

Cảm ơn bạn đã quan tâm, bạn có thể xem thêm bài viết mới tại https://viblo.asia/p/dns-va-route-53-tren-aws-phan-2-cac-khai-niem-co-ban-ve-route-53-aNj4vbx246r nha

Cảm ơn bạn nhé😘

Miễn phí thì không hoàn toàn nhé, ví dụ nếu code C# thì các gói extension vẫn duy trì license như bên visual studio, không miễn phí cho các cty có doanh thu trên 1m USD

Bro,

@refacore vì em có dùng php ở trong nên dùng nginx làm webserver đứng trước á bác. Vì traefik không dùng trực tiếp với php được, hoặc em chưa tìm được cấu hình đúng

viết gì ngay từ đầu đã khó hiểu

Mark: "Trust me bro, the data is legal"

👍️

nginx ở đây chưa rõ vai trò. Khả năng cao là host Single page app. Nếu thế thì ko bỏ đi đc.

Anh cho em hỏi chỗ này ạ:

Có thể dùng trực tiếp Traefik + php mà không cần thông qua 1 thằng webserver được à anh

mình đã thử nhưng chưa thành công, b có thể chia sẽ chút thông tin được k ạ?

HI anh em liên lạc riêng với anh bằng cách nào ạ

good

Em cảm ơn. Vẫn không được anh ạ. Em deploy thông qua nginx trong debian ạ.

Thì nếu mà ở khúc tải ts-proto vẫn ko compile đc thì các bạn thử npm i -D ts-proto @protobuf-ts/protoc và ở trong package.json thêm "proto:user": "protoc --plugin=node_modules/.bin/protoc-gen-ts_protoc.cmd -I=./proto --ts_proto_out=proto proto/user.proto --ts_proto_opt=nestJs=true --ts_proto_opt=fileSuffix=.pb". Lưu ý đây là code mẫu mọi người thay thế đường dẫn cho phù hợp