Paper reading | NEURAL TOPIC MODEL VIA OPTIMAL TRANSPORT

Bài đăng này đã không được cập nhật trong 2 năm

Giới thiệu

Các Neural Topic Models được sự chú ý trong giới research nhờ có kết quả đầy hứa hẹn trong task text analysis  . Một topic model điển hình có mục tiêu là khám phá tập các latent topics trong một tập các văn bản. Gần đây, sự phát triển của Variational AutoEncoders (VAEs) và Autoencoding Variational Inference (AVI) tạo cơ sở cho việc xây dựng các Neural Topic Models (NTM). Được lấy cảm hứng từ VAE, nhiều model NTMs sử dụng một encoder nhận biểu diễn Bag-of-Words của một tài liệu làm input và thực hiện xấp xỉ phân phối hậu nghiệm (posterior distribution) của các latent topics.

. Một topic model điển hình có mục tiêu là khám phá tập các latent topics trong một tập các văn bản. Gần đây, sự phát triển của Variational AutoEncoders (VAEs) và Autoencoding Variational Inference (AVI) tạo cơ sở cho việc xây dựng các Neural Topic Models (NTM). Được lấy cảm hứng từ VAE, nhiều model NTMs sử dụng một encoder nhận biểu diễn Bag-of-Words của một tài liệu làm input và thực hiện xấp xỉ phân phối hậu nghiệm (posterior distribution) của các latent topics.

Nếu bạn chưa biết, Posterior distribution (phân phối hậu nghiệm) là phân phối xác suất của một biến ngẫu nhiên sau khi có thêm thông tin mới từ dữ liệu quan sát được. Nó được tính dựa trên phân phối tiền nghiệm (prior distribution) và dữ liệu quan sát (observed data) thông qua công thức Bayes.

Cụ thể, posterior distribution được tính bằng cách nhân phân phối tiền nghiệm với hàm mật độ xác suất của dữ liệu quan sát và chuẩn hóa theo tổng của tích của phân phối tiền nghiệm với hàm mật độ xác suất của dữ liệu quan sát. Công thức toán học của posterior distribution có thể được biểu diễn như sau:

Trong đó:

- là posterior distribution của biến ngẫu nhiên theta khi biết dữ liệu quan sát .

- là hàm mật độ xác suất của dữ liệu quan sát khi biết giá trị của biến ngẫu nhiên theta.

- là phân phối tiền nghiệm của biến ngẫu nhiên \theta.

- là hằng số chuẩn hóa được tính bằng tổng của tích của phân phối tiền nghiệm với hàm mật độ xác suất của dữ liệu quan sát: .

Posterior distribution cung cấp thông tin quan trọng cho việc dự đoán và suy luận trong các ứng dụng thống kê và khoa học dữ liệu.

Các posterior samples là đầu vào của encoder để tái tạo lại biểu diễn BoW. So với các topic models thông thường, các NTM thường có tính linh hoạt và khả năng mở rộng tốt hơn, điều này rất quan trọng đối với các ứng dụng trên dữ liệu quy mô lớn.

Mặc dù có hiệu suất tiềm năng nhưng các NTM vẫn tồn tại một số nhược điểm:

- Quá trình training và inference của NTM thường phức tạp do việc tái tạo các latent topics.

- Đối với nhiều NTM hiện tại, việc đạt được biểu diễn tài liệu tốt và các topic có tính nhất quán / đa dạng một cách đồng thời là khó khăn. Điều này là do objective của NTMs là đạt được sai số tái tạo thấp (lower reconstruction error), điều này thường có nghĩa là các topic ít nhất quán và đa dạng hơn.

- Các topic model thường có hiệu suất thấp với các văn bản ngắn như tweets, tiêu đề, review sản phẩm vì mỗi tài liệu riêng lẻ chứa không đủ thông tin về sự xuất hiện của từ. Vấn đề này có thể trở nên trầm trọng hơn đối với các NTM do việc sử dụng các mạng encoder và decoder thường dễ bị ảnh hưởng bởi độ thưa thớt của dữ liệu.

Đóng góp

Để giải quyết các vấn đề trên của mô hình NTM, nhóm tác giả đề xuất neural topic model với một số điểm mới sau.

Với 1 văn bản, nhóm tác giả xét nội dung được encode theo 2 biểu diễn: observed representation (biểu diễn quan sát được), , đây là phân phối của tất cả các từ trong vocabulary và latent representation (biểu diễn ẩn), , đây là phân phối qua tất cả các topic. Trong đó, được xác định bằng cách chuẩn hóa vector đếm từ trong văn bản và được học từ model.

Cho một tập văn bản, vocabulary size (số lượng các từ riêng biệt) có thể rất lớn nhưng một văn bản thường bao gồm một tập nhỏ các từ. Vì vậy, thường là một biểu diễn ngữ nghĩa thưa và low-level trong một văn bản. Ngoài ra, vì số lượng các topic nhỏ hơn nhiều so với vocabulary size, là biểu diễn tương đối dày đặc (dense) và high-level trong cùng văn bản đó. Vì vậy, việc học của topic model có thể được định nghĩa là một quá trình học phân phối sao cho càng gần với phân phối càng tốt. Theo cách này, một điều quan trọng là ta cần xác định cách đo lường "khoảng cách" giữa 2 phân phối. Trong bài báo, nhóm tác giả đề xuất sử dụng Optimal Transport (OT), cụ thể là phát triển NTM mới dựa trên việc tối thiểu hóa OT.

Ý tưởng của model là sử dụng encoder có output là phân phối topic của một văn bản dựa trên input là vector đếm từ của văn bản đó giống như NTM thông thường. Điểm mới là nhóm tác giả tối thiểu hóa khoảng cách OT giữa 2 phân phối rời rạc và . Đặc biệt, hàm chi phí của khoảng cách OT mô tả trọng số giữa các topic và các từ được nhóm tác giải định nghĩa như khoảng cách trong embedding space. Để biểu diễn ngữ nghĩa thì tất các các từ và topic được embed trong embedding space này. Với khả năng tận dụng được các pretrained word embedding và tính chất của OT trong mô hình hóa các cấu trúc hình học trên không gian phân phối xác suất, mô hình được đề xuất có thể đạt được sự cân bằng tốt hơn giữa việc thu được biểu diễn tài liệu tốt và tạo ra các topic nhất quán / đa dạng.

Một số kiến thức nền tảng

Phần này sẽ nhắc lại một số kiến thức nền tảng chính được sử dụng trong model đề xuất.

Neural topic models

Đa phần các NTM hiện tại có thể xem như là bản mở rộng của VAE trong đó latent variables là các topic. Giả sử tập văn bản cần phân tích có từ riêng biệt (vocabulary size). Mỗi văn bản gồm vector đếm từ là và phân phối ẩn của topic: . Một NTM giả sử rằng cho một văn bản được tạo từ prior distribution và được tạo từ conditional distribution được mô hình bởi decoder . Mục tiêu của mô hình là infer topic distribution cho bởi số lượng từ. Cụ thể hơn đó là tính toán bằng cách xấp xỉ variational distribution được mô hình bởi encoder . Tương tự như VAEs, training objective của NTMs là tối đa hóa Evidence Lower BOund (ELBO):

Optimal Transport

Khoảng cách OT được sử dụng rộng rãi cho việc so sánh các xác suất. Cụ thể, ta xét 2 vector xác suất và , trong đó biểu thị một simplex. D-1 simplex là một thuật ngữ được sử dụng trong lý thuyết xác suất và đại số tuyến tính để chỉ tập hợp các điểm trong không gian D chiều thỏa mãn tổng các thành phần bằng 1 và tất cả các thành phần đều không âm. Khoảng cách OT giữa 2 vector xác suất được định nghĩa như sau:

Trong đó là Frobenius dot-product. Frobenius dot-product là một phép toán tích vô hướng giữa hai ma trận vuông cùng kích thước. Frobenius dot-product được tính bằng cách lấy tổng các tích phần tử tương ứng của hai ma trận, hay còn gọi là inner product. là ma trận chi phí transport. là transport plan. là transport polytype của và , đó là tập đa diện giới hạn bởi các ma trận : ; và là vector có chiều, tất cả các phần tử đều bằng 1.

Nếu xét hai biến ngẫu nhiên rời rạc Categorical và Categorical , ma trận transport là xác suất đồng thời của , tức là và là tập hợp tất cả các xác suất đồng thời. Khoảng cách OT tối ưu trên có thể tính bằng cách tìm ma trận OT .

Model đề xuất

Trong model đề xuất, ta coi mỗi văn bản là một phân phối của từ, được xác định bằng cách chuẩn hóa trong đó là độ dài của văn bản. Tương tự, mỗi văn bản liên kết với một phân phối của topics .

Giống như các NTMs khác, nhóm tác giả sử dụng một encoder để tạo từ : . Vì và là 2 phân phối có vai trò hỗ trợ khác nhau cho cùng 1 văn bản, để học encoder, nhóm tác giả đề xuất tối thiểu hóa khoảng cách OT để làm cho gần hơn.

Trong đó là ma trận chi phí, là khoảng cách ngữ nghĩa giữa topic và từ . Do đó, mỗi cột của capture mức độ quan trọng của từ tương ứng với topic. Ngoài ra, cũng là biến cần học trong model.

Tuy nhiên, việc học ma trận chi phí là một non-trivial task. Để giải quyết vấn đề này, nhóm tác giả chỉ định việc xây dựng như sau:

trong đó là cosine similarity; và là embedding của topic và word tương ứng.

Vậy cốt lõi ở đây là ta sẽ học embedding với mong muốn nắm được ngữ nghĩa thông tin của topic và từ. Tuy nhiên, thay vì học word embedding, nhóm tác giả tận dụng một số pretrained word embedding như word2vec và GloVe, điều này giúp cho việc tối ưu số lượng tham số trong quá trình học của và hiệu quả trong các văn bản ngắn. Ngoài ra, trong công thức trên ta sử dụng cosin similarity nên ta có .

Để dễ dàng biểu diễn hơn, nhóm tác giả biểu thị và là tập các embedding của các topic và từ. Ta có thể viết lại công thức tối thiểu hóa khoảng cách OT như sau

Khác với các model NTM trước đây dựa vào VAE, model được đề xuất không có decoder để chiếu về word space để tái tạo , bản thân khoảng cách OT đã giúp tính khoảng cách giữa và trực tiếp. Để hiểu hơn về model, ta có thể chiếu đến không gian của bằng cách định nghĩa một decoder ảo như sau .

Ta có thể xây dựng mối quan hệ giữa các NTMs khác với model được đề xuất như sau:

Với và ta có

Với định lý trên ta có bổ đề sau: Tối đa hóa expected multinomial log-likelihood của NTM tương đương với việc tối thiểu hóa cận trên của khoảng cách OT trong model đề xuất.

Trong bài báo, nhóm tác giả đề xuất hàm loss là sự kết hợp giữa khoảng cách OT và expected log-likelihood:

Ta có thể thấy công thức trên khá giống với ELBO  Nhóm tác giả tiếp tục thay thế khoảng cách OT bằng khoảng cách Sinkhorn, và hàm loss cuối cùng của chúng ta sẽ như sau:

Nhóm tác giả tiếp tục thay thế khoảng cách OT bằng khoảng cách Sinkhorn, và hàm loss cuối cùng của chúng ta sẽ như sau:

Trong đó, . được tham số hóa bởi . . và là vector đếm từ và chuẩn hóa của vector đó. và là các siêu tham số kiểm soát trọng số của expected likelihood và khoảng cách Sinkhorn tương ứng.

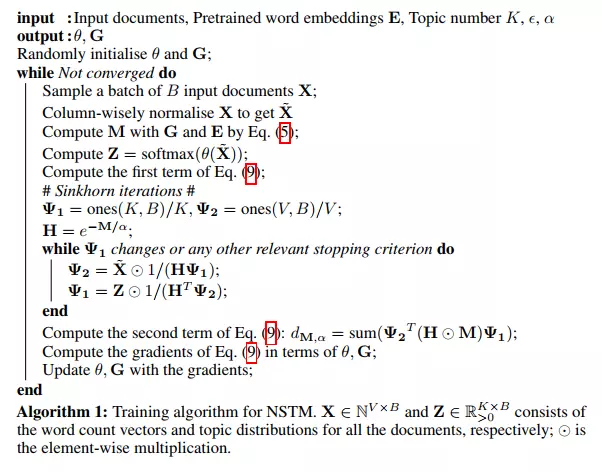

Để tính khoảng cách Sinkhorn ta dùng thuật toán Sinkhorn như dưới

Kết luận

Bài báo trên cho ta một cách tiếp cận mới trong Neural Topic Model sử dụng các kiến thức về xác suất thống kê. Viếc áp dụng các model xác suất vào các bài toán học máy giúp chúng ta có những góc nhìn tường minh hơn về cách mà model hoạt động.

Tham khảo

All rights reserved