Tìm hiểu 5 Xu hướng phân tích dữ liệu hàng đầu trong năm 2025

Các công ty, doanh nghiệp, tổ chức đã bắt đầu nhận ra tầm quan trọng của phân tích dữ liệu. Theo khảo sát, quy mô thị trường Big Data và phân tích kinh doanh toàn cầu dự kiến sẽ đạt 684,12 tỷ đô la vào năm 2030. Các xu hướng phân tích dữ liệu mới sẽ là vấn đề mà mọi tổ chức cần quan tâm vào thời điểm này.

1. Phân tích dữ liệu hỗ được trợ bởi AI

Phân tích dữ liệu hỗ trợ bởi AI sẽ ảnh hưởng đến hoạt động kinh doanh trên toàn thế giới hiện nay. Sự phát triển của trí tuệ nhân tạo trong phân tích dữ liệu đã nâng cao khả năng trực quan hóa và phân tích dữ liệu, cùng với việc cải thiện khả năng xử lý dữ liệu của con người. Các hệ thống AI cho phép chúng ta đưa ra quyết định nhanh hơn, linh hoạt hơn bằng cách thích ứng với những sự thay đổi.

Xu hướng này do các thuật toán tiên tiến và linh động đánh giá dữ liệu ở các quy mô khác nhau và thúc đẩy nhiều trường hợp không thể thực hiện bằng các phương pháp truyền thống. Các thuật toán AI đã nâng cao vị thế sản xuất lên 50%, trong đó 80% nhân viên cho biết năng suất được cải thiện. Ngoài ra, dự kiến thị trường AI toàn cầu sẽ tăng trưởng 37% vào năm 2030.

2. AI tập trung vào dữ liệu

Một trong những xu hướng phân tích dữ liệu, trí tuệ nhân tạo lấy dữ liệu làm trung tâm, đề cập đến thứ tự có hệ thống của dữ liệu được thiết kế để tạo ra các hệ thống AI. Nó chủ yếu tập trung vào việc hiểu, áp dụng và đưa ra quyết định dựa trên dữ liệu. Nó không dựa vào các thuật toán mà sử dụng phân tích dữ liệu và học máy để học hỏi từ dữ liệu nhằm quản lý dữ liệu tốt hơn.

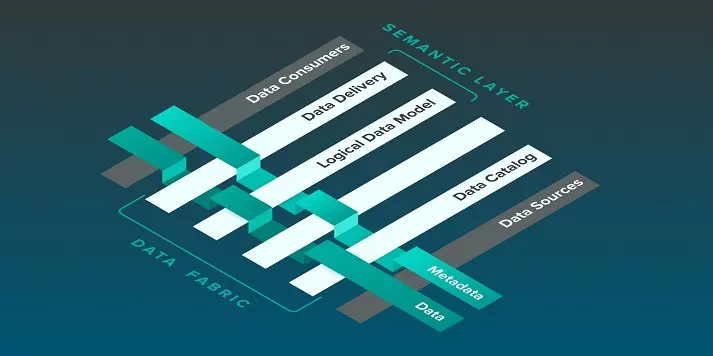

3. Metadata-Driven Data Fabric

Dữ liệu fabric là hệ thống cô lập thông tin khỏi siêu dữ liệu, học và thực hiện hành động phù hợp. Nó đánh dấu các cơ hội hoặc vấn đề liên quan đến dữ liệu và đưa ra các đề xuất để khắc phục chúng. Mục tiêu chính là quản lý dữ liệu một cách có hệ thống và điều này đã giảm 70% một số tác vụ quản lý dữ liệu, bao gồm triển khai và thiết kế.

Tiến trình này đảm bảo rằng có sự gia tăng trong việc sử dụng dữ liệu fabric do siêu dữ liệu thúc đẩy để nâng cao chất lượng của các dự án có thể kiếm được tiền. Xu hướng phân tích dữ liệu này dự kiến sẽ tăng trên thị trường toàn cầu trong giai đoạn dự báo từ năm 2023 đến năm 2030.

4. Edge Computing

Edge Computing (điện toán biên) là một loạt các thiết bị và mạng gần người dùng. Nó cung cấp một con đường để thu thập dữ liệu từ các thiết bị thông qua kết nối độ trễ thấp, xử lý hiệu suất cao và nền tảng an toàn. Đây là một mô hình điện toán mới nổi, trong đó dữ liệu được xử lý ở ngoại vi của mạng. Ở đây, Edge Computing tăng tốc độ truyền dữ liệu từ thiết bị đến một biên gần đó.

Điện toán biên chủ yếu được sử dụng để di chuyển bộ lưu trữ dữ liệu đến nguồn gốc hoặc nguồn của nó, giúp việc quản lý dữ liệu dễ dàng hơn. Ngoài ra, bạn có được dữ liệu chính xác và thông tin chi tiết có giá trị giúp đưa ra quyết định sáng suốt, giảm chi phí và dẫn đến thực hiện các hoạt động liên tục. Cách tiếp cận này có giá trị trên thị trường kinh doanh, tạo ra cơ hội để tăng cường sử dụng trải nghiệm kỹ thuật số.

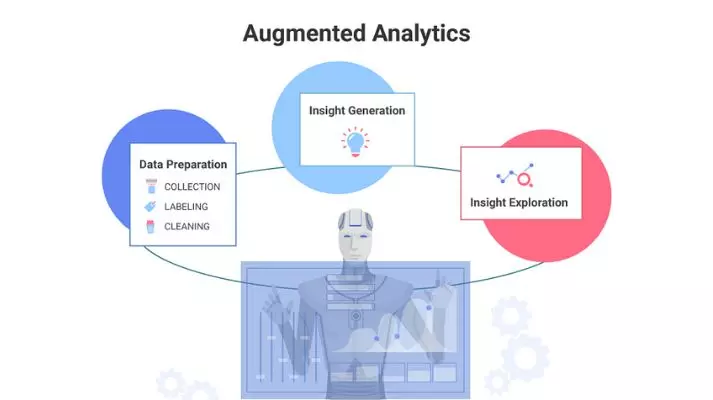

5. Phân tích tăng cường

Phân tích tăng cường là một nhánh phân tích được vận hành bởi AI và học máy để nâng cao khả năng tương tác của con người với dữ liệu theo ngữ cảnh. Xu hướng dữ liệu và phân tích này hỗ trợ trí thông minh của con người và tăng tốc các tác vụ lặp đi lặp lại. Phân tích tăng cường đã trở thành phân tích dự đoán thịnh hành nhất trong thế giới phân tích dữ liệu hiện đại. Phân tích tăng cường sử dụng xử lý ngôn ngữ tự nhiên (NLP) và máy học (ML) để tự động hóa và xử lý dữ liệu.

Các chuyên gia như nhà khoa học dữ liệu trích xuất thông tin chi tiết có giá trị từ phân tích tăng cường để đưa ra quyết định sáng suốt. Độ rõ ràng cao hơn trong thông tin chi tiết về dữ liệu và loại bỏ lỗi cũng như rào cản đã cải thiện việc quản lý dữ liệu, để ra quyết định nhanh chóng và tăng năng suất. Cách tiếp cận dễ dàng khám phá dữ liệu có liên quan và tìm ra thông tin chi tiết có giá trị trong thời gian ngắn này đã khiến nó trở nên phổ biến trong kinh doanh. Người ta cho rằng phân tích tăng cường sẽ đạt 66,54 tỷ đô la vào năm 2030 trên thị trường toàn cầu.

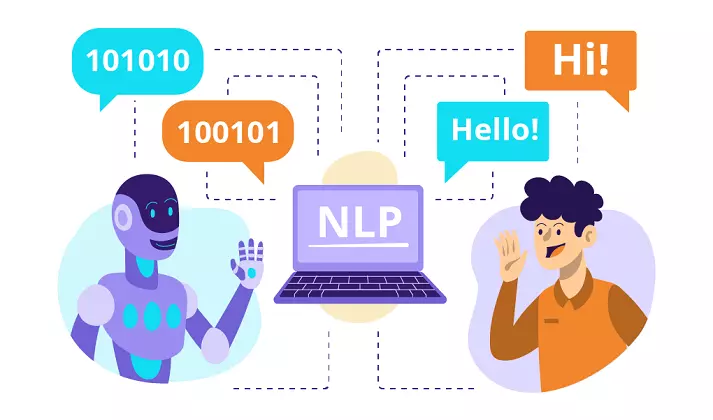

6. Natural Language Processing (NLP)

Xử lý ngôn ngữ tự nhiên (NLP) đã đóng vai trò quan trọng trong tương tác giữa ngôn ngữ của con người và máy tính. Đây là một lĩnh vực phụ của ý thức do con người tạo ra, kỹ thuật phần mềm và ngữ nghĩa giúp lập trình máy tính. Trong phân tích dữ liệu, NLP hỗ trợ tìm kiếm, đánh giá và xử lý lượng lớn dữ liệu có nguồn gốc từ ngôn ngữ tự nhiên.

NLP giúp máy có thể diễn giải nhiều ngôn ngữ khác nhau để chúng có thể phục vụ nhiều chức năng, chẳng hạn như phân tích tình cảm, chatbot, dịch ngôn ngữ và các chức năng khác. Khả năng hiểu và xử lý dữ liệu phi cấu trúc mà con người nhận được khiến nó trở nên có nhu cầu trong xu hướng phân tích dữ liệu thị trường toàn cầu.

Trên đây là những xu hướng phân tích dữ liệu hàng đầu trong năm 2025. Hy vọng rằng các thông tin được cung cấp trong bài sẽ hữu ích với bạn đọc. Đừng quên đón xem các bài viết mới nhất sẽ được cập nhật thường xuyên tại BAC's Blog.

All rights reserved