Mở rộng Tương tác thay vì Tham số: Hướng dẫn Thực hành MiroThinker 1.5

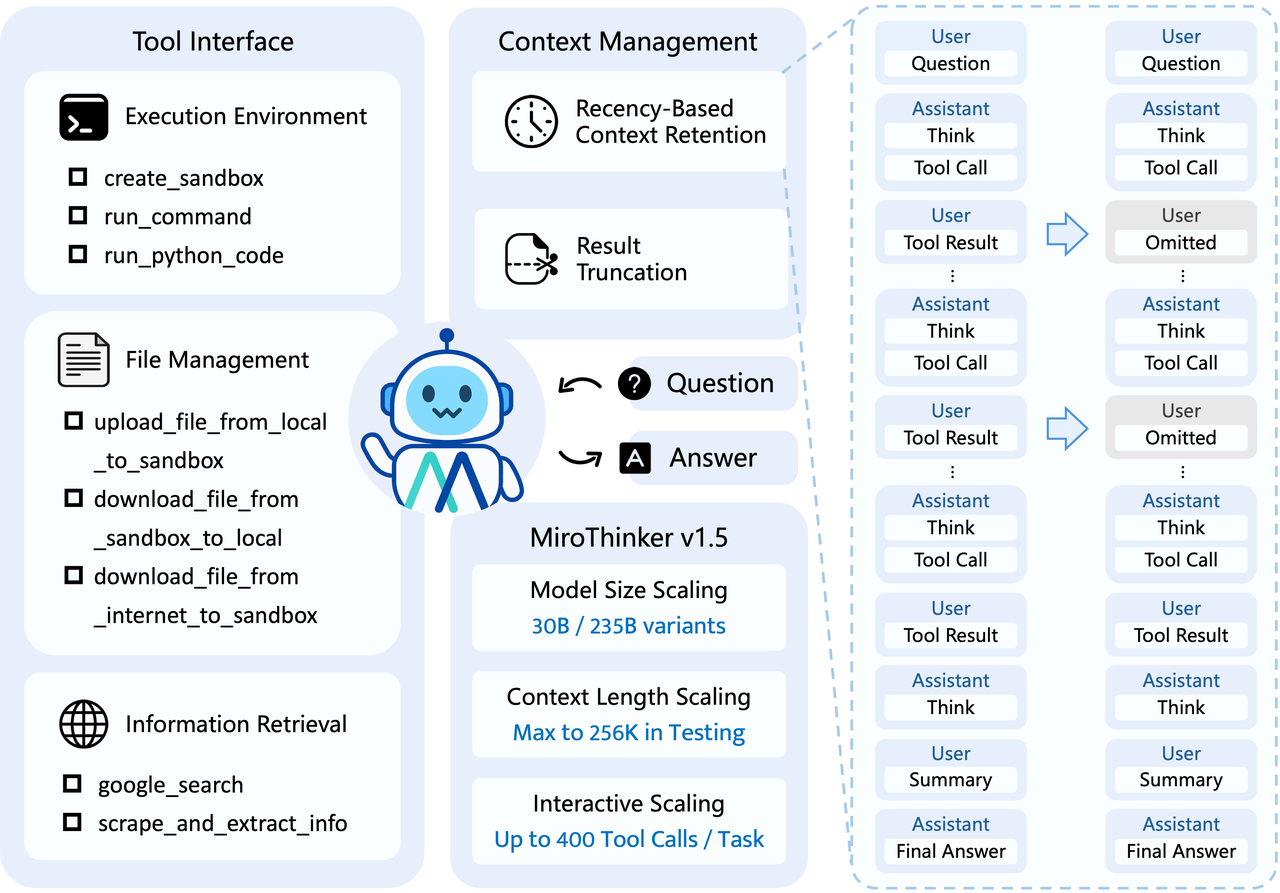

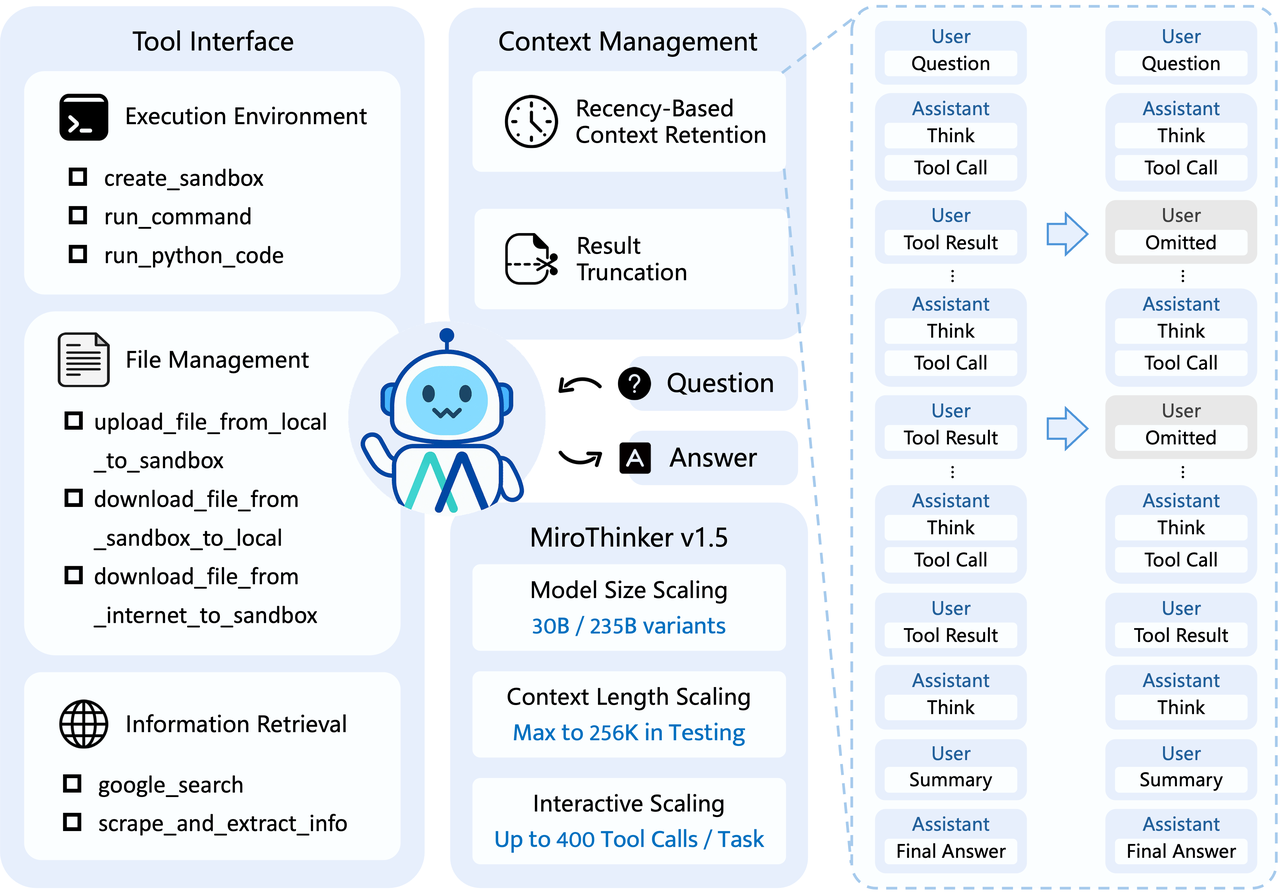

Trong khi Operator và Deep Research của OpenAI vẫn đang trong giai đoạn thử nghiệm giới hạn (limited beta), cộng đồng mã nguồn mở không hề ngồi yên. Gần đây, đội ngũ MiroMind AI đã phát hành một Agent nghiên cứu sâu (deep research) mã nguồn mở — MiroThinker 1.5, tuyên bố giải quyết vấn đề thông qua sự suy ngẫm (reflection) thay vì chỉ đơn thuần nhồi nhét tham số.

Khác với các mô hình trước đây cải thiện hiệu suất chỉ bằng cách tăng lượng tham số, MiroThinker 1.5 giới thiệu khái niệm Interactive Scaling (Mở rộng Tương tác). Điều này cho phép agent cải thiện khả năng giải quyết các vấn đề phức tạp thông qua việc tương tác lặp đi lặp lại với môi trường, thử-sai và suy ngẫm.

Các Đột phá Kỹ thuật của MiroThinker 1.5

MiroThinker 1.5 được phát hành với hai kích thước tham số là 30B và 235B. Logic cốt lõi của nó nằm ở việc mở rộng trí tuệ từ bên trong mô hình ra thế giới bên ngoài, xử lý các tác vụ dài hạn thông qua vòng lặp "Suy luận - Xác minh - Hiệu chỉnh".

1. Mô hình Interactive Scaling

Hầu hết các LLM hiện nay hoạt động ở "chế độ đi thi" (exam-taker mode), cung cấp câu trả lời ngay lập tức (one-shot). MiroThinker không chỉ dựa vào kiến thức nội tại của mô hình mà còn nhấn mạnh vào các tương tác sâu nhiều lượt trong môi trường.

- Suy luận dài hạn (Long-horizon reasoning): Hỗ trợ cửa sổ ngữ cảnh 256K, cho phép xử lý lượng thông tin khổng lồ.

- Sử dụng công cụ tần suất cao: Hỗ trợ lên đến 400 lần gọi công cụ cho mỗi tác vụ đơn lẻ, vượt xa các agent mã nguồn mở tương tự.

2. Hiệu năng

Theo dữ liệu chính thức, phiên bản MiroThinker-v1.5-30B đã đánh bại Kimi-K2-Thinking trên chuẩn đánh giá hiểu web tiếng Trung (BrowseComp-ZH) với kích thước tham số nhỏ hơn và chi phí suy luận chỉ bằng 1/20.

Phiên bản lớn hơn 235B đạt điểm số ấn tượng 80.8% trên GAIA-Val-165 (một chuẩn đánh giá Trợ lý AI Tổng quát), xếp vào hàng top đầu trong các bài kiểm tra như HLE-Text và BrowseComp.

3. Đào tạo Nhạy cảm với Thời gian

Để giải quyết vấn đề "ảo giác tiết lộ trước" (spoiler hallucinations) trong các tác vụ dự đoán, đội ngũ phát triển đã tuân thủ nghiêm ngặt luật nhân quả trong quá trình đào tạo, đảm bảo mô hình "chỉ có thể nhìn thấy quá khứ, không được nhìn thấy tương lai". Thiết kế này mang lại cho MiroThinker giá trị thực tế trong các kịch bản như dự đoán tài chính và phân tích xu hướng thị trường. Đây là lý do tại sao nó có thể dự đoán thành công các mã cổ phiếu A-share tăng trần và xu hướng phát hành GTA 6.

Hướng dẫn Cài đặt Nhanh

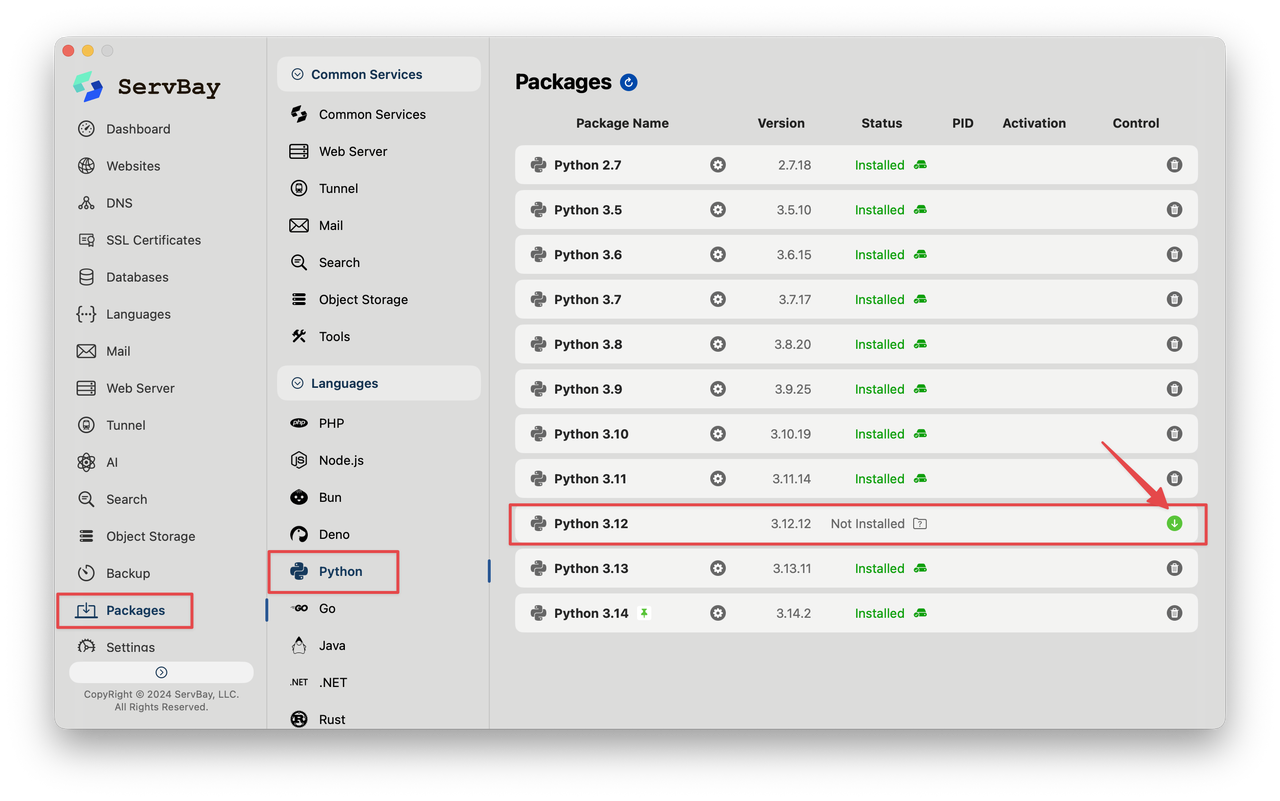

MiroThinker là một Agent sử dụng rất nhiều công cụ, và tài liệu chính thức yêu cầu nghiêm ngặt Python 3.10+. Để giúp bạn tiết kiệm công sức cấu hình biến môi trường và tránh làm hỏng hệ thống cục bộ do xung đột phiên bản, tôi khuyên bạn nên sử dụng ServBay để quản lý môi trường Python. Đây là cách nhanh nhất để bắt đầu và chạy thử.

Bước 1: Chuẩn bị Môi trường Python

- Mở ServBay và tìm Python trong bảng điều khiển "Packages" (Gói phần mềm).

- Chọn Python 3.10 (hoặc phiên bản cao hơn) và nhấp vào nút màu xanh để cài đặt.

- Sau khi cài đặt xong, môi trường Python đã sẵn sàng ngay lập tức — không cần phải chỉnh sửa thủ công các biến Path.

Bước 2: Clone Code & Cài đặt Thư viện phụ thuộc

Khi môi trường đã sẵn sàng, bạn có thể kéo mã nguồn về và cài đặt các thư viện phụ thuộc qua terminal:

# Clone kho lưu trữ

git clone https://github.com/MiroMindAI/MiroThinker

cd MiroThinker

# Vào thư mục Agent

cd apps/miroflow-agent

# Cài đặt thư viện (đảm bảo đã cài uv)

uv sync

Bước 3: Cấu hình API Key

Sức mạnh của MiroThinker dựa vào các công cụ bên ngoài (như tìm kiếm và thực thi mã). Bạn cần sao chép file cấu hình và điền các Key tương ứng:

cp .env.example .env

Trong file .env, bạn cần cấu hình ít nhất các dịch vụ cơ bản sau:

- SERPER_API_KEY: Dành cho Google Search.

- JINA_API_KEY: Dành cho việc cào (scrape) và tóm tắt nội dung web.

- E2B_API_KEY: Cung cấp môi trường sandbox an toàn để thực thi mã Python.

- SUMMARY_LLM: Một LLM dùng để trích xuất thông tin (bạn có thể dùng các mô hình nhẹ như Qwen3-14B).

Khởi động & Chạy

Sau khi cấu hình xong, bạn có thể chạy một tác vụ đơn giản qua dòng lệnh để kiểm tra xem Agent có hoạt động bình thường không:

# Chạy chương trình chính bằng uv

# Giả sử bạn đã triển khai mô hình MiroThinker cục bộ hoặc từ xa (ví dụ: qua vLLM)

uv run python main.py llm=qwen-3 agent=mirothinker_v1.5_keep5_max200 llm.base_url=http://localhost:61002/v1

Nếu VRAM cục bộ của bạn không đủ để chạy mô hình 30B, bạn có thể sử dụng chế độ API (kết nối với Claude hoặc GPT) để trải nghiệm quy trình tư duy của nó trước.

# Sử dụng Claude (cần cấu hình ANTHROPIC_API_KEY)

uv run python main.py llm=claude-3-7 agent=single_agent_keep5

Lời kết

MiroThinker 1.5 cho tôi cảm giác rằng cộng đồng mã nguồn mở cuối cùng cũng bắt đầu tập trung vào "Hệ thống 2" (tư duy chậm). Mặc dù việc cấu hình Key có chút tẻ nhạt, nhưng việc xem Agent thực hiện từng bước "Suy luận - Xác minh - Hiệu chỉnh" trong terminal mang lại cảm giác rất khác biệt so với các LLM chỉ biết "chém gió" (hallucinate) ra câu trả lời.

Nếu bạn có các tác vụ nghiên cứu phức tạp hoặc muốn tìm hiểu cách giảm thiểu ảo giác của AI, hãy sử dụng ServBay để dựng nhanh một môi trường trong vài phút và chạy thử. Rốt cuộc, một AI biết "thừa nhận mình không biết và đi kiểm chứng" mới là thứ chúng ta thực sự cần.

All rights reserved