Apache Spark #1: kiến thức cơ bản về nền tảng của Apache Spark

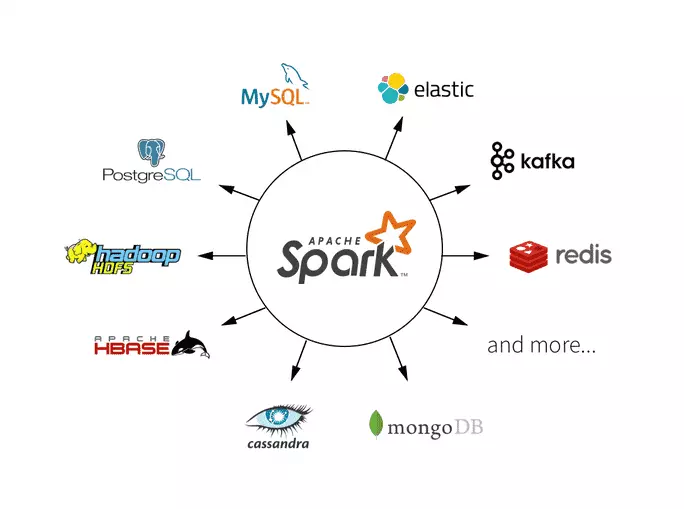

Apache Spark là một nền tảng phân tích dữ liệu mạnh mẽ và phổ biến trong lĩnh vực Big Data. Được phát triển bởi Apache Software Foundation, Spark cung cấp một cách tiếp cận linh hoạt để xử lý dữ liệu lớn, với khả năng xử lý nhanh chóng và hiệu quả. Trong bài viết này, chúng ta sẽ tìm hiểu về nền tảng cơ bản của Apache Spark và cách nó hoạt động.

Apache Spark là gì?

Apache Spark là một nền tảng tính toán phân tán mã nguồn mở, được thiết kế để xử lý và phân tích dữ liệu lớn. Nó cung cấp một giao diện lập trình dễ sử dụng cho việc xử lý dữ liệu phân tán trên các cụm máy tính, bao gồm cả việc xử lý batch và xử lý dữ liệu dòng (streaming data).

Các thành phần chính của Apache Spark

Apache Spark bao gồm các thành phần cơ bản sau:

-

Resilient Distributed Datasets (RDDs): RDDs là một cấu trúc dữ liệu cơ bản trong Apache Spark, cho phép bạn làm việc với dữ liệu phân tán trong bộ nhớ. RDDs có tính chất chịu sự cố và có thể được tính toán lại trong trường hợp lỗi.

-

DataFrames: DataFrames là một API cho phép bạn làm việc với dữ liệu dưới dạng các hàng và cột, tương tự như trong các bảng trong cơ sở dữ liệu quan hệ. DataFrames cung cấp các phương thức linh hoạt cho việc truy vấn và biến đổi dữ liệu.

-

Datasets: Datasets là một API mạnh mẽ hơn cho việc làm việc với dữ liệu so với RDDs và DataFrames. Chúng kết hợp tính linh hoạt của RDDs với sự tối ưu hóa của DataFrames.

-

Spark SQL: Spark SQL cung cấp một giao diện để truy vấn dữ liệu bằng ngôn ngữ SQL trên Apache Spark. Điều này cho phép bạn thực hiện các truy vấn phức tạp trên dữ liệu của mình một cách dễ dàng.

-

MLlib: MLlib là một thư viện machine learning tích hợp trong Apache Spark, cung cấp các thuật toán và công cụ để xây dựng và huấn luyện các mô hình machine learning trên dữ liệu lớn.

-

Spark Streaming: Spark Streaming cho phép bạn xử lý và phân tích dữ liệu dòng (streaming data) trong thời gian thực, giúp bạn đưa ra các quyết định nhanh chóng dựa trên dữ liệu mới nhất.

Kết luận

Apache Spark là một công cụ mạnh mẽ cho việc xử lý và phân tích dữ liệu lớn, với các tính năng linh hoạt và hiệu suất cao. Bằng cách hiểu về nền tảng cơ bản của Apache Spark và các thành phần chính của nó, bạn có thể sử dụng công cụ này một cách hiệu quả để giải quyết các vấn đề phức tạp trong lĩnh vực Big Data.

All rights reserved