Tổng quan đơn giản về Stack hiện đại dành cho Developer RAG

Retrieval-Augmented Generation (RAG – Tạo sinh có hỗ trợ truy xuất) là nền tảng của nhiều ứng dụng AI tiên tiến hiện nay. Dưới đây là một bản tóm lược ngắn gọn nhưng đầy đủ chi tiết về stack hiện đại dành cho developer RAG – tất cả những gì bạn cần để kết nối các mô hình ngôn ngữ lớn (LLM), cơ sở tri thức và pipeline có thể vận hành thực tế.

1. LLM (Mô hình ngôn ngữ lớn)

Bạn cần một “bộ não” chất lượng cao cho hệ thống RAG của mình. Có hai lựa chọn:

Mô hình mã nguồn mở (ví dụ: Llama 3.3, Mistral)

- Ưu điểm: Không mất phí theo lần gọi API, toàn quyền tùy chỉnh, có thể triển khai nội bộ để đảm bảo quyền riêng tư dữ liệu.

- Nhược điểm: Bạn phải tự xử lý việc host, mở rộng và cập nhật.

Mô hình dựa trên API (GPT-4 của OpenAI, Claude của Anthropic, Gemini của Google)

- Ưu điểm: Không cần máy chủ, luôn cập nhật mới nhất, có SLA.

- Nhược điểm: Chi phí tăng theo quy mô; có rủi ro về vị trí lưu trữ dữ liệu.

👉 Gợi ý: Bắt đầu với mô hình mã nguồn mở chạy cục bộ (như Llama 3.3 trên Ollama), rồi chuyển sang dùng API khi lưu lượng truy cập tăng.

2. Frameworks

Kết nối các thành phần nhanh chóng – đừng tự xây lại bánh xe:

LangChain

- Cung cấp: chuỗi (pipeline kết hợp prompt + logic), agent (ra quyết định), công cụ tích hợp (tìm kiếm, máy tính).

from langchain import LLMChain, PromptTemplate

from langchain.llms import OpenAI

template = PromptTemplate.from_template("Summarize: {text}")

chain = LLMChain(llm=OpenAI(), prompt=template)

print(chain.run(text="LangChain makes RAG easy!"))

LlamaIndex (trước đây là GPT Index)

- Tạo chỉ mục tài liệu để truy xuất nhanh, hỗ trợ embedding tùy chỉnh và các chế độ truy vấn khác nhau.

Haystack

- Giải pháp RAG từ đầu đến cuối: Pipelines, Kho tài liệu, API suy luận – phù hợp cho tìm kiếm đa phương thức (text, PDF, hình ảnh).

💡 Pro tip: Kết hợp linh hoạt – dùng document store của Haystack với chuỗi của LangChain để tối đa hóa khả năng tuỳ chỉnh.

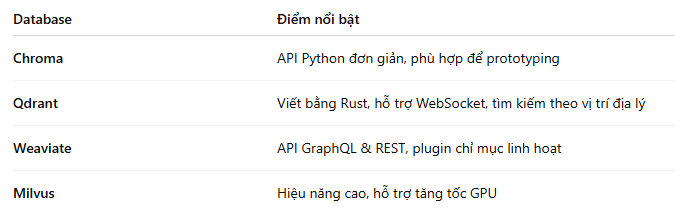

3. Cơ sở dữ liệu Vector

Dữ liệu đã chia nhỏ (chunk) cần được lưu trữ và truy xuất nhanh bằng tìm kiếm tương đồng.

✅ Tiêu chí chọn: tốc độ truy vấn, tốc độ lập chỉ mục, chi phí lưu trữ, hỗ trợ đa người dùng. Luôn benchmark với dữ liệu của bạn!

4. Trích xuất dữ liệu

RAG cần nạp kiến thức từ nhiều nguồn:

- Web scraping: Dùng FireCrawl, MegaParser (xử lý web render bằng JavaScript).

- Phân tích tài liệu: Dùng Docling, Apache Tika hoặc PDFMiner để lấy nội dung từ PDF, DOCX, v.v.

- API & cơ sở dữ liệu: Viết connector tùy chỉnh (GraphQL, SQL, NoSQL).

🛠 Quy trình: crawl → clean → chunk → embed. Tự động hóa pipeline ETL bằng Airflow, Dagster,...

5. Lớp Truy Cập LLM

Tách biệt code với nhà cung cấp cụ thể:

- Open LLM Hosts: Hugging Face, Ollama (container cục bộ), Together AI.

- Cloud Providers: OpenAI, Vertex AI (Google), Claude (Anthropic).

📌 Tại sao quan trọng: thay đổi nhà cung cấp chỉ cần sửa 1 dòng config.

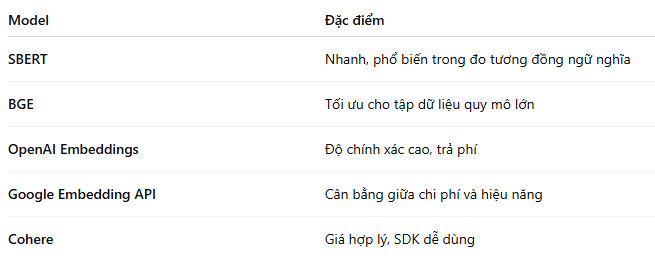

6. Embedding văn bản

Chất lượng truy xuất phụ thuộc vào embedding:

7. Đánh giá

Không thể cải thiện nếu không đo lường. Dùng các công cụ và chỉ số sau:

Công cụ:

- RAGas: đánh giá toàn trình.

- Giskard: kiểm thử mô hình, giải thích, phát hiện bias.

- TruLens: quan sát LLM – theo dõi prompt, token, kết quả.

Chỉ số:

- Liên quan: Precision@k, Recall@k

- Chính xác: Exact match, ROUGE, BLEU

- Hiệu suất: Thời gian phản hồi trung bình, số token mỗi truy vấn

- Chất lượng: Đánh giá thủ công, tính mạch lạc, tỷ lệ "ảo tưởng" (hallucination)

📊 Gợi ý: log chỉ số lên Grafana/Prometheus để theo dõi liên tục.

Visual Overview

+------------+ +--------------+ +-------------+

| LLM/API |<--->| Framework |<--->| Vector DB |

+------------+ +--------------+ +-------------+

↑ ↑ ↑

Access Layer Chains & Embeds Agents

(OpenAI, HF) (SBERT, BGE)

↓ ↓ ↓

+-----------------------------------------------+

| Data Extraction → ETL → Chunking |

+-----------------------------------------------+

↓

Evaluation

(RAGas, Giskard, TruLens / Metrics)

Kết luận

Dù bạn đang thử nghiệm hay chuẩn bị mở rộng quy mô, stack RAG hiện đại này sẽ giúp bạn có đầy đủ công cụ để xây dựng các ứng dụng AI hiệu suất cao, đáng tin cậy.

All rights reserved