Tìm hiểu về giải pháp Digital Humans phần 2: RAD-NeRF mô hình tổng hợp chân dung có thể đối thoại theo thời gian thực

Trước khi vào bài, hãy cùng xem qua những RAD-NeRF có thể làm được:

Lưu ý: bài đọc yêu cầu cần có kiến thức về NeRF, mọi người hãy đọc phần 1 ở đây để hiểu rõ hơn nhé!

Từ một video duy nhất, RAD-NeRF có thể tổng hợp được mô hình người có thể nói gần như bất kỳ từ hoặc câu nào trong thời gian thực với chất lượng khá tốt. Chúng ta có thể tạo hoạt ảnh cho phần đầu nói theo bất kỳ bản âm thanh nào trong thời gian thực. Điều này vừa tuyệt vời vừa đáng sợ đúng không?

Hãy tưởng tượng xem điều gì có thể xảy ra nếu mình có thể khiến bạn nói bất cứ điều gì chỉ với 1 video bạn nói trước ống kính trong 5 phút. Hoặc như với VASA-1 của nhóm Microsoft Research mới công bố gần đây gần dây, thậm chí họ chỉ cần một bức ảnh. Chỉ cần thông tin về gương mặt của chúng ta xuất hiện trên mạng xã hội, bất kỳ ai cũng có thể sử dụng mô hình này và tạo ra vô số video quay cảnh bạn nói về bất cứ điều gì họ muốn. Họ thậm chí có thể tổ chức các buổi phát trực tiếp bằng phương pháp này, điều này thậm chí còn nguy hiểm hơn😀.

Quay lại chủ đề chính, làm cách nào họ có thể làm điều đó trong thời gian thực từ bất kỳ âm thanh nào chỉ bằng một video …

1.Bối cảnh chung

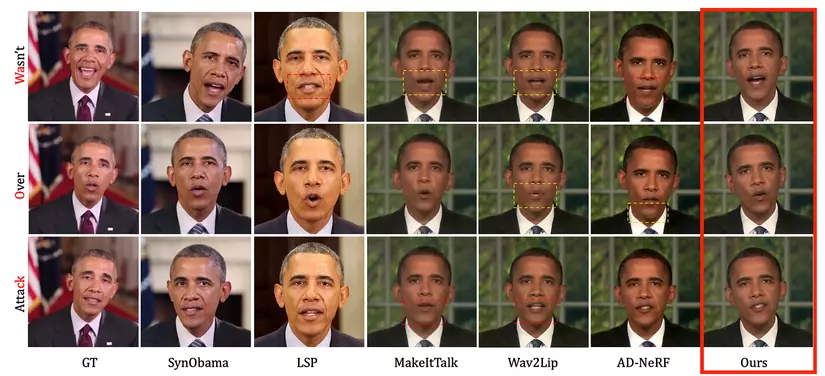

Như nhóm tác giả đã công bố, mô hình RAD-NeRF của họ có thể chạy nhanh hơn 500 lần so với các sản phẩm trước đó với chất lượng hiển thị tốt hơn và khả năng kiểm soát tốt hơn. Làm thế nào điều đó có thể xảy ra? Chúng ta thường đánh đổi chất lượng để lấy hiệu quả, nhưng họ đã cải thiện được cả hai điều đó một cách đáng kinh ngạc. Hãy cùng tìm hiểu nhé.

RAD-NeRF sử dụng mạng nơ ron để dự đoán tất cả màu sắc và mật độ điểm ảnh cho góc nhìn của camera đang được hiển thị. Việc này được thực hiện cho tất cả các góc nhìn mà bạn muốn hiển thị khi camera xoay quanh đối tượng. Việc này đòi hỏi rất nhiều tính toán vì tại mỗi góc nhìn phải học cách dự đoán nhiều góc nhìn khác và các thông số cho từng tọa độ trong ảnh. Ngoài ra, trong trường hợp này, không chỉ NeRF mới tạo ra cảnh 3D. Âm thanh đầu vào cũng phải khớp sao cho môi, miệng, mắt và chuyển động khớp với những gì người đó đang nói. Tức là chúng ta phải tổng hợp trong không gian động.

Các vấn đề chính khi chuyển từ tĩnh sang động

Làm cách nào để RAD-NeRF thể hiện hiệu quả thông tin không gian và giọng nói cùng một lúc?

-

Các đặc trưng âm thanh thường được mã hóa thành vectơ 64 chiều và sau đó được đưa vào MLP chứa tọa độ không gian 3D để dùng training. Tuy nhiên, khi chúng ta cố gắng thêm nhiều chiều hơn (chẳng hạn như âm thanh) vào mô hình NeRF, chúng ta có thể gặp phải vấn đề tăng số lượng tham số theo cấp số nhân. Điều này là do mỗi chiều bổ sung sẽ nhân đôi số lượng điểm dữ liệu mà chúng ta cần để nội suy trong không gian.

-

Ví dụ: trong không gian 2D, nếu bạn muốn có 10 điểm nội suy theo mỗi hướng thì bạn sẽ cần tổng cộng 100 điểm dữ liệu. Nhưng nếu bạn muốn làm điều tương tự trong không gian ba chiều thì bạn cần 1.000 điểm dữ liệu. Điều này có nghĩa là khi chúng ta thêm nhiều chiều hơn, lượng dữ liệu cần được nội suy và xử lý sẽ tăng lên nhanh chóng. Điều này không chỉ làm tăng đáng kể các yêu cầu tính toán mà còn có thể vượt quá khả năng của phần cứng hiện có.

-

Ngoài ra, nội suy trong không gian nhiều chiều cũng gặp phải các thách thức khác: ví dụ, vấn đề “Curse”. “Curse” chỉ ra rằng, trong không gian chiều cao, dữ liệu trở nên thưa thớt, điều này làm cho việc sử dụng phương pháp thống kê hoặc học máy trở nên rất khó khăn.

Việc mô phỏng hiệu quả chuyển động của cơ thể cũng khó khăn. Các phương pháp trước đây hoặc sử dụng NERF đều tốn kém và phức tạp.

Tác giả giải quyết như thế nào?

-

Paper này đề xuất một phương pháp giải quyết không gian âm thanh, cho phép đào tạo và suy luận theo thời gian thực hiệu quả.

-

Tác giả đã tận dụng cách biểu diễn NeRF dựa trên lưới, đưa khả năng mô hình hóa cảnh tĩnh xuất sắc của nó vào mô hình hóa cảnh động do âm thanh điều khiển.

-

Điểm đóng góp chính của paper là việc phân tích các đặc điểm của chân dung nói (talking portrait) thành ba lưới đặc trưng (feature grid) có thể học được với kích thước mô hình nhỏ. Để mô hình hóa phần đầu, tác giả đã phân tách và biểu diễn thành hai lưới đặc trưng, mặc dù tọa độ không gian 3D vẫn không đổi, nhưng chuyển động của âm thanh được mã hóa vào các tọa độ kích thước thấp. Ngoài ra, tác giả còn chứng minh rằng có thể chia thành hai lưới đặc trưng có kích thước thấp riêng biệt thay vì truy vấn âm thanh và tọa độ không gian trong một lưới đặc trưng kích thước cao hơn, điều này làm giảm thêm chi phí nội suy, và giúp mô hình phần đầu nói chuyện hiệu quả hơn.

-

Về phần cơ thể, tác giả nhận thấy rằng chuyển động của cơ thể ít thay đổi hơn, do đó đề xuất một model nhẹ để mô hình hóa cơ thể bằng lưới đặc trưng 2D.

Grid-based NeRF (NeRF dựa trên lưới):

- NeRF mô hình hóa màu sắc và mật độ của các điểm trong không gian ba chiều, từ đó có thể render hình ảnh 2D chân thực từ bất kỳ góc độ nào.

- Grid-based NeRF là một cải tiến của phương pháp NeRF truyền thống. Trong NeRF truyền thống, mạng nơ-ron sẽ gán một giá trị màu sắc và mật độ cho mỗi điểm trong không gian 3D. Tuy nhiên, phương pháp này có thể gặp phải vấn đề về giới hạn bộ nhớ khi xử lý các cảnh quy mô lớn.

- Grid-based NeRF giải quyết vấn đề này. Nó chia không gian 3D thành một lưới và chỉ đánh giá mạng nơ-ron tại các đỉnh lưới, từ đó tối ưu hóa việc sử dụng bộ nhớ. Sau đó, sử dụng kỹ thuật nội suy để lấy giá trị màu sắc và mật độ tại các vị trí giữa các đỉnh lưới. Điều này cho phép xử lý các cảnh quy mô lớn hơn trong khi vẫn giữ được độ chính xác cao.

Tóm lại các điểm khác biệt chính của NeRF dựa trên lưới:

- Sử dụng bộ nhớ: Grid-based NeRF tối ưu hóa việc sử dụng bộ nhớ, cho phép xử lý các cảnh quy mô lớn hơn.

- Hiệu quả tính toán: Do chỉ cần đánh giá mạng nơ-ron tại các đỉnh lưới và sử dụng kỹ thuật nội suy để lấy thông tin vị trí khác, Grid-based NeRF đã cải thiện hiệu quả tính toán.

- Độ chính xác: Mặc dù sử dụng phương pháp đơn giản hóa, Grid-based NeRF vẫn có thể duy trì độ chính xác cao trong nhiều ứng dụng.

2.Phương pháp

2.1 Một số khái niệm cần biết

1. NeRF

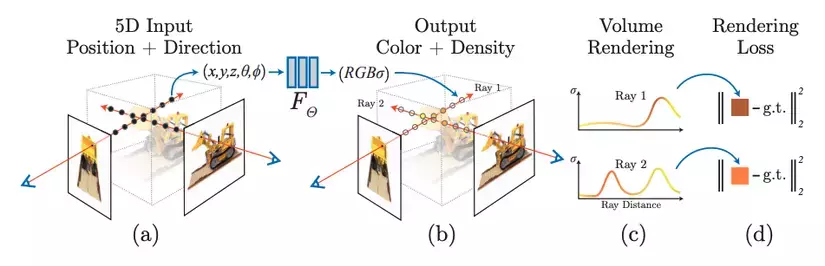

Tóm tắt chung thì NeRF sử dụng tọa độ 5 chiều để biểu diễn cảnh 3D, tức là một hàm 𝐹 : 𝑥 , 𝑑 → 𝜎 , 𝑐 . Trong đó:

- là tọa độ 3D,

- là hướng nhìn,

- là mật độ màu.

- là màu phát ra.

Giả sử một tia phát ra từ , di chuyển theo hướng , chúng ta sử dụng hàm tại các điểm được lấy mẫu tuần tự dọc theo tia để tính toán mật độ và màu sắc . Màu của pixel tương ứng với tia được tính bằng công thức:

Trong đó:

- là đại diện cho xác suất mà tia không chạm vào bất cứ vật thể gì tính từ tâm quang học tới điểm lấy mẫu.

- là độ mờ.

- là khoảng cách giữa 2 điểm lấy mẫu liên tiếp.

Để hiểu kĩ hơn về NeRF mọi người có thể tham khảo phần 1 ở đây.

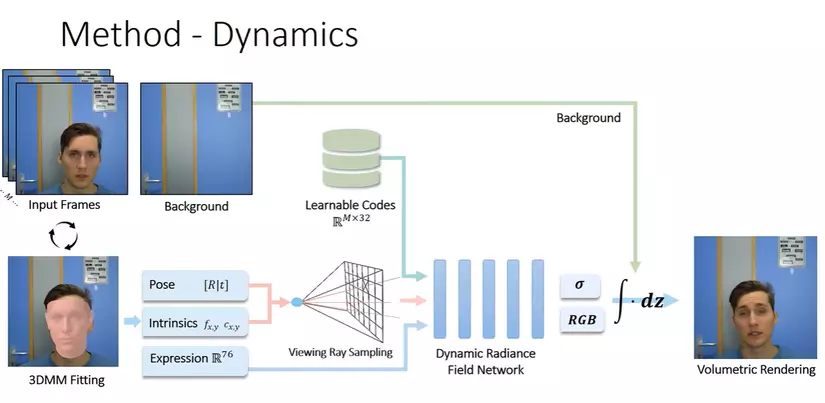

2. Dynamic NeRF:

Cảnh động so với cảnh tĩnh sẽ tăng thêm một số điều kiện bổ sung, chẳng hạn như thời gian hiện tại

Các phương pháp trước đây chủ yếu có hai cách giải quyết:

-

Sử dụng phương pháp dựa trên biến dạng (deformation-based) để học một biến dạng và bước thời gian tại mỗi vị trí, sau đó thêm vào vị trí. Tuy nhiên, phương pháp này không phù hợp cho việc mô hình hóa chuyển động cục bộ, như chuyển động của môi. Nhưng có thể dùng để mô hình hóa chuyển động của vai.

-

Sử dụng phương pháp dựa trên điều biến (modulation-based), trực tiếp đưa thời gian t vào NeRF, và huấn luyện cùng với vị trí, hướng. Trong paper, nhóm tác giả chọn phương pháp này để mô hình hóa phần đầu và deformation-based để mô hình hóa phần thân với các mẫu chuyển động đơn giản hơn.

- Dynamic NeRF sử dụng thêm một đặc trưng Expression để điều khiển cử động của nhân vật

- Dynamic NeRF tách phần background nhằm tránh làm background bị biến dạng hoặc quá mờ trong quá trình sinh.

- Ngoài ra Dynamic NeRF thêm một đặc trưng có thể học (Learnable Codes) được làm đầu vào của MLP, khiến chất lượng hình ảnh được render tốt hơn

3. Chuẩn bị dữ liệu

Định dạng chung của dữ liệu tổng hợp chân dung người nói chuyện thường là như sau:

Thông thường chung ta sẽ sử dụng video của một người nói chuyện cố định trước camera trong 3-5 phút với âm thanh liên tục. Sau đó video được tách thành video(không có tiếng) và âm thanh, mỗi phần được xử lý riêng.

Xử lý từng khung hình:

- Thực hiện segmentation cho các vùng đầu, cổ, thân và nền.

- Trích xuất các đặc trưng khuôn mặt 2D, bao gồm các đặc trưng của mắt và môi.

- Thực hiện face-tracking (theo dõi khuôn mặt) để ước lượng các tham số tư thế đầu.

Xử lý âm thanh:

Sử dụng mô hình Nhận dạng Giọng nói Tự động (Automatic Speech Recognition - ASR) để trích xuất các đặc trưng âm thanh. Các đặc trưng này sẽ được sử dụng để đồng bộ hóa chuyển động của môi và biểu cảm khuôn mặt với giọng nói trong video, tạo ra một video nói chuyện chân thực.

Dữ liệu sau khi chuẩn bị thành công sẽ trông như này:

4. Grid-based NeRF

NeRF dựa trên lưới (Grid-based NeRF) sử dụng bộ mã hóa lưới đặc trưng 3D để mã hóa thông tin không gian 3D của cảnh tĩnh.

Bộ mã hóa lưới đặc trưng 3D:

Công thức:

- là bộ mã hóa lưới đặc trưng 3D.

- là đặc trưng không gian 3D sau khi mã hóa

- là tọa độ trong không gian 3D ban đầu.

Quá trình xử lý này có thể tăng tốc quá trình đào tạo và suy luận, giúp xử lý cảnh 3D trong thời gian thực.

Tuy nhiên, các phương pháp Grid-based NeRF này vẫn yêu cầu thời gian tái tạo lâu và thậm chí dẫn đến chi phí bộ nhớ cao, làm mất đi tính nhỏ gọn của NeRF. Dựa trên Grid-based, nhóm tác giả đã đề xuất một cách biểu diễn cảnh tensor mới là TensoRF, tận dụng các kỹ thuật phân tích tensor (tensor factorization), dẫn đến quá trình tái tạo nhanh và mô hình nhỏ gọn hơn.

Để hiểu kĩ hơn mọi người tham khảo ở đây nhé.

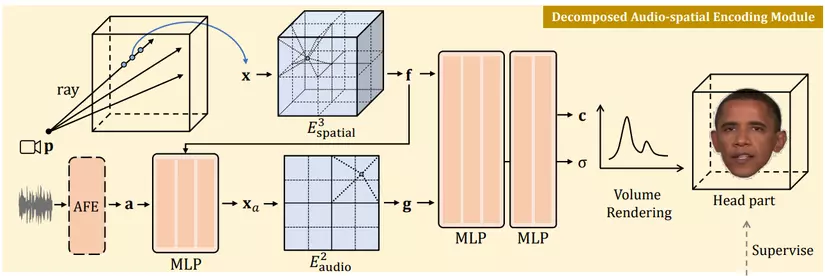

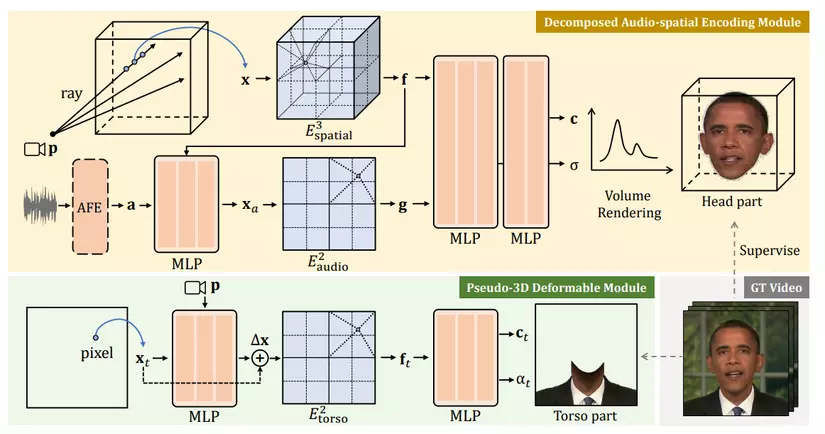

2.2 Decomposed audio-spatial encoding module (Mô-đun mã hóa audio-không gian)

Phương pháp NeRF ẩn trước đây thường mã hóa tín hiệu âm thanh trực tiếp vào các đặc trưng, sau đó kết hợp với các đặc trưng không gian có nhiều chiều. Tuy nhiên, cách này đối với NeRF dựa trên lưới thì rất tốn kém như đã giải thích ở trên, vì vậy tác giả của bài báo này đã đề xuất cách tiếp cận khác

Đầu tiên, nén các đặc trưng âm thanh cao chiều thành tọa độ âm thanh thấp chiều , với rất nhỏ. Cách thực hiện là sử dụng:

Sau đó, mã hóa lưới audio-không gian được tách thành hai bộ mã hóa lưới để mã hóa riêng biệt audio và không gian, rồi kết hợp chúng lại.

Điều này làm giảm chi phí nội suy từ xuống với

- : Đây là bộ mã hóa lưới đặc trưng không gian 3D, mã hóa thông tin không gian từ tọa độ không gian 3D thành đặc trưng không gian

- : Đây là bộ mã hóa lưới đặc trưng âm thanh D chiều, mã hóa thông tin âm thanh từ tọa độ âm thanh thấp chiều thành đặc trưng âm thanh .

Việc tách biệt này giúp giảm đáng kể chi phí nội suy, đặc biệt là đối với các cảnh 3D.

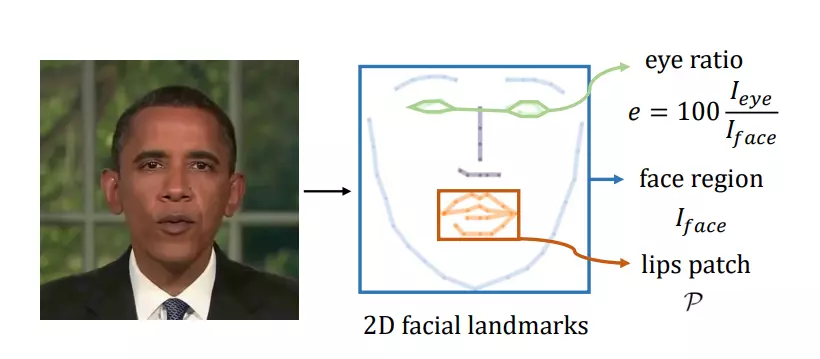

Về vấn đề kiểm soát chớp mắt

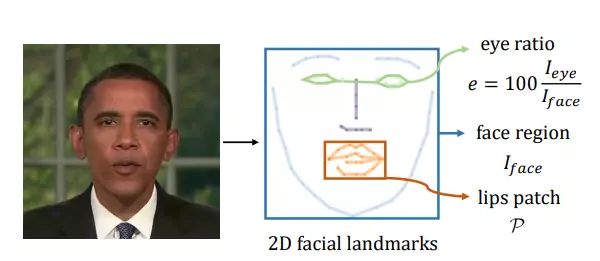

Chớp mắt cũng rất quan trọng đối với việc tổng hợp người số thực tế. Tuy nhiên, do chớp mắt không liên quan nhiều đến âm thanh, nhiều phương pháp trước đây đã bỏ qua việc chớp mắt. Bài báo này đề xuất một phương pháp để kiểm soát chớp mắt, như trong hình:

Đầu tiên, tính toán tỉ lệ diện tích mắt trong tổng diện tích khuôn mặt, sau đó sử dụng tỉ lệ này (thường từ 0% đến 0.5%) như một đặc trưng mắt một chiều .

Sau đó, sử dụng đặc trưng mắt này làm điều kiện cho NeRF để đưa vào quá trình huấn luyện NeRF.

Hình trên minh họa một ví dụ về thông tin điểm đặc trưng. Dựa trên các điểm đặc trưng khuôn mặt 2D, nhóm tác giả đã trích xuất ba đặc trưng để hỗ trợ huấn luyện:

- Tỉ lệ mắt : được tính toán bằng công thức

- Vùng khuôn mặt : sử dụng cho việc điều chỉnh động.

- Vùng môi : sử dụng cho việc tinh chỉnh môi. Các bước này giúp cải thiện khả năng tổng hợp các chuyển động của mắt và môi.

Tổng quát về biểu diễn phần đầu

- Đặc trưng không gian

- Đặc trưng âm thanh

- Đặc trưng mắt

- Đặc trưng tiềm ẩn về diện mạo : Đặc trưng này có thể được học bởi mạng nơ ron nhằm tránh mất mát thông tin do ảnh hưởng từ môi trường trong video. Mọi người có thể tham khảo thêm về đặc trưng này ở 2 paper: https://arxiv.org/pdf/2012.03065 và https://arxiv.org/pdf/2008.02268

Khi đã có các đặc trưng trên, ta có thể sử dụng một MLP nhỏ để dự đoán màu sắc và mật độ tại từng điểm lấy mẫu:

Sau đó có thể sử dụng phương trình quen thuộc dưới để thực hiện kết xuất thể tích nhằm tính toán màu sắc tại mỗi pixcel và tổng hợp phần đầu.

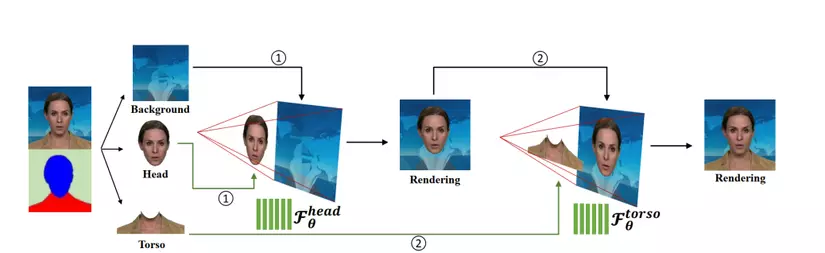

2.3 Pseudo-3D Deformable Module (Mô-đun biến dạng Pseudo-3D)

Trái ngược với phần đầu, phần thân gần như tĩnh, chỉ chứa các chuyển động nhẹ mà không có sự thay đổi quá nhiều về hình dạng. Các phương pháp trước đây sử dụng tài nguyên quá mức cần thiết vào việc tái thiết phần thân, và paper đề xuất một Pseudo-3D Deformable Module hiệu quả hơn, như hình trên.

Thay vì lấy mẫu một loạt các điểm dọc theo mỗi tia camera, chúng ta chỉ cần lấy mẫu một tọa độ pixel duy nhất từ không gian ảnh. Chuyển động của phần thân được điều khiển dựa trên trên tư thế đầu sao cho chuyển động của thân đồng bộ với chuyển động đầu. Nhóm tác giả áp dụng một MLP để dự đoán biến dạng: .

Tọa độ bị biến dạng được đưa vào bộ mã hóa lưới đặc trưng 2D để lấy đặc trưng của thân:

Một MLP khác được sử dụng để tạo ra màu RGB và giá trị alpha của thân:

Trong đó là mã hóa tiềm ẩn về diện mạo để tăng thêm hiệu suất cho mô hình.

Việc biểu diễn Pseudo-3D thông qua lưới đặc trưng 2D là rất nhẹ và hiệu quả. Các hình ảnh của đầu và thân được tạo riêng rẽ có thể được kết hợp với bất kỳ hình ảnh nền nào để tạo ra hình ảnh chân dung cuối cùng vô cùng chân thực.

2.4 Trainning

Maximum Occupancy Grid Pruning.

Một kỹ thuật phổ biến để cải thiện hiệu quả của NeRF là việc lưu lại Lưới Chiếm Chỗ(Occupancy Grid) chứa vật thể để cắt bớt không gian lấy mẫu tia. Điều này rất đơn giản đối với các cảnh tĩnh. Vì lưới cũng ở trạng thái tĩnh nên chúng ta có thể sử dụng lưới 3D để lưu trữ. Nhưng đối với các cảnh động, giá trị phần chiếm chỗ cũng phụ thuộc vào các điều kiện động, đòi hỏi lưới chiếm chỗ có chiều cao hơn khó lưu trữ và bảo trì hơn, dẫn đến kích thước mô hình và thời gian đào tạo tăng lên đáng kể.

Paper chỉ ra rằng sự thay đổi về chất lượng do thay đổi âm thanh thường nhỏ và không đáng kể. Do đó, thay vì lưu lưới chiếm chỗ cho từng âm thanh, paper đề xuất lưu lưới chiếm chỗ tối đa tại tất cả điều kiện âm thanh. Trong quá trình đào tạo, mẫu ngẫu nhiên các mẫu âm thanh từ tập dữ liệu huấn luyện và giữ giá trị chiếm dụng ở mức tối đa. Bằng cách này, chúng ta chỉ cần một lưới 3D để lưu trữ các giá trị chiếm chỗ và có thể cắt tỉa thành công không gian lấy mẫu tia trong các điều kiện âm thanh khác nhau.

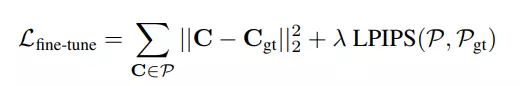

Loss function

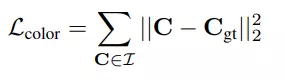

Hàm Lỗi vẫn sẽ sử dụng MSE giống NeRF truyền thống:

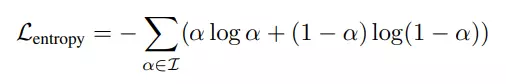

Ngoài ra, bằng cách sử dụng entropy regularization để ép các giá trị độ trong suốt của điểm ảnh vào hai giá trị rời rạc (0 hoặc 1), thay vì cho phép chúng nằm ở các giá trị trung gian, từ đó tạo ra một kết quả rõ ràng và sắc nét hơn.

trong đó là độ trong của mỗi pixel.

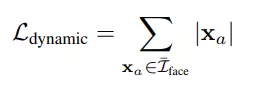

Điều kiện âm thanh chỉ nên ảnh hưởng đến vùng khuôn mặt. Để ổn định mô hình nói chuyện, RAD-NeRF chỉ sử dụng chuẩn L1 để tính lỗi phần tọa độ âm thanh:

Cho ai quên là gì thì quay lại phần 2.2 nha 😆

Ngoài ra việc áp dụng L1 này giúp tọa độ âm thanh tiến gần đến 0 ở vùng không phải khuôn mặt , giúp tránh các hiện tượng nhấp nháy không mong muốn bên ngoài vùng khuôn mặt, chẳng hạn như tóc và tai. Vùng khuôn mặt có thể được định vị trực tiếp bởi các điểm mốc 2D.

Hàm loss dùng để huấn luyện phần môi:

Môi chất lượng cao là yếu tố quan trọng để làm cho chân dung tổng hợp trở nên tự nhiên. Thông tin cấu trúc phức tạp của môi khó có thể học được chỉ thông qua hàm mất mát MSE của các pixel ảnh. Do đó, nhóm tác giả đề xuất tinh chỉnh các vùng môi bằng các hàm mất mát cấu trúc theo mảnh, ví dụ như hàm mất mát LPIPS. Thay vì lấy mẫu ngẫu nhiên các điểm ảnh từ toàn bộ hình ảnh như trong quy trình huấn luyện NeRF thông thường, RAD-NeRF lấy mẫu một mảnh hình ảnh nơi có môi dựa trên các điểm mốc khuôn mặt. Sau đó, áp dụng sự kết hợp của hàm mất mát với hàm mất mát MSE được cân bằng bởi .

- : Đây là thành phần MSE tính loss giữa các điểm danh trong vùng môi

- : Đây là thành phần mất mát LPIPS (Learned Perceptual Image Patch Similarity), đánh giá sự khác biệt cấu trúc giữa mảnh hình ảnh dự đoán và mảnh hình ảnh thực .

- là trọng số.

Kết luận

Kết quả từ các thử nghiệm với mỗi bộ dữ liệu cụ thể của từng người, phần đầu được huấn luyện trong 20,000 bước và môi được tinh chỉnh trong 5,000 bước, mỗi bước chứa 256² tia và tối đa 16 điểm được lấy mẫu trên mỗi tia. Kết quả cho thấy RAD-NeRF có khả năng tái tạo các chân dung với chất lượng cao trên thời gian thực. Điều này làm cho RAD-NeRF trở thành một công cụ mạnh mẽ trong việc tổng hợp hình ảnh chân dung trong các ứng dụng thực tế.

Nhìn chung, RAD-NeRF đã mở ra những hướng đi mới trong việc sử dụng mạng nơ-ron động và các kỹ thuật điều chỉnh tiên tiến để giải quyết các thách thức trong việc tổng hợp chân dung nói chuyện.

Hãy để lại bình luận để cùng trao đổi nhé 😆

Nguồn tham khảo:

Real-time Neural Radiance Talking Portrait Synthesis via Audio-spatial Decomposition

Dynamic Neural Radiance Fields for Monocular 4D Facial Avatar Reconstruction

All rights reserved