Thuần hóa "Sở thú" LLM: Tại sao môi trường Dev Local của bạn cần một AI Gateway?

Năm 2026, bức tranh AI không còn là một bức tranh tĩnh nữa — nó là một khu rừng rậm. Hay chính xác hơn, là một "Sở thú".

Vài năm trước, "tích hợp AI" thường chỉ có một nghĩa duy nhất: hardcode cái API key của OpenAI vào dự án. Ngày nay, thực tế đối với các lập trình viên đã khác xa. Chúng ta có Claude (Anthropic) cho khả năng suy luận, Gemini (Google) cho các tác vụ đa phương thức, GPT-4 cho sự tin cậy tổng quát, và một binh đoàn các mô hình mã nguồn mở như Llama 3 hay Mistral chạy cục bộ qua Ollama.

Mặc dù sự đa dạng này rất tốt cho sự đổi mới, nhưng nó lại là cơn ác mộng đối với môi trường phát triển cục bộ của bạn.

Vấn đề: Mớ bòng bong API (API Spaghetti)

Mỗi khi bạn muốn chuyển đổi mô hình để kiểm tra tính năng hoặc tiết kiệm chi phí, bạn sẽ va phải những điểm ma sát:

-

Giao thức không tương thích: OpenAI yêu cầu một cấu trúc JSON này. Anthropic lại đòi một kiểu khác. Gemini thì có ý tưởng riêng của họ. Bạn rốt cuộc phải viết hàng tá lớp chuyển đổi (adapter layers) chỉ để thay đổi một model.

-

Chứng "mất trí nhớ" ngữ cảnh: Bạn đang debug một hàm với Model A. Bạn nhận ra Model A đang "ảo giác" (hallucinating), nên bạn chuyển sang Model B. Bùm! Lịch sử trò chuyện biến mất. Bạn phải copy-paste lại ngữ cảnh và bắt đầu lại từ đầu.

-

Ác mộng Quota (Hạn ngạch): Bạn chạm trần giới hạn rate limit của nhà cung cấp chính trong một phiên debug quan trọng. App bị crash. Bạn phải thủ công đổi key hoặc đổi nhà cung cấp trong file

.envvà khởi động lại server. -

Xung đột Local vs. Cloud: Bạn muốn dùng model Llama cục bộ để bảo mật, nhưng code của bạn lại được thiết lập cho Cloud API. Việc cấu hình mạng để chúng nói chuyện với nhau thường tốn công sức hơn giá trị nó mang lại.

Giải pháp: Mô hình AI Gateway

Cũng giống như cách chúng ta dùng API Gateway (như Nginx hay Kong) để quản lý microservices, quy trình phát triển hiện đại đòi hỏi một AI Gateway.

Một AI Gateway hoạt động như một lớp phần mềm trung gian (middleware) giữa code ứng dụng của bạn và cái "Sở thú" LLM kia. Thay vì app của bạn phải nói chuyện với 5 nhà cung cấp khác nhau, nó chỉ cần nói chuyện với Gateway. Gateway sẽ lo phần còn lại.

Một Gateway tốt làm được gì:

- Chuẩn hóa: Nó chấp nhận một giao thức duy nhất (thường là chuẩn tương thích OpenAI) và dịch nhanh (on the fly) sang bất cứ thứ gì model backend cần.

- Định tuyến & Dự phòng (Fallback): Nếu Nhà cung cấp A bị sập hoặc bị giới hạn rate limit, Gateway tự động chuyển hướng request sang Nhà cung cấp B mà không làm crash ứng dụng.

- Hợp nhất ngữ cảnh: Nó duy trì trạng thái phiên làm việc, cho phép bạn hoán đổi "bộ não" (model) giữa cuộc trò chuyện mà không bị đứt mạch.

ServBay 2.0 tham chiến: Hạ tầng AI cho Localhost

Hầu hết các AI Gateway hiện nay là các giải pháp đám mây hạng nặng dành cho doanh nghiệp. Vậy còn các developer cá nhân hoặc các team đang cố gắng xây dựng sản phẩm local thì sao?

ServBay, vốn nổi tiếng với khả năng quản lý stack phát triển local mạnh mẽ, vừa công bố bản ServBay 2.0 Preview Vol. 2, và nó đang mở ra kỷ nguyên "AI-First" cho phát triển cục bộ.

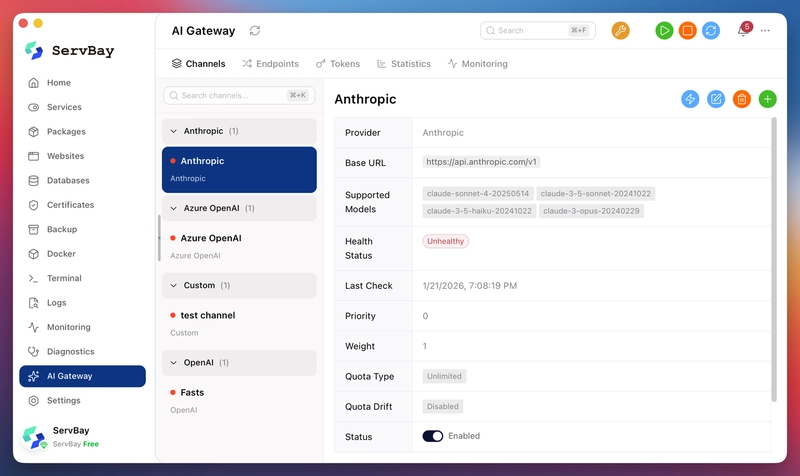

Họ không chỉ thêm vào một con chatbot; họ đang tích hợp cả một AI Gateway hoàn chỉnh trực tiếp vào môi trường server local.

Các tính năng chủ chốt được công bố trong ServBay 2.0:

- Thích ứng giao thức thông minh: Dù bạn đang gọi OpenAI, Anthropic hay Gemini, ServBay đều chuẩn hóa các giao thức. Bạn chỉ cần thêm key, nó sẽ lo phần biên dịch.

- Hợp nhất Cloud & Local: Nó tích hợp sâu với các công cụ như Ollama và LM Studio. Bạn có thể định tuyến traffic vào một model local để test với độ trễ bằng không, và chuyển sang GPT-4 để kiểm tra chất lượng production ngay lập tức.

- Định tuyến thông minh & Trôi Quota (Quota Drift): Đây là tính năng thay đổi cuộc chơi. ServBay giới thiệu 7 chiến lược định tuyến. Nếu hạn ngạch dịch vụ cụ thể của bạn bị cạn kiệt, hệ thống sẽ tự động "trôi" (drift) request sang một kênh dự phòng. Chuỗi công cụ (toolchain) của bạn luôn online.

- Tiếp nối ngữ cảnh xuyên mô hình: Chuyển từ Claude sang GPT-4 không còn đồng nghĩa với việc mất lịch sử chat. ServBay bảo tồn ngữ cảnh, mang lại cho trợ lý AI của bạn "trí nhớ dài hạn" qua các nhà cung cấp khác nhau.

Lời kết

Kỷ nguyên của việc hardcode các API client đã kết thúc. Khi toolchain của chúng ta trở nên phức tạp hơn, hạ tầng cũng cần thông minh hơn. ServBay 2.0 đang định hình không chỉ là một công cụ để chạy PHP hay Node.js, mà là hệ thần kinh trung ương cho việc phát triển AI-native.

ServBay 2.0 hiện đang ở giai đoạn preview. Nếu bạn đã quá mệt mỏi khi phải vật lộn với "Sở thú" LLM, đây chính là bản cập nhật đáng để theo dõi.

All rights reserved