MỘT SỐ THÔNG TIN CƠ BẢN VỀ SEO

Bài đăng này đã không được cập nhật trong 4 năm

1. SEO là gì?

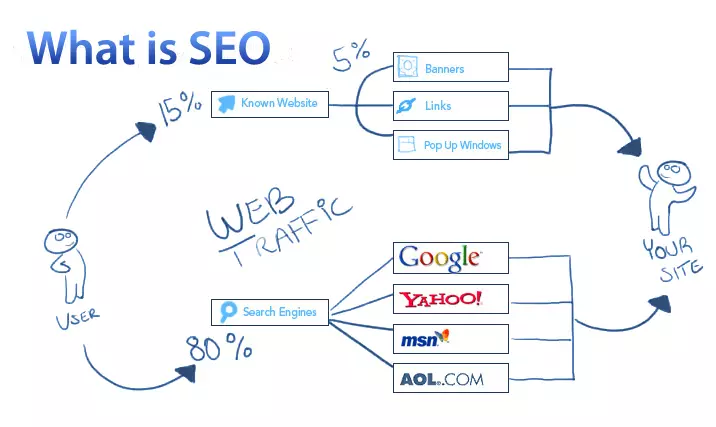

SEO là từ viết tắt của search engine optimization tiếng Nhật gọi là 検索エンジン最適化 và dịch sang tiếng Việt nó có nghĩa là tối ưu hóa công cụ tìm kiếm. Nó là quá trình tác động mã nguồn HTML, nội dung, các liên kết trang, hệ thống, server để các công cụ tìm kiếm lựa chọn trang web phù hợp nhất phục vụ người tìm kiếm trên Internet ứng với một từ khóa cụ thể được người dùng truy vấn. Đơn giản hơn ta có thể hiểu SEO là một tập hợp các phương pháp nhằm đưa website lên vị trí cao trên trang kết quả của các công cụ tìm kiếm ứng với một từ khóa.

2. Tạo sao lại cần có SEO?

Người tìm kiếm mong muốn tìm kiếm được những thông tin hữu ích qua các máy tìm kiếm trên internet.

Ngược lại, người cung cấp thông tin về dịch vụ, sản phẩm lại mong muốn có nhiều người truy cập vào website và mua hàng.

SEO ra đời để giải quyết vấn đề trên. Tối ưu nội dung, định dạng website để thân thiện hơn với máy tìm kiếm, hỗ trợ nó tìm ra những nội dung hữu ích nhất cho người tìm kiếm hay khách hàng, người dùng.

Hiện trên mạng Internet có 5 công cụ tìm kiếm hữu hiệu nhất và phổ biến nhất:

http://www.google.com

http://www.bing.com

http://www.yahoo.com

http://ask.com

http://www.aol.com

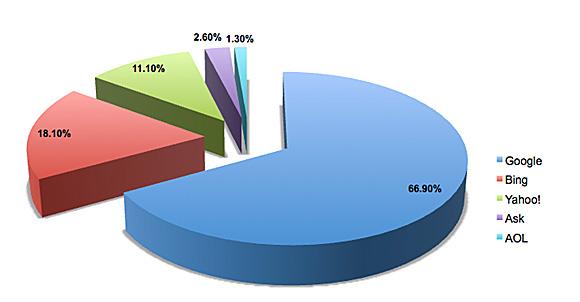

3. Thị Phần Của Các Công Cụ Tìm Kiếm Tháng 4/2011

- Google: 66.9%

- Yahoo: 11.1%

- Bing: 18.1%

- Ask: 2.6%

- AOL: 1.3%

SEO có thể coi như là một kỹ thuật, một bí quyết thực sự đối với mỗi người quản trị, xây dựng website. SEO được xem như là một tài sản, nhưng nó cần thời gian. Và cũng lưu ý rằng SEO không miễn phí .Và một điều quan trọng nhất là không ai là số 1 trên các máy tìm kiếm.

4. Phân loại người làm SEO

-

SEO Mũ trắng: Xây dựng và phát triển nội dung hướng tới người tìm kiếm để thu hút người dùng và giữ chân họ. Thứ bậc của trang sẽ càng lúc càng tăng cao.

-

SEO Mũ xám: Xây dựng hệ thống thân thiện với máy tìm kiếm, tạo backlink cũng như những bài viết đề cập đến trang web trên những trang web khác.

-

SEO Mũ đen: Sử dụng các phương pháp bị cấm dùng như cloaking và spamdexing nhằm đưa website lên TOP 10 nhưng hiện nay hầu hết các công cụ cloaking và spamdexing là không còn tác dụng đối với máy tìm kiếm

・Cloaking: là sự che đậy hay che dấu một cái gì đó. Trong kỹ thuật SEO thì cloaking ám chỉ hành động của webmaster che dấu bot của search engine như Google crawl các nội dung mà người dùng nhìn thấy, đồng thời đề xuất cho các cậu Bot nhìn thấy các nội dung được Onpage optimize tốt nhằm mục đích đạt được các vị trí cao trên SERP - Search engine results page . Ví dụ: Trong một số trường hợp, bạn sẽ ngạc nhiên khi nhìn thấy những web hay webpage không có liên quan đến nội dung từ khóa search nhưng lại đứng vị trí rất cao trên SERP.

Vậy họ làm như thế nào? Rất đơn giản là sử dụng CGI/ Htacess của server hosting để quyết định theo user agent của Bot hoặc theo IP list để quyết định những IP nào của Bot sẽ nhìn thấy nội dung nào, và số còn lại là người duyệt web sẽ nhìn thấy nội dung khác. Ngoài ra họ có thể sử dụng các phần mềm Cloaking trên mạng để quyết định xuất bản khu vực nào là cloaking page và cái nào là không.

Trong một số kỹ thuật cổ điển thì cloaking còn dành cho những script để chuyển hướng trang web, ví dụ như bạn SEO từ khóa hot như “gái xinh” và khi click vào thì trang web đó sẽ tự chuyển hướng sang trang web có nội dung khác như bán máy tính. Hiện nay các kỹ thuật đơn giản như vậy Google thừa đủ thông minh để xác định và sẽ quyết định phạt bạn hay không.

・Spamdexing: còn gọi là thư rác tìm kiếm, công cụ tìm kiếm thư rác hoặc spam web liên quan đến một số phương thức, chẳng hạn như lặp đi lặp lại các cụm từ không liên quan, để thao tác liên quan hoặc nổi bật của tài nguyên lập chỉ mục của một công cụ tìm kiếm, trong một cách thức không phù hợp với mục đích của hệ thống lập chỉ mục. Một số coi nó là một phần của tối ưu hóa công cụ tìm kiếm, mặc dù có rất nhiều công cụ tìm kiếm tối ưu hóa mà phương pháp nâng cao chất lượng và sự xuất hiện của các nội dung của những trang web và phục vụ nội dung hữu ích cho nhiều người sử dụng. Công cụ tìm kiếm sử dụng một loạt các thuật toán để xác định thứ hạng liên quan. Một số trong số này bao gồm xác định xem các thuật ngữ tìm kiếm xuất hiện trong META từ khóa, những người khác cho dù các thuật ngữ tìm kiếm xuất hiện trong cơ thể văn bản hoặc URL của một trang web.

Nhiều công cụ tìm kiếm kiểm tra các trường hợp của spamdexing và sẽ loại bỏ các trang nghi ngờ từ chỉ số của họ. Ngoài ra, những người làm việc cho một tổ chức động cơ tìm kiếm nhanh chóng có thể chặn các kết quả niêm yết toàn bộ từ các trang web có sử dụng spamdexing. Do đó, spamdexing ngày càng ít hữu ích.

spamdexing kĩ thuật thường gặp có thể được phân thành hai lớp học rộng: nội dung thư rác (hoặc hạn thư rác) và liên kết thư rác.

5. Cơ chế hoạt động của bộ máy tìm kiếm Google

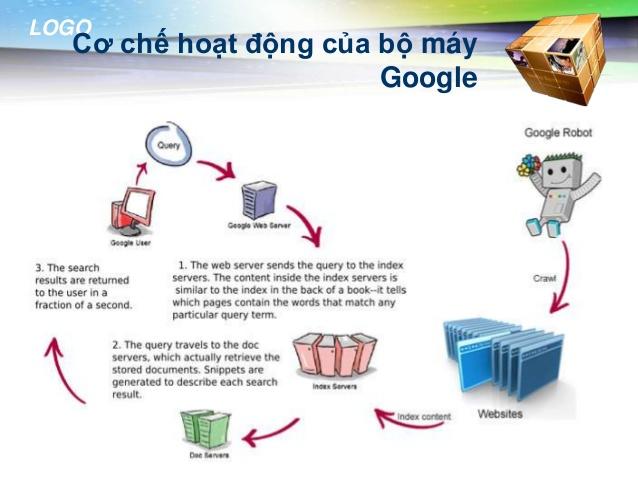

Một sự thật cơ bản đầu tiên mà chúng ta cần phải hiểu đó là công cụ tìm kiếm của Google không phải là con người. Chính vì thế sẽ có sự khác nhau giữa con người và công cụ tìm kiếm trong việc đánh giá nội dung của một trang web. Không giống như con người, công cụ tìm kiếm nội dung theo định hướng. Mặc dù công cụ tìm kiếm được trang bị các công nghệ rất hiện đại tuy nhiên nó vẫn không đủ thông minh để có thể cảm nhận được vẻ đẹp của một mẫu thiết kế, thưởng thức âm thanh hoặc thấy được chuyển động của một video nào đó. Vì vậy khi công cụ tìm kiếm thu thập dữ liệu của trang web nó chỉ nhìn vào các văn bản cụ thể để cố gắng hiểu được trang web này đang muốn nói về vấn đề gì.

Công cụ tìm kiếm có 3 bộ phận chính

- Bộ phận thu thập dữ liệu: Bộ phận thu thập dữ liệu hay còn có tên gọi thân thiện là Google Spider, google bot hoặc con nhện. Một cách đơn giản bạn có thể hiểu rằng đây là một quá trình mà Google Spider sẽ đi từ trang này sang trang khác thông qua các liên kết (link) để khám phá nội dung và các liên kết trong trang web của bạn. Đây là một quá trình mà Google Spider đang cố gắng tìm các trang web mới và cập nhật thêm vào chỉ mục của Google. Chính vì thế, Google bot có thể coi là một chương trình thu thập dữ liệu và phát hiện ra các trang web mới, thay đổi các trang web hiện có và các truy tìm các liên kết không tồn tại, các dữ liệu này được sử dụng để cập nhật cho các chỉ mục của Google.

- Bộ phận lập chỉ mục: Hay còn gọi là indexing. Đây là quá trình xây dựng cơ sở dữ liệu của các từ khóa, cụm từ, các trang web và các trang liên quan đến một lĩnh vực nào đó.

- Bộ phận xử lí – tính toán: Đây là quá trình tính toán của Google nhằm cung cấp các kết quả cho người tìm kiếm. Theo thống kê, Google sử dụng hơn 200 yếu tố để xếp hạng trang web. Các yếu tố này có tầm quan trọng khác nhau, tuy nhiên một trong những yếu tố quan trọng nhất để xếp hạng đó là dựa trên chất lượng nội dung và chất lượng của những liên kết đến trang web của bạn.

Cơ chế hoạt động của Google Spider

- Đầu tiên Google Spider sẽ lấy danh sách các máy chủ và trang web phổ biến. Sau đó nó sẽ bắt đầu tìm kiếm với một site bất kỳ, nó đánh chỉ mục các từ khóa trên trang và theo các liên kết (link) tìm thấy bên trong trang web này.

- Khi Spider xem xét các trang web (định dạng HTML), nó lưu ý: Các từ bên trong trang web & nơi nó tìm thấy các từ đó.

Vì thế đối với mỗi website, Google nó sẽ có nhiều phương pháp để index lại chỉ mục, liệt kê lại các từ khóa chính. Nhưng dù dùng cách nào thì Google cũng luôn cố gắng làm cho hệ thống tìm kiếm diễn ra nhanh hơn để người dùng có thể tìm kiếm hiệu quả hơn hoặc cả hai.<br - Tiếp đó Google sẽ xây dựng chỉ mục: Xây dựng chỉ mục sẽ giúp cho các thông tin được tìm thấy một cách nhanh chóng. Sau khi tìm thông tin trên trang web, Google Spider nhận ra rằng việc tìm kếm thông tin trên website là một quá trình không bao giờ kết thúc… bởi vì các quản trị trang web luôn thay đổi thông tin, cập nhật thông tin trên website và điều đó có nghĩa rằng Spider sẽ luôn phải thực hiện nhiệm vụ thu thập dữ liệu.

- Xử lý và tính toán: Sau khi lập chỉ mục Google sẽ xử lý, tính toán và mã hóa thông tin để lưu trữ trong cơ sở dữ liệu. Và khi có một truy vấn tìm kiếm thì hệ thống sẽ trả về các kết quả có chứa nội dung hữu ích tương ứng với các truy vấn tìm kiếm của người dùng.

Việc hiểu rõ cơ chế tìm kiếm của Google sẽ giúp cho các SEOER thêm nhiều kỹ năng để có thể tối ưu website thân thiện với Google nhằm mục đích đưa trang web có thứ hạng cao hơn.

6. Một số phương pháp tối ưu hóa

Google, Yahoo hay Bing là các bộ máy tìm kiếm vì thế nó xây dựng các tiêu chuẩn để đánh giá, xếp hạng website. Một website càng đáp ứng được nhiều các tiêu chuẩn của máy tìm kiếm thì càng được đánh giá tốt, cơ hội lên trên TOP sẽ cao hơn. Hiện nay, có một số cách thức quan trọng sau để thực hiện SEO:

- Title - Tiêu đề trang: khai báo thẻ Page Title của website ngắn gọn, súc tích, duy nhất trong từng webpage. Các máy tìm kiếm đánh giá rất cao thẻ Page Title do nó là những gì xúc tích, hàm chứa nhất của website.

- Description - Thẻ mô tả: Nó giống như một đoạn tóm tắt nội dung của website. Khi khai báo Description cũng phải viết ngắn gọn, xúc tích. Desciption thông thường là đoạn text màu đen hiện ra bên trên đường link, bên dưới tiêu đề trang trong phần kết quả tìm kiếm.

- Từ khoá: Sử dụng thẻ meta keyword để thông báo các từ khóa chính của website tối các công cụ tìm kiếm. Là một cách giúp công cụ tìm kiếm nhanh chóng hiểu được nội dung chính của website.

- URL: Phải xây dựng một URL tĩnh - hay URL thân thiện với người dùng và máy tìm kiếm. Trong URL thân thiện không nên có các ký tự đặc biệt (%, $, ~, ...) mà phải giống như đường dẫn thư mục trong window. Việc này làm các công cụ tìm kiếm dễ dàng hơn trong việc tìm và thu thập nội dung trong website.

- Dung lượng website: Máy tìm kiếm lưu trữ nội dung website trong Server riêng của nó. Nên website càng nhẹ (dưới 100KB) sẽ tốt hơn cho việc lưu trữ thông tin và quét thông tin của máy tìm kiếm.

- Xây dựng Backlink: Là việc trao đổi link, xây dựng liên kết tới các website khác. Việc trao đổi này dựa trên trao đổi với các website có cùng nội dung chủ đề và chất lượng tốt thì sẽ có hiệu quả cao hơn.

- Submit Website vào danh bạ web: danh bạ website nổi tiếng và cần thiết nhất là của Google, Yahoo. Hiện nay Google đã không còn đánh giá cao việc khai báo vào các danh bạ web do càng về sau chất lượng các danh bạ web càng giảm, một số danh bạ web bắt người đăng ký phải trả tiền.

- Phát triển, xây dựng nội dung hướng tới Khách hàng: Content is King. Máy tìm kiếm sinh ra là để phục vụ người tìm kiếm trên Internet nên nội dung là cái nó quan tâm nhất. Những Website có được nội dung phong phú luôn nằm ở trong TOP đầu.

- Chọn lựa từ khóa: Là cách chọn cách từ khóa phù hợp với nội dung website, phù hợp với việc Search của người dùng. Từ khóa là đề hỗ trợ máy tìm kiếm nên chọn lựa từ khóa đúng, chính xác là bước vô cùng quan trọng, nó quyết định sự thành công của chiến dịch SEO.

- Sitemap: Phải khởi tạo sitemap và đang ký sitemap với các động cơ tìm kiếm

Cũng giống như các phương pháp truyền thông khác. Tùy vào tình huống mà có nên sử dụng SEO hay không? SEO hướng tới phát triển lâu dài, vững chắc nên cần một thời gian khá dài để phát triển. SEO sẽ không phù hợp với các mục đích truyền thông ngắn hạn.

Bài viết trên đây được dịch và tham khảo từ nhiều nguồn.

Tôi rất vui nếu các thông tin trên đây hữu ích cho bạn.

All rights reserved