Kỷ nguyên "Lạm phát Code": Tại sao chi phí review code AI lại cao gấp 12 lần?

Gần đây, một cuộc thảo luận trên Reddit đã đưa ra một phép tính giật mình: một contributor sử dụng AI chỉ mất 7 phút để tạo ra một Pull Request (PR), nhưng người maintainer lại mất trung bình 85 phút để hiểu logic, rà soát các mối nguy tiềm ẩn và test vận hành.

Đó là chi phí review cao gấp 12 lần.

Đây chính là sự hiện hình của Định luật Brandolini (hay còn gọi là Nguyên lý bất cân xứng của những thứ vô nghĩa) trong kỷ nguyên AI: "Năng lượng cần thiết để bác bỏ một thứ vô nghĩa lớn hơn gấp nhiều lần so với năng lượng để tạo ra nó."

Trước đây, khi ai đó gửi PR, chúng ta chủ yếu xem xét logic. Giờ đây, đối mặt với code do AI sinh ra, chúng ta phải đề phòng nó như phòng trộm. Những đoạn code này trông hoàn hảo không tì vết: đặt tên biến đẹp, comment còn hay hơn cả văn mẫu, tuân thủ mọi chuẩn mực PEP-8 hay Google Style Guide.

Nhưng khi thực sự chạy thử? Vòng lặp vô tận, các phụ thuộc ảo giác (hallucination), hoặc thậm chí là gọi một API đã bị loại bỏ từ Python 3.7 trong môi trường Python 3.12.

Chúng ta đang bước vào kỷ nguyên Lạm phát Code nhưng Giảm phát Niềm tin. Đối mặt với lượng lớn code AI trông có vẻ hoàn hảo nhưng thực chất lại mong manh dễ vỡ, các developer — dù viết Python, Go hay Java — đều đang khao khát một nơi an toàn để chạy thử code mà không lo hậu quả.

Những cái bẫy vô hình: Tại sao code AI lại nguy hiểm đến thế?

Nhiều người nghĩ vấn đề của code AI chỉ là "viết chưa đủ tốt". Nhưng trong mắt các chuyên gia bảo mật, vấn đề nghiêm trọng hơn nhiều. Theo các nghiên cứu từ IEEE và Đại học Stanford, lập trình hỗ trợ bởi AI đang mang lại ba loại rủi ro mới, trải dài trên mọi ngôn ngữ lập trình:

1. Lỗ hổng tổng hợp & Phụ thuộc ảo giác

Trước đây khi con người viết code, lỗi thường là lỗi logic hoặc sai cú pháp, những thứ này dễ dàng bị các công cụ phân tích tĩnh (Static Analysis) tóm gọn.

Nhưng code do AI sinh ra trông rất "chuẩn chỉ". Nó tuân thủ cú pháp hiện đại, nhưng bản chất logic có thể bị hỏng (ví dụ: một lớp trừu tượng vô tình cho phép SQL Injection). Nguy hiểm hơn là hiện tượng "Gói phụ thuộc ảo giác" (Hallucinated Packages). AI có thể gợi ý import một thư viện nghe tên rất hợp lý nhưng không hề tồn tại, hoặc tệ hơn, tên thư viện đó đã bị hacker đăng ký trước để thực hiện tấn công chuỗi cung ứng (Slopsquatting).

Nếu doanh nghiệp áp dụng AI coding ồ ạt mà không có các kỹ sư thâm niên kiểm duyệt 100%, codebase sẽ tích tụ một loại nợ kỹ thuật và nợ bảo mật mới. Loại nợ này bình thường không thấy đâu, nhưng khi gặp trường hợp cực đoan (edge cases) sẽ bùng nổ thảm khốc.

2. Nhạy cảm với độ trễ phiên bản

Ai cũng biết LLM được train dựa trên dữ liệu lịch sử. Nó nhớ cách viết Python 3.7 từ hai năm trước, nhưng lại không biết Python 3.12 đã giới thiệu các kiểm tra cú pháp nghiêm ngặt hơn; nó có thể vẫn đang dùng các tính năng cũ của Java 8 trong khi dự án của bạn đã chuyển sang Java 21 LTS.

Sự trễ nhịp này dẫn đến hiện tượng phổ biến: "Chạy trong não AI thì ngon, nhưng đưa vào compiler thực tế thì báo lỗi."

Sự trễ nhịp này dẫn đến hiện tượng phổ biến: "Chạy trong não AI thì ngon, nhưng đưa vào compiler thực tế thì báo lỗi."

3. Cấu hình mặc định kém bảo mật

AI học từ hàng triệu dòng code trên Stack Overflow và các bài hướng dẫn nhập môn. Để thuận tiện cho việc giảng dạy, các tutorial này thường tắt các bước xác minh bảo mật (như tắt SSL check hay bỏ qua CSRF token).

AI thừa hưởng thiên kiến này. Nó có xu hướng sinh ra code với các cấu hình mặc định không an toàn. Trong bất kỳ Web Framework nào, đây đều là một quả bom nổ chậm.

Giải pháp: Chuyển mình từ Người viết (Writer) sang Người kiểm duyệt (Auditor)

"Trước đây bạn phải hiểu biết một chút mới viết được code lởm; bây giờ bạn chẳng cần biết gì cũng có thể tạo ra những đoạn code lởm trông rất chuyên nghiệp."

Trong kỷ nguyên AI, năng lực cốt lõi không còn là tốc độ gõ phím, mà là Khả năng Review Code.

Điều đáng sợ không phải là code không chạy được. Mà là code chạy được, nhưng bên trong chứa độc.

AI chắc chắn sẽ có lúc bị ảo giác. Nếu bạn trực tiếp chạy các lệnh pip install, npm install hay cargo build không rõ nguồn gốc trên máy phát triển chính (main machine) chỉ vì AI gợi ý thế, thì chẳng khác nào nhặt đồ ăn bên lề đường bỏ vào miệng. Nếu bạn chạy "trần" trong môi trường hệ thống, một khi Registry hay biến môi trường toàn cục bị ô nhiễm, cài lại Win/Mac có khi còn là nhẹ.

Đây là lúc giá trị của một môi trường phát triển cục bộ mạnh mẽ được thể hiện.

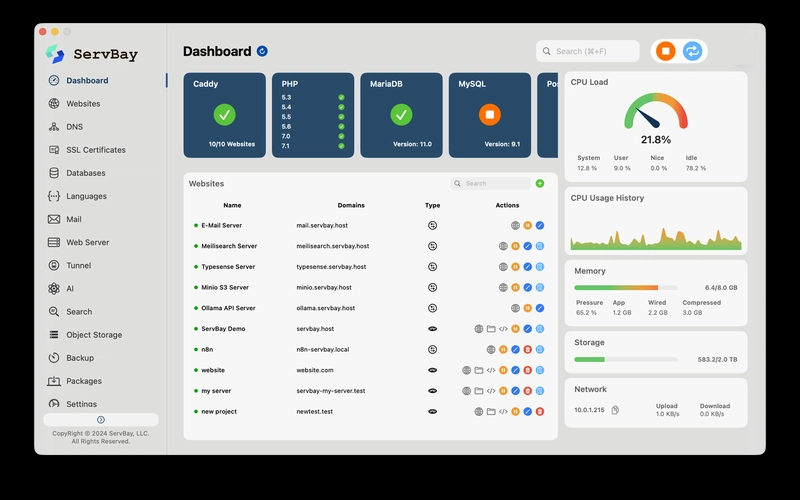

Các công cụ như ServBay cung cấp một môi trường không xâm lấn (non-intrusive). Nó đi kèm với cấu trúc hệ thống tập tin và thư viện runtime độc lập, không phụ thuộc cũng như không sửa đổi các file cốt lõi của hệ điều hành.

Bất kể code do AI sinh ra có tệ đến mức nào, hay nó có lỡ import các gói phụ thuộc độc hại, phạm vi ảnh hưởng vẫn bị giới hạn. Vì môi trường đã được sandbox hóa, nên nếu có "nổ", nó chỉ nổ trong sandbox, hệ thống chính của bạn vẫn an toàn.

Tin tưởng, nhưng phải kiểm chứng (Trust, But Verify)

Cha đẻ của Linux, Linus Torvalds, từng nói rằng AI là bộ nhân (multiplier) năng lực. (Gần đây chính ông cũng bắt đầu thử nghiệm coding với AI).

Đối với Senior Developer: 10 năm kinh nghiệm × AI = 10 lần Sản lượng. Nhưng với các team thiếu cơ chế kiểm chứng: 0 kinh nghiệm × AI = 10 lần Nợ kỹ thuật.

Đừng để dự án của bạn trở thành vật tế thần cho quá trình thử-sai của AI. Bất kể là ngôn ngữ gì, code nhất định phải được kiểm chứng (verify) thì mới được tin dùng. Hãy coi ServBay không chỉ là một công cụ, mà là "Trạm kiểm dịch code" ngay tại local trong kỷ nguyên lập trình AI.

All rights reserved