[GPU in AI] Bài 1: Lời mở đầu

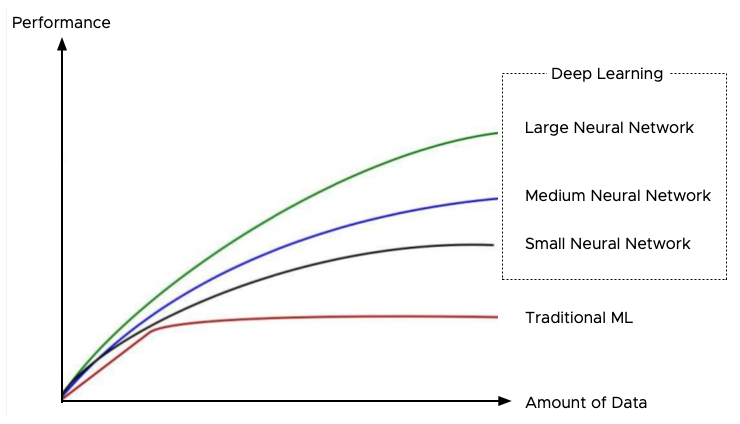

Ngày nay, với sự phát triển nhanh chóng của AI khiến nhu cầu sử dụng ngày càng tăng, dẫn đến việc dữ liệu ngày càng phong phú và các tác vụ ngày càng đa dạng. Điều này khiến các bài toán về Machine-Learning cũng như Deep-Learning tốn nhiều thời gian và bộ nhớ để xử lý. Trong series này, mình sẽ hướng dẫn các bạn tối ưu hóa các bài toán Machine-Learning và Deep-Learning bằng cách sử dụng GPU, nhằm tăng cường hiệu suất và hiệu quả công việc.

Bạn sẽ học được gì?

GPU in AI sẽ giúp các bạn xử lí các bài toán về Machine-Learning, Deep-Learning một cách hiệu quả hơn về mọi mặt ( accuracy, speed up, efficiency memory ) từ cơ bản cho đến nâng cao và hoàn toàn dễ hiểu

Ở series này các bạn sẽ học được cách sử dụng GPU một cách tối ưu và hơp lí khi ứng dụng vào AI nói chung, Machine-Learning Deep-Learning nói riêng. Và các bạn yên tâm là sẽ có code from scratch cũng như hướng dẫn setup các môi trường, các package cần thiết

Lưu ý

Vì đây là series tập trung về Machine-Learning và Deep-Learning nên các bạn cần có nền tảng về:

- Machine-Learning: hiểu rõ về Classification - Regression - Clustering

- Deep-Learning: hiểu rõ về CNN (Convolutional Neural Network) - Gradient Descent

Và mình rất khuyến khích nếu các bạn đọc qua 2 series này: Lập trình song song - NVIDIA Tools để hiểu rõ hơn về cách hoạt động của GPU

Xin lưu ý là về Deep-Learning mình sẽ dùng hoàn toàn bằng Pytorch ( lý do vì sao lại là Pytorch chứ không phải Tensorflow thì ở các bài sau mình sẽ giải thích )

All rights reserved