DeepSeek V3.2 Chính Thức Ra Mắt, Đối Đầu GPT‑5 – Nhưng Môi Trường Dev Của Bạn Đã Sẵn Sàng Chưa?

Vài ngày trước, DeepSeek chính thức công bố V3.2 – một bước nhảy khá lớn trong cuộc đua mô hình ngôn ngữ. Bản DeepSeek‑V3.2 tiêu chuẩn nhắm tới các nhu cầu hàng ngày, trong khi DeepSeek‑V3.2‑Speciale lại tập trung vào bài toán khó, chứng minh toán, kiểm tra logic ở cấp độ “thi Olympic”.

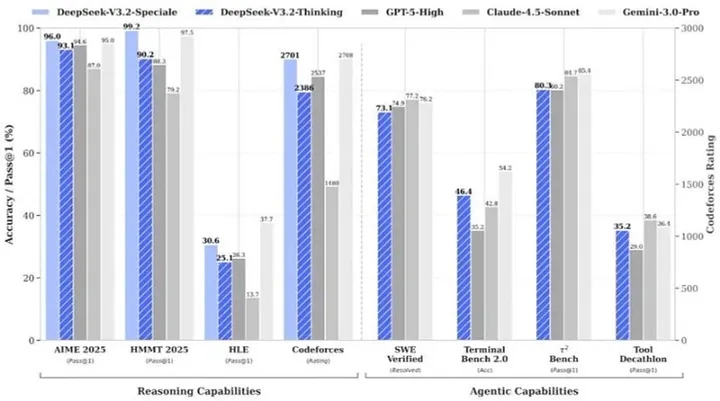

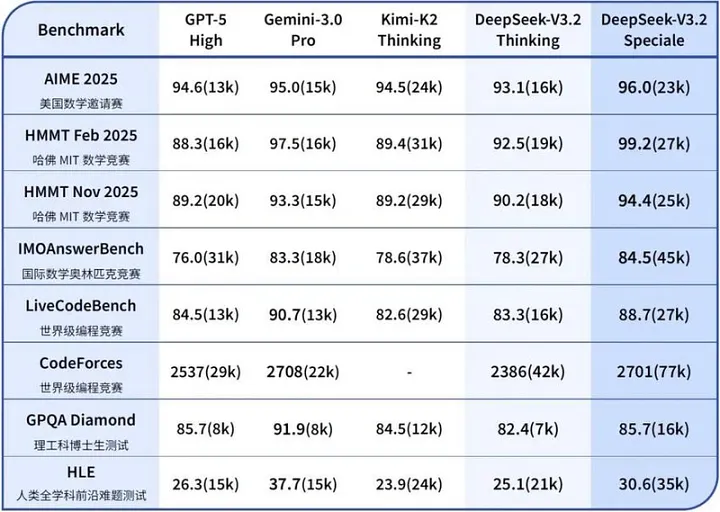

Trên giấy tờ, bản tiêu chuẩn được định vị ở “cấp GPT‑5” về suy luận tổng hợp, chỉ nhỉnh kém một chút so với Gemini 3.0 Pro, nhưng chi phí lại thấp hơn đáng kể. Còn Speciale thì giống như một “quái vật thi đấu” – không thân thiện trò chuyện, nhưng rất đáng sợ khi giải bài.

Bài viết này sẽ tóm tắt những điểm đáng chú ý của V3.2, và quan trọng hơn: làm sao để đưa nó vào workflow Python của bạn mà không bị… môi trường dev cản đường.

Hai phiên bản: Một cho đời thường, một cho “trùm cuối”

DeepSeek‑V3.2: Biết nghĩ, biết xài tool, lại còn chạy nhanh

Đây là bản dành cho đa số người dùng và developer:

-

Thinking with Tools – vừa suy nghĩ, vừa gọi tool

Các mô hình trước đây thường “hoặc là suy nghĩ dài dòng, hoặc là gọi tool khá ngây thơ”. V3.2 kết hợp hai việc:- Phân tích bài toán,

- Quyết định nên gọi tool nào,

- Dùng kết quả trả về để tiếp tục suy luận,

- Rồi mới ra kết quả cuối.

-

Ít nói lan man, nhiều thông tin hơn

So với một số model “thinking” khác, V3.2 cố gắng:- Rút ngắn câu trả lời,

- Tập trung vào nội dung chính,

- Giảm token → giảm chi phí, tăng tốc độ.

Điều này cực kỳ quan trọng khi bạn muốn triển khai hàng loạt Agent trong doanh nghiệp – mỗi token tiết kiệm được là tiền thật.

DeepSeek‑V3.2‑Speciale: Dành cho bài toán “không đùa được”

Speciale là bản chơi “hết ga, không nhìn đồng hồ”:

- Tích hợp năng lực chứng minh định lý từ DeepSeek‑Math‑V2

- Tối ưu cho toán học, chứng minh, logic, lập trình thi đấu

- Không tối ưu cho chat thường ngày, không hỗ trợ tool, token tốn kém hơn

Thành tích thì gây choáng:

- ICPC World Finals 2025: Huy chương vàng, ngang trình tuyển thủ người đứng hạng 2

- IOI 2025: Huy chương vàng, vào top 10 thí sinh người

- Đồng thời “gom” thêm vàng ở IMO 2025 và CMO 2025

Bạn có thể tưởng tượng nó như một “siêu chuyên gia tính phí theo giây”: chỉ gọi khi bản tiêu chuẩn bó tay.

V3.2 nói gì về tương lai AI?

1. Xử lý văn bản dài rẻ hơn rất nhiều

Trước đây, muốn xử lý:

- Hợp đồng pháp lý dài cả trăm trang,

- Báo cáo tài chính dày đặc,

- Tài liệu kỹ thuật nhiều trăm nghìn ký tự,

thường phải dùng API đắt đỏ (Claude 3 Opus, model closed source cao cấp, v.v.).

V3.2 cho thấy, với kỹ thuật attention thưa (sparse attention) và tối ưu kiến trúc, việc xử lý ngữ cảnh dài có thể:

- Chạy trên cụm GPU tầm trung, thậm chí station mạnh,

- Giảm đáng kể chi phí cho RAG và phân tích long-document.

2. “[translate:Mô hình mở luôn thua mô hình đóng]” không còn dễ nói

Trước nay hay có câu: “Model open source luôn đi sau closed 6–12 tháng.”

V3.2 làm câu này bớt chắc chắn:

- Bản tiêu chuẩn “ngắm” GPT‑5,

- Bản Speciale đè bẹp nhiều kỳ thi danh giá.

Không phải open source thắng mọi mặt, nhưng rõ ràng mô hình mở đã đủ sức cạnh tranh ở phân khúc rất cao, nhất là khi bạn muốn tùy biến theo bài toán riêng.

3. “Không chỉ hút thêm GPU” trở thành chiến lược nghiêm túc

DeepSeek nhấn mạnh họ không đơn thuần “đổ thêm card”:

- Tối ưu thuật toán (DeepSeek Sparse Attention, DSA),

- Chiến lược train 2 giai đoạn (dense warmup → sparse).

Đây là tín hiệu tốt cho các lab, công ty không phải “ông lớn cloud”:

bạn vẫn có thể tiến gần SOTA, nếu đầu tư vào trí tuệ chứ không chỉ tiền điện.

Nút thắt thực sự: Môi trường Python của bạn

Benchmark đẹp đến mấy cũng vô nghĩa nếu bạn không chạy được model trong workflow của mình.

Dù bạn:

- Chạy V3.2 local (qua PyTorch/Transformers), hay

- Dùng API với pattern reasoning + tool gọi liên tục,

thì gần như chắc chắn cần một môi trường Python sạch, ổn định.

Đặc biệt:

- V3.2 có logic API mới liên quan đến reasoning_content (chuỗi suy luận):

- Trong cùng một bài toán, bạn có thể muốn giữ lại chain này để model “nghĩ tiếp”.

- Khi bắt đầu bài toán mới, bắt buộc phải bỏ chuỗi suy luận cũ để tránh “nhiễm bẩn ngữ cảnh”.

- Kiểu logic này khó mà quản lý tốt nếu bạn không viết script, mà Python là lựa chọn tự nhiên.

Đây cũng là lúc python environment trở thành “hạ tầng” chứ không còn là chi tiết phụ.

Tại sao quản lý môi trường bỗng nhiên trở nên quan trọng?

Workflow điển hình khi bạn chơi với model như V3.2:

- Cài / nâng cấp Python.

- Cài thư viện:

openai,transformers,torch, v.v. - Thử stream, reasoning, gọi tool, tích hợp vào app.

- Lặp lại cho nhiều project, mỗi project một bộ dependency khác nhau.

Trên một máy, điều này rất dễ dẫn tới:

- Thư viện xung đột phiên bản,

- Môi trường gãy sau khi update OS / Python,

- Project A chạy, project B thì liên tục lỗi.

Thay vì lần nào cũng “đập đi làm lại”, bạn có thể dùng một nền tảng quản lý môi trường dev:

- Cho phép cài Python bằng vài click, không phải tự tay đi qua installer và homebrew,

- Mỗi môi trường tách biệt, muốn cài

torch,transformersthoải mái mà không phá Python hệ thống, - Hỗ trợ chạy song song nhiều phiên bản Python cho các project khác nhau.

ServBay là một ví dụ điển hình: tuy nhìn giống “tool web dev”, nhưng bản chất là một lớp quản lý môi trường, gom Python, web stack, DB, tool… vào các môi trường có thể reset, nhân bản, và tái sử dụng.

Ví dụ: Stream DeepSeek V3.2 với reasoning_content trong Python

Đoạn dưới đây minh họa cách gọi API DeepSeek‑style, lấy về reasoning chain và answer cuối:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.deepseek.com"

)

messages = [

{

"role": "user",

"content": "Hãy tính số Fibonacci thứ 10 và giải thích cách làm."

}

]

response = client.chat.completions.create(

model="deepseek-chat",

messages=messages,

stream=True,

)

print("DeepSeek V3.2 đang suy nghĩ...\n")

reasoning_content = ""

final_answer = ""

for chunk in response:

delta = chunk.choices.delta

# reasoning_content: chuỗi suy luận trung gian

rc = getattr(delta, "reasoning_content", None)

if rc:

reasoning_content += rc

# Trong production, thường log thay vì print

print(rc, end="", flush=True)

# content: câu trả lời cuối cho người dùng

if delta.content:

final_answer += delta.content

print(delta.content, end="", flush=True)

print("\n\n---\nChuỗi suy luận đầy đủ (phục vụ log/debug):\n")

print(reasoning_content)

Một vài lưu ý khi dùng thực chiến:

- Cùng một bài toán, bước tiếp theo:

Có thể truyền lại một phầnreasoning_contentnếu muốn model “tiếp tục suy nghĩ từ chỗ đang dở”. - Bài toán hoàn toàn mới:

Nên không gửi lại suy luận cũ, tránh làm bẩn ngữ cảnh.

Tất cả những điều này sẽ dễ làm hơn nhiều nếu môi trường Python của bạn:

- Ổn định,

- Có thể tái tạo,

- Không bị “đụng nhẹ là vỡ”.

Developer nên làm gì với V3.2?

DeepSeek V3.2 đáng chú ý không chỉ vì điểm benchmark cao, mà vì:

- Khiến long‑context + reasoning + tool trở nên rẻ hơn,

- Thách thức luận điểm “model open luôn đi sau”,

- Đưa hiệu quả tính toán (compute efficiency) lên thành ưu tiên hàng đầu.

Nhưng để tận dụng được những điều đó, bạn cần một môi trường dev đủ tử tế, đặc biệt là Python.

Nếu bạn muốn nghiêm túc thử:

- Streaming reasoning,

- Agent có tool calling phức tạp,

- Deploy V3.2 local hoặc hybrid,

thì đầu tư một chút vào python environment rõ ràng, thay vì trông chờ vào brew, pip và may mắn, sẽ giúp bạn tiết kiệm rất nhiều thời gian sửa lỗi vặt.

Model thì ngày càng thông minh. Câu hỏi là: môi trường dev của bạn có theo kịp, hay sẽ trở thành mắt xích yếu nhất trong stack AI?

All rights reserved