Biến Mô Hình AI Thành Bạn Cùng Phòng Hoàn Hảo! (ServBay+Ollama+ChatBox)

Lời mở đầu:

Gần đây, DeepSeek trở nên phổ biến đến mức ai cũng muốn thử. Sự xuất hiện của DeepSeek có thể nói đã khơi dậy một cơn sốt AI trên toàn quốc. Ban đầu, tôi nghĩ việc triển khai DeepSeek cục bộ sẽ rất khó khăn, nhưng sau khi thử nghiệm, hóa ra lại khá đơn giản. Quá trình này dễ dàng như cài đặt phần mềm mới trên máy tính của bạn và chỉ mất khoảng mười phút để hoàn thành việc triển khai cục bộ. Hôm nay, hãy cùng nói về cách triển khai mô hình DeepSeek-R1-1.5B cục bộ trên máy tính của bạn. Tổng Quan Các Bước Cài Đặt:

- Cài đặt ServBay: Tại sao phải cài đặt nó? Vì nó cho phép bạn cài đặt Ollama bằng một cú nhấp chuột và cài đặt DeepSeek bằng một cú nhấp chuột.

- Cài đặt một GUI hỗ trợ Ollama: Giao diện dòng lệnh không thân thiện với người dùng? Đừng lo lắng, chúng tôi đã chuẩn bị sẵn GUI hoàn hảo cho bạn.

- Bắt đầu cuộc trò chuyện liền mạch với DeepSeek!

Ⅰ. Tại Sao Nên Triển Khai DeepSeek Cục Bộ?

Một số bạn có thể có cùng trải nghiệm với tôi—thường xuyên gặp thông báo "Máy chủ bận, vui lòng thử lại sau" khi sử dụng DeepSeek. Tuy nhiên, với việc triển khai cục bộ, vấn đề này đơn giản là không tồn tại.

Tôi khuyên mọi người nên triển khai mô hình DeepSeek-R1-1.5B. Tại sao lại là phiên bản này? Đây là lý do:

- Nhỏ Gọn và Hiệu Quả: DeepSeek-R1-1.5B là một mô hình nhẹ với chỉ 1,5 tỷ tham số. Nghe có vẻ "nhỏ bé", phải không? Nhưng đừng đánh giá thấp nó—đây là một mô hình "nhỏ nhưng có võ"! Nó chỉ cần 3GB VRAM để chạy, nghĩa là ngay cả những máy tính có cấu hình khiêm tốn cũng có thể xử lý dễ dàng. Hơn nữa, nó hoạt động đặc biệt tốt trong lý luận toán học, thậm chí vượt qua GPT-4o và Claude 3.5 trong một số bài kiểm tra. Tất nhiên, nếu máy tính của bạn có cấu hình cao hơn, bạn có thể chọn các phiên bản khác.

- Tính Linh Hoạt Cao Hơn: Các mô hình lớn được triển khai cục bộ cung cấp tính linh hoạt cao hơn vì chúng thường không bị giới hạn bởi các nền tảng bên ngoài. Người dùng có toàn quyền kiểm soát hành vi và nội dung của mô hình.

- Không Kiểm Duyệt Nội Dung: Các mô hình lớn được truy cập thông qua các lệnh gọi API có thể phải đối mặt với các hạn chế từ chính sách nội dung của nhà cung cấp dịch vụ (ví dụ: ChatGPT của OpenAI giới hạn phản hồi về các chủ đề nhạy cảm). Tuy nhiên, các mô hình được triển khai cục bộ có thể được điều chỉnh dựa trên nhu cầu của người dùng, cho phép thảo luận về nhiều chủ đề hơn.

- Bảo Vệ Quyền Riêng Tư: Tất cả dữ liệu được xử lý cục bộ mà không cần tải lên đám mây, làm cho nó phù hợp với các trường hợp có yêu cầu bảo mật dữ liệu cao.

- Toàn Quyền Kiểm Soát: Người dùng có toàn quyền kiểm soát môi trường thời gian chạy của mô hình, đầu vào và đầu ra dữ liệu, cũng như các bản cập nhật và tối ưu hóa của mô hình. Tóm lại, việc triển khai cục bộ loại bỏ các lỗi phản hồi và nâng cao đáng kể sự hài lòng của người dùng. Người dùng có các yêu cầu khác có thể tham khảo nội dung bên dưới để có các tùy chọn thay thế.

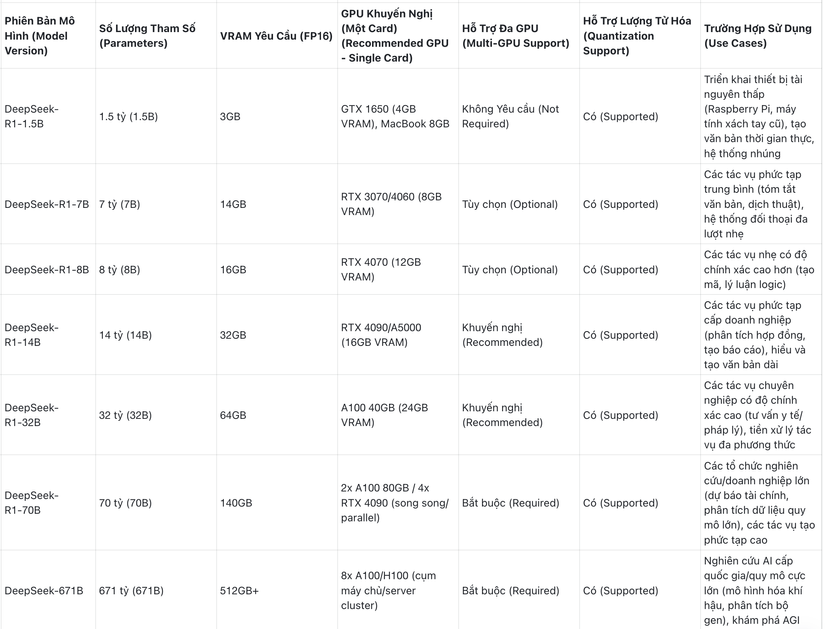

II. Yêu Cầu Phần Cứng Cho Các Phiên Bản DeepSeek Khác Nhau

Dưới đây là các yêu cầu phần cứng cho các phiên bản khác nhau của mô hình DeepSeek. Bạn có thể chọn phiên bản phù hợp nhất với cấu hình máy tính của bạn.

Ⅲ. Các Bước Triển Khai

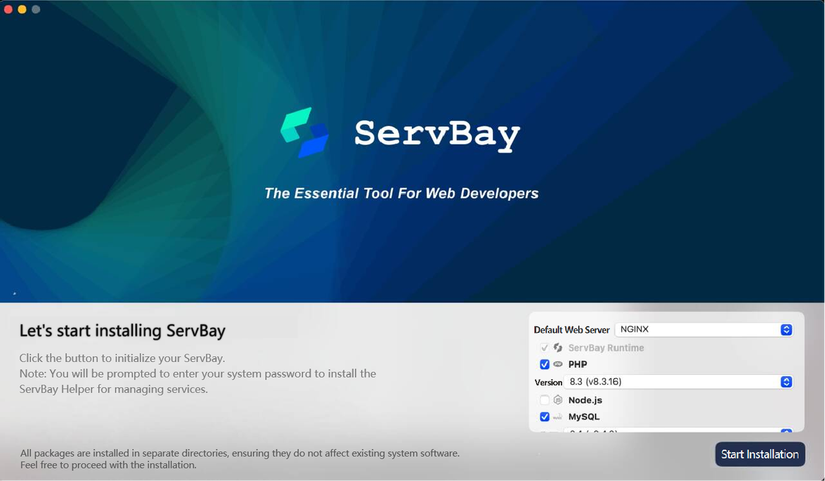

1. Tải xuống ServBay

Yêu cầu macOS 12.0 Monterey trở lên. Hiện tại, họ không hỗ trợ phiên bản Windows, nhưng theo tuyên bố chính thức, nó sẽ sớm ra mắt.

Tải xuống phiên bản ServBay mới nhất

Tệp cài đặt chỉ có 20MB.

Các Bước Cài Đặt:

Tệp cài đặt chỉ có 20MB.

Các Bước Cài Đặt:

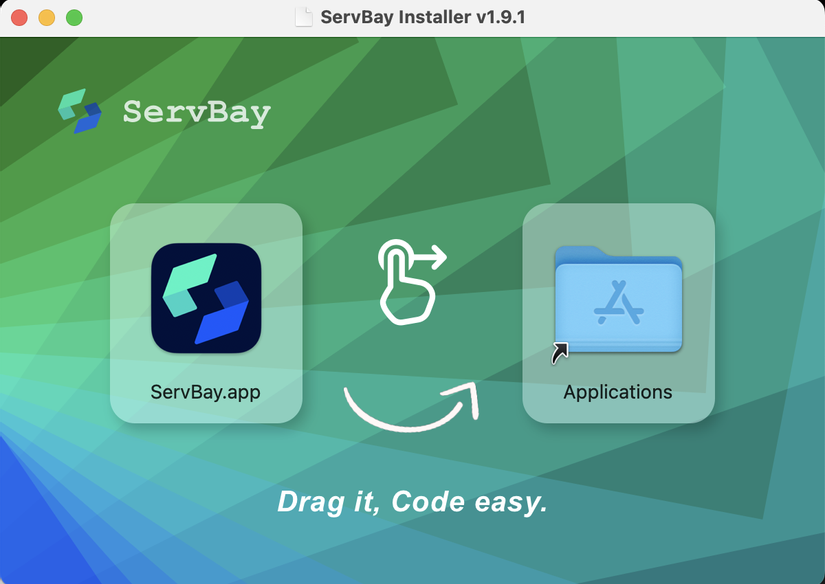

- Nhấp đúp vào tệp .dmg đã tải xuống.

- Trong cửa sổ mở ra, kéo biểu tượng ServBay.app vào thư mục Applications.

- Khi sử dụng ServBay lần đầu tiên, cần phải khởi tạo.

Chọn Ollama bằng một cú nhấp chuột

Sau khi cài đặt xong, hãy mở ServBay để bắt đầu sử dụng.

Sau khi cài đặt xong, hãy mở ServBay để bắt đầu sử dụng.

- Nhập mật khẩu. Sau khi cài đặt xong, bạn có thể tìm thấy ServBay trong thư mục Applications.

- Truy cập giao diện chính.

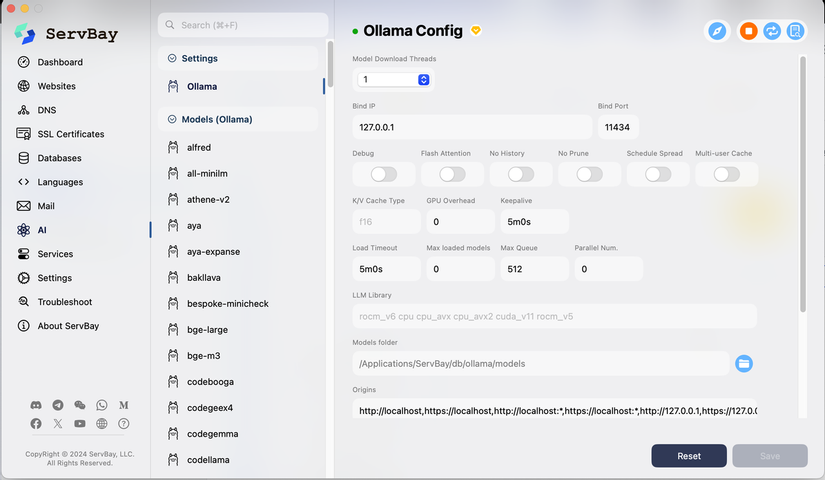

Ban đầu, Ollama yêu cầu một quy trình phức tạp để cài đặt và khởi động dịch vụ, nhưng với ServBay, bạn có thể bắt đầu chỉ với một cú nhấp chuột, cài đặt các mô hình AI bạn cần và không còn phải lo lắng về việc định cấu hình các biến môi trường. Ngay cả những người dùng bình thường không có kiến thức về phát triển cũng có thể sử dụng nó chỉ với một cú nhấp chuột. Khởi động và dừng bằng một cú nhấp chuột, tải xuống mô hình nhanh chóng đa luồng và miễn là hệ thống macOS của bạn đủ, bạn có thể chạy đồng thời nhiều mô hình AI lớn.

Ghi nhớ đường dẫn cục bộ và số cổng của Ollama:

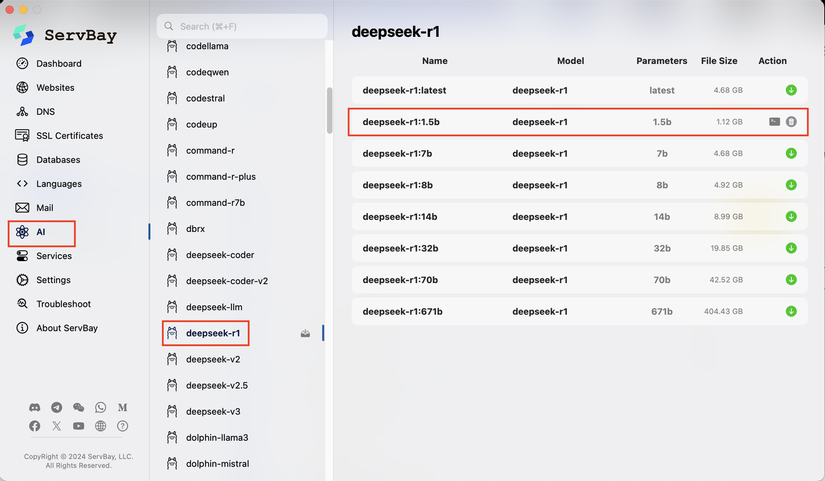

Tải xuống DeepSeek bằng một cú nhấp chuột

Tải xuống DeepSeek bằng một cú nhấp chuột

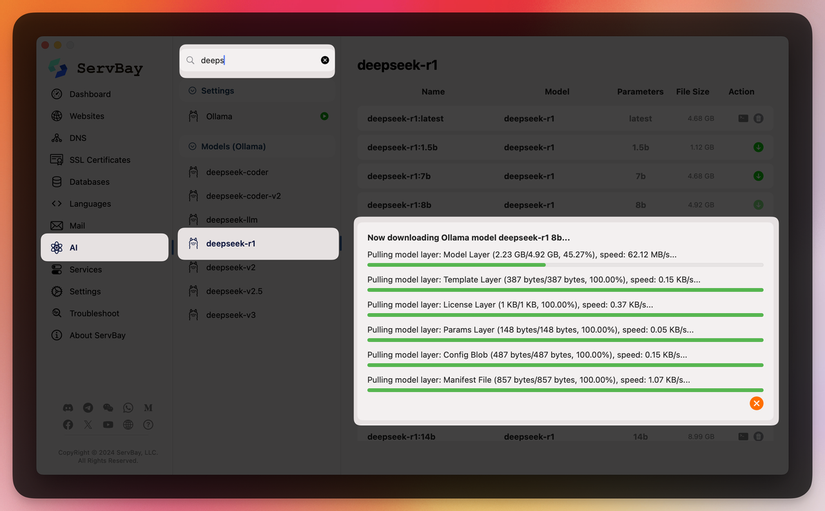

Trên máy tính của tôi, tốc độ tải xuống DeepSeek8B thậm chí còn vượt quá 60MB/giây, hoàn toàn vượt qua các công cụ tương tự khác.

Trên máy tính của tôi, tốc độ tải xuống DeepSeek8B thậm chí còn vượt quá 60MB/giây, hoàn toàn vượt qua các công cụ tương tự khác.

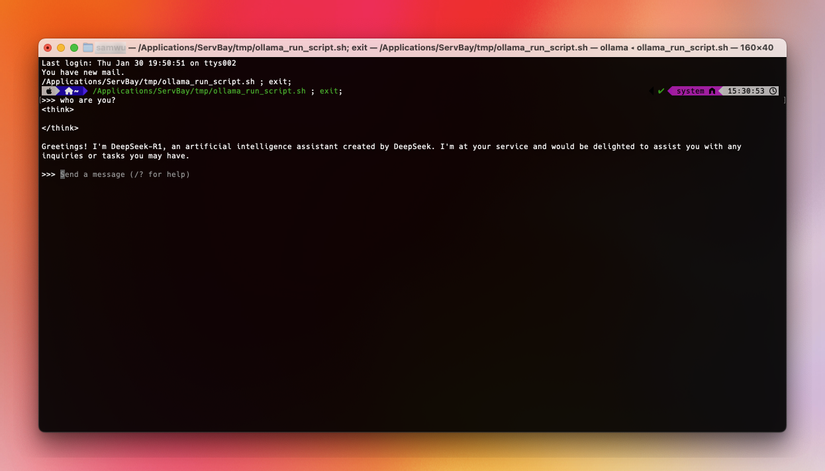

Với ServBay và Ollama, tôi đã có thể triển khai DeepSeek cục bộ. Nhìn xem, nó đang chạy trơn tru!

Với ServBay và Ollama, tôi đã có thể triển khai DeepSeek cục bộ. Nhìn xem, nó đang chạy trơn tru!

Bằng cách này, chúng ta đã đạt được việc triển khai các mô hình lớn cục bộ bằng ServBay + Ollama. Tuy nhiên, hiện tại nó bị giới hạn ở dòng lệnh và chưa có GUI!

Bằng cách này, chúng ta đã đạt được việc triển khai các mô hình lớn cục bộ bằng ServBay + Ollama. Tuy nhiên, hiện tại nó bị giới hạn ở dòng lệnh và chưa có GUI!

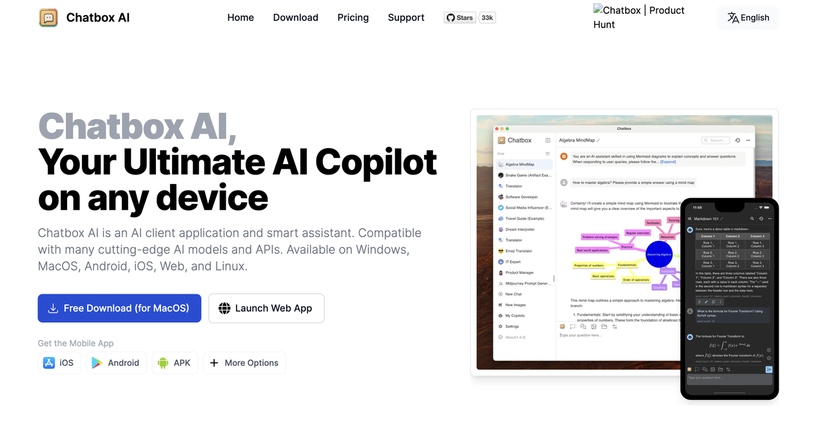

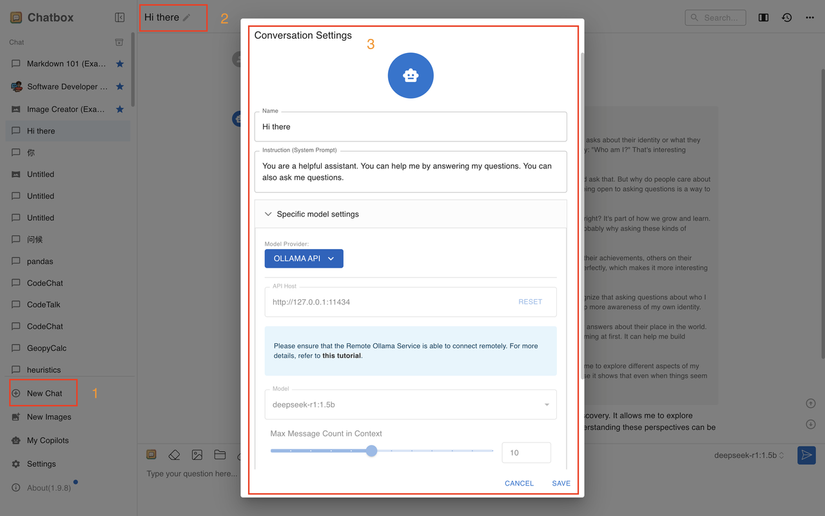

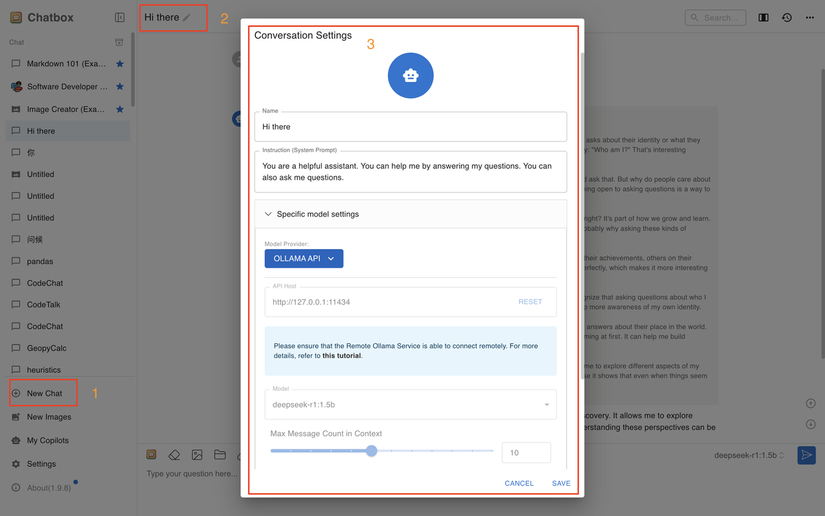

2. Đề xuất GUI - Chatbox (Đã kiểm tra cá nhân, lựa chọn tốt nhất)

Chatbox dễ sử dụng (Miễn phí, mạnh mẽ, hỗ trợ tải lên tệp, Xếp hạng đề xuất: 🌟🌟🌟🌟🌟).

Tải xuống Chatbox

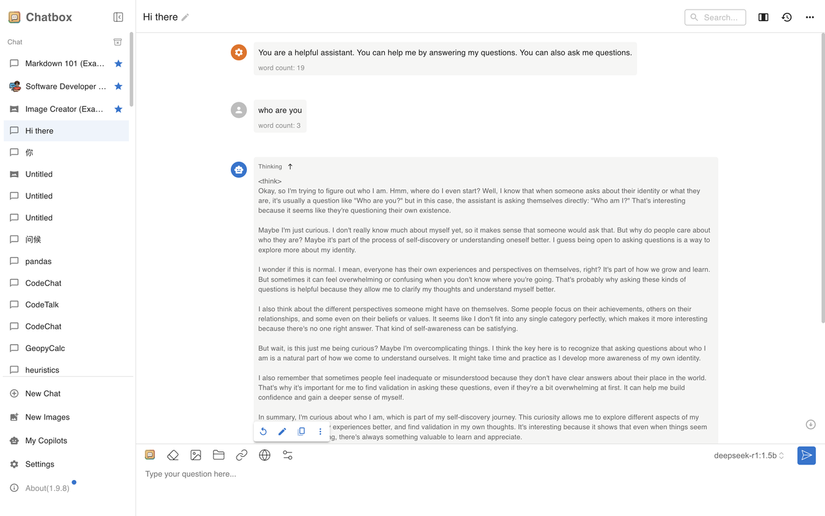

Sau khi tải xuống, truy cập giao diện chính:

Sau khi tải xuống, truy cập giao diện chính:

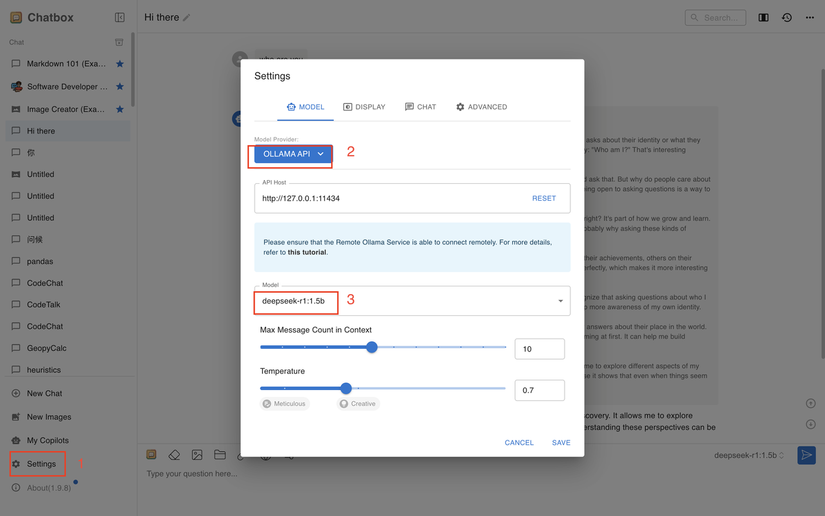

Nhấp vào cài đặt và làm theo các bước để sửa đổi.

Nhấp vào cài đặt và làm theo các bước để sửa đổi.

Lưu thay đổi và bạn có thể bắt đầu cuộc trò chuyện. Bạn sẽ thấy rằng các sửa đổi đã được áp dụng thành công.

Lưu thay đổi và bạn có thể bắt đầu cuộc trò chuyện. Bạn sẽ thấy rằng các sửa đổi đã được áp dụng thành công.

Với điều này, chúng ta đã hoàn thành việc triển khai đầy đủ mô hình DeepSeek-R1-1.5B dựa trên ServBay.

Với điều này, chúng ta đã hoàn thành việc triển khai đầy đủ mô hình DeepSeek-R1-1.5B dựa trên ServBay.

Tóm tắt:

Các bạn, việc triển khai cục bộ mô hình DeepSeek-R1-1.5B bằng ServBay có phải là vô cùng dễ dàng không? Bằng cách làm theo các bước trên, chỉ mất 10 phút để biến máy tính của bạn thành một "trợ lý thông minh". Hơn nữa, mô hình này không chỉ chạy hiệu quả mà còn có thể tạo ra tác động lớn trong nhiều tình huống khác nhau. Hãy thử ngay nhé!

All rights reserved