So sánh các mô hình Embedding cho tiếng Việt qua Benchmark 2025

Trong các hệ thống AI Agent hiện đại từ truy vấn ngữ nghĩa, RAG pipeline, đến chatbot doanh nghiệp lớp embedding luôn đóng vai trò trung tâm. Với tiếng Việt, thách thức lớn nhất không nằm ở mô hình, mà nằm ở dữ liệu huấn luyện và đặc trưng ngôn ngữ. Bài viết dưới đây tổng hợp các mô hình embedding dành cho tiếng Việt đang được sử dụng nhiều nhất năm 2025 và trình bày kết quả benchmark trực tiếp trên các bộ dữ liệu chuẩn.

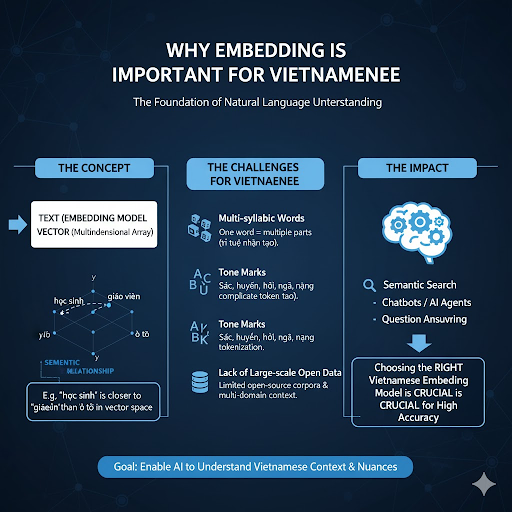

Vì sao embedding cho tiếng Việt đòi hỏi cách tiếp cận riêng?

Embedding là bước chuyển văn bản thành vector số sao cho mô hình có thể đo lường quan hệ ngữ nghĩa. Với tiếng Việt, độ phức tạp tăng cao do:

- Một “từ” có thể gồm nhiều âm tiết, bị tách bằng khoảng trắng → tokenizer khó nhận diện đơn vị ngữ nghĩa thật.

- Hệ thống dấu thanh tạo ra số lượng biến thể lớn → yêu cầu chuẩn hóa thống nhất.

- Dữ liệu mở thiếu tính đa miền, dẫn đến embedding dễ lệch ngữ cảnh.

Do đó, mô hình embedding tiếng Việt muốn đạt hiệu quả cần được tinh chỉnh trên tập dữ liệu thuần Việt hoặc dữ liệu có ngữ cảnh gần với miền sử dụng thực tế (task-specific domain).

Danh sách mô hình embedding tiếng Việt phổ biến năm 2025

Dưới đây là bốn mô hình được cộng đồng AI trong nước sử dụng nhiều nhất hiện nay:

| Mô hình | PhoBERT (VinAI) | ViEmbedding (VietAI) | bge-vi-base (BAAI fine-tuned) | sBERT-Vi (Sentence-BERT Việt hóa) |

|---|---|---|---|---|

| Kiến trúc | RoBERTa | fastText cải tiến | BGE (General Embedding) | PhoBERT fine-tuned theo STS-Vi |

| Đặc trưng | Huấn luyện từ 20GB dữ liệu Việt | Word embedding + xử lý OOV | Fine-tune trên hàng triệu cặp QA tiếng Việt | Tối ưu cho Textual Similarity |

| Ưu điểm | Hiểu tốt ngữ pháp, ổn định khi fine-tune | Nhẹ, tốc độ cao, phù hợp device hạn chế | Hiệu năng cao nhất cho retrieval | Mạnh trong so sánh câu – matching |

| Use-case | Classification, chatbot | Ứng dụng thời gian thực, mobile, rule-based | Semantic search, RAG, AI Agent | Q&A, hội thoại đa lượt |

Thiết lập benchmark và tiêu chí đánh giá

Tập dữ liệu đánh giá:

- ViSim-400

- STS-Vi

- UIT-ViQuAD (QA Việt)

Môi trường thử nghiệm:

- GPU: NVIDIA A100

- Batch size: 32

- Thời gian đo trên 1 GPU, không dùng FP16 để tránh sai số tương tự ngữ nghĩa.

Chỉ số so sánh:

- Cosine Similarity Accuracy

- MRR@10 (retrieval)

- Inference throughput (câu/giây)

- Kích thước vector

Kết quả Benchmark Embedding Việt 2025

| Mô hình | Accuracy (STS-Vi) | MRR@10 | Tốc độ (sent/s) | Dim |

|---|---|---|---|---|

| PhoBERT | 0.82 | 0.77 | 1,200 | 768 |

| ViEmbedding | 0.74 | 0.69 | 2,200 | 300 |

| bge-vi-base | 0.88 | 0.84 | 950 | 768 |

| sBERT-Vi | 0.86 | 0.81 | 1,100 | 768 |

Đánh giá tổng quát

- bge-vi-base cho kết quả cao nhất ở cả cặp tác vụ similarity + retrieval → phù hợp nhất cho vector search / semantic search / RAG.

- sBERT-Vi chỉ thấp hơn ~2%, nhưng xử lý nhanh hơn, đặc biệt hữu ích khi cần scaling ở tốc độ cao.

- PhoBERT vẫn ổn định cho classification hoặc bài toán yêu cầu fine-tune.

- ViEmbedding tuy độ chính xác thấp hơn nhưng vượt trội về tốc độ → tối ưu cho device giới hạn tài nguyên (IoT, CPU-bound server).

Gợi ý mô hình theo mục tiêu kỹ thuật

| Mục tiêu ứng dụng | Mô hình đề xuất | Giải thích |

|---|---|---|

| Chatbot đa ngữ cảnh / trợ lý ảo | sBERT-Vi hoặc PhoBERT | Giữ ngữ nghĩa hội thoại tốt, embedding ổn định |

| Semantic search / RAG | bge-vi-base | Retrieval + similarity vượt trội |

| Classification / sentiment | PhoBERT | Dễ fine-tune, baseline mạnh |

| Ứng dụng nhẹ / mobile / thiết bị hạn chế | ViEmbedding | Kích thước nhỏ, tốc độ tối đa |

Ví dụ tích hợp nhanh (Python)

from sentence_transformers import SentenceTransformer, util

model = SentenceTransformer("BAAI/bge-vi-base")

texts = ["Tôi đang nghiên cứu học máy.", "Machine learning là lĩnh vực rất thú vị."]

vectors = model.encode(texts, convert_to_tensor=True)

score = util.cos_sim(vectors[0], vectors[1])

print(f"Semantic similarity: {score.item():.4f}")

Chiến lược dùng đa mô hình trong hệ thống RAG

Trong các hệ thống lớn (search engine nội bộ, chatbot doanh nghiệp, tri thức tự động…), việc dùng nhiều lớp embedding mang lại hiệu quả tốt hơn dùng một mô hình duy nhất:

- Lọc thô (pre-filtering): ViEmbedding → rất nhanh, giảm số lượng tài liệu trước khi ranking.

- Lọc tinh (reranking / semantic ranking): bge-vi-base hoặc sBERT-Vi → bảo đảm chất lượng truy vấn.

- Lưu trữ vector: FAISS, ChromaDB, Pinecone.

Cách tiếp cận này giảm hơn 40–60% thời gian truy vấn nhưng vẫn giữ độ chính xác cao.

Kết luận

Embedding là nền móng của toàn bộ pipeline xử lý ngôn ngữ tiếng Việt. Chọn mô hình không phù hợp có thể khiến hệ thống chậm, sai lệch ngữ nghĩa hoặc tiêu tốn tài nguyên không cần thiết. Dựa trên benchmark 2025, các khuyến nghị chính gồm:

- bge-vi-base → lựa chọn tối ưu cho semantic retrieval và RAG.

- sBERT-Vi → phù hợp chatbot và các tác vụ so khớp câu.

- PhoBERT → dễ tùy biến, mạnh khi cần fine-tune theo domain.

- ViEmbedding → thích hợp cho môi trường hạn chế tài nguyên.

Trong thời gian tới, khi embedding tiếng Việt được huấn luyện trên tập dữ liệu quy mô lớn hơn và kết hợp trực tiếp cùng LLM, chúng ta có thể kỳ vọng vào các hệ thống AI Agent hiểu ngữ cảnh tốt hơn và phản hồi chính xác hơn với đặc trưng của ngôn ngữ Việt.

Nguồn tham khảo: https://bizfly.vn/techblog/so-sanh-cac-mo-hinh-embedding-cho-tieng-viet-qua-benchmark.html

All rights reserved