[Machine Learning] Một số nguồn hay cho việc tìm hiểu cơ chế "Attention"

Bài đăng này đã không được cập nhật trong 2 năm

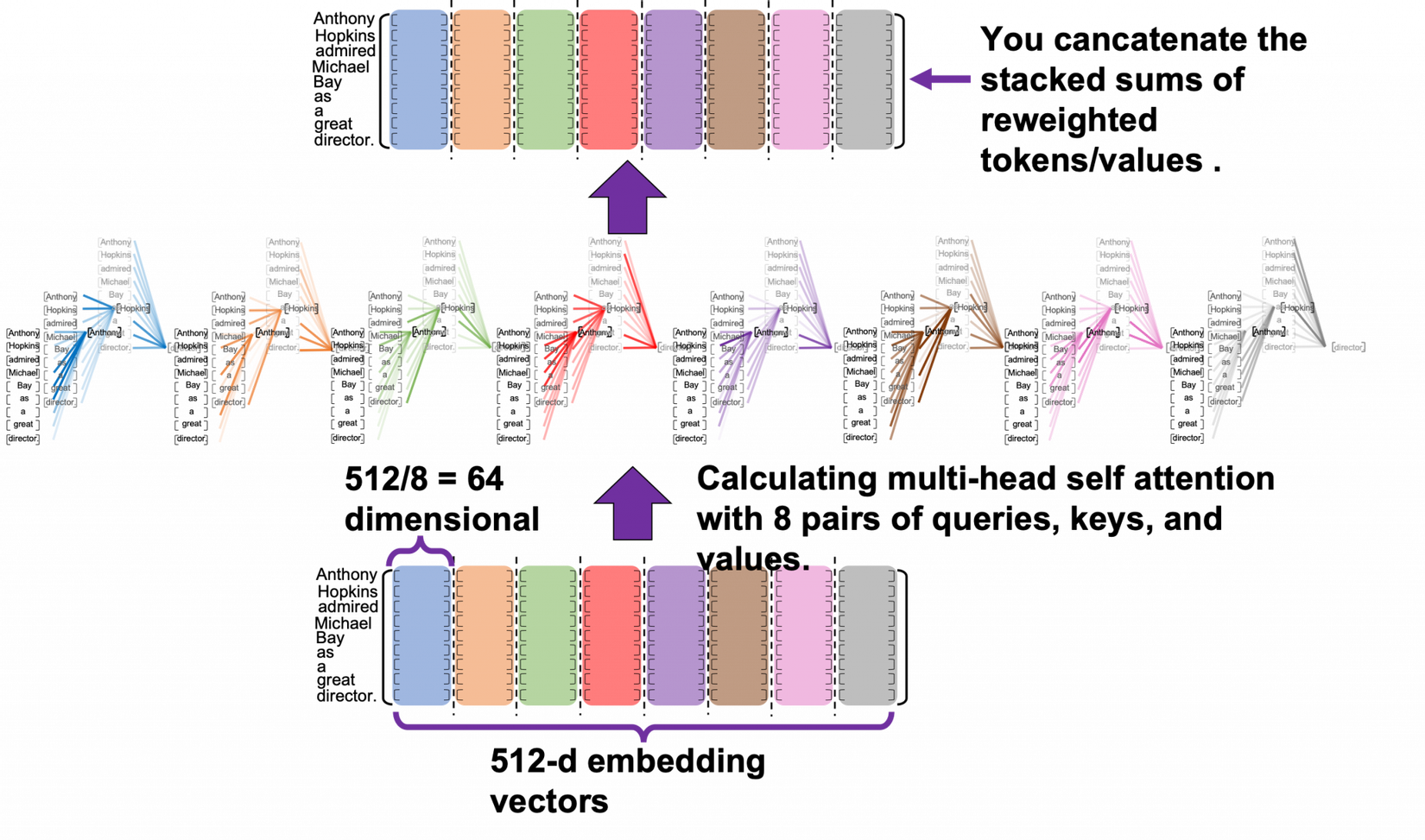

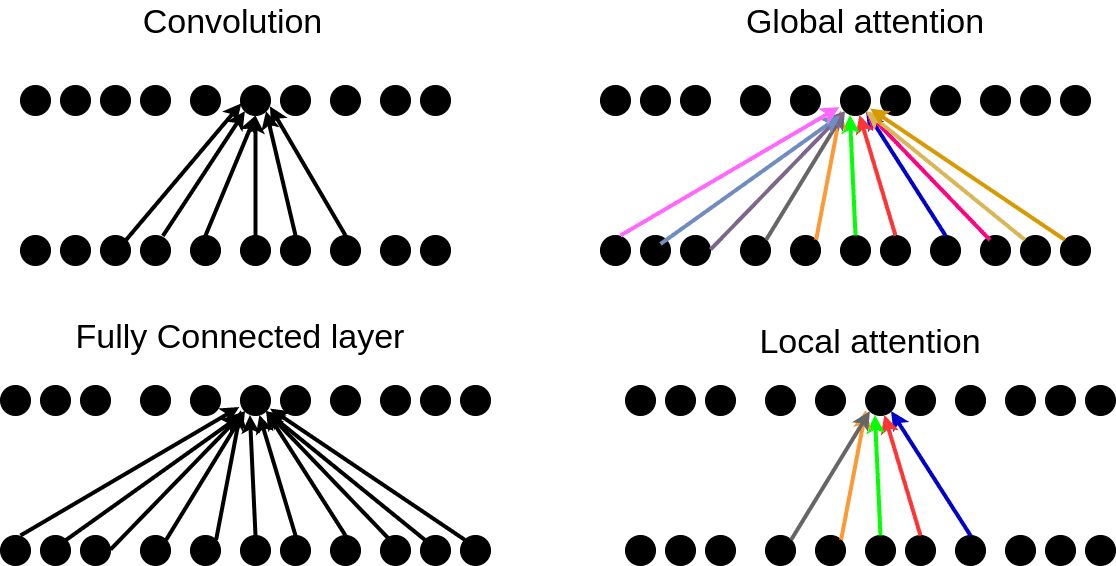

head-attention-mechanism

https://data-science-blog.com/blog/2021/04/07/multi-head-attention-mechanism/

Giải thích về mặt toán học cơ chế head attention.

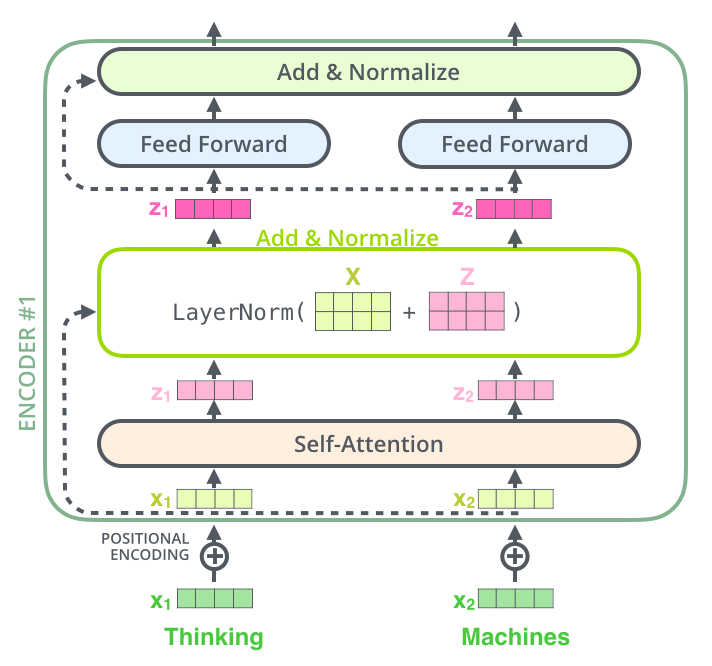

The Illustrated Transformer

http://jalammar.github.io/illustrated-transformer/

Giải thích khá hay, có ví dụ minh hoạ trực quan cho cơ chế xác xuất của Transformer

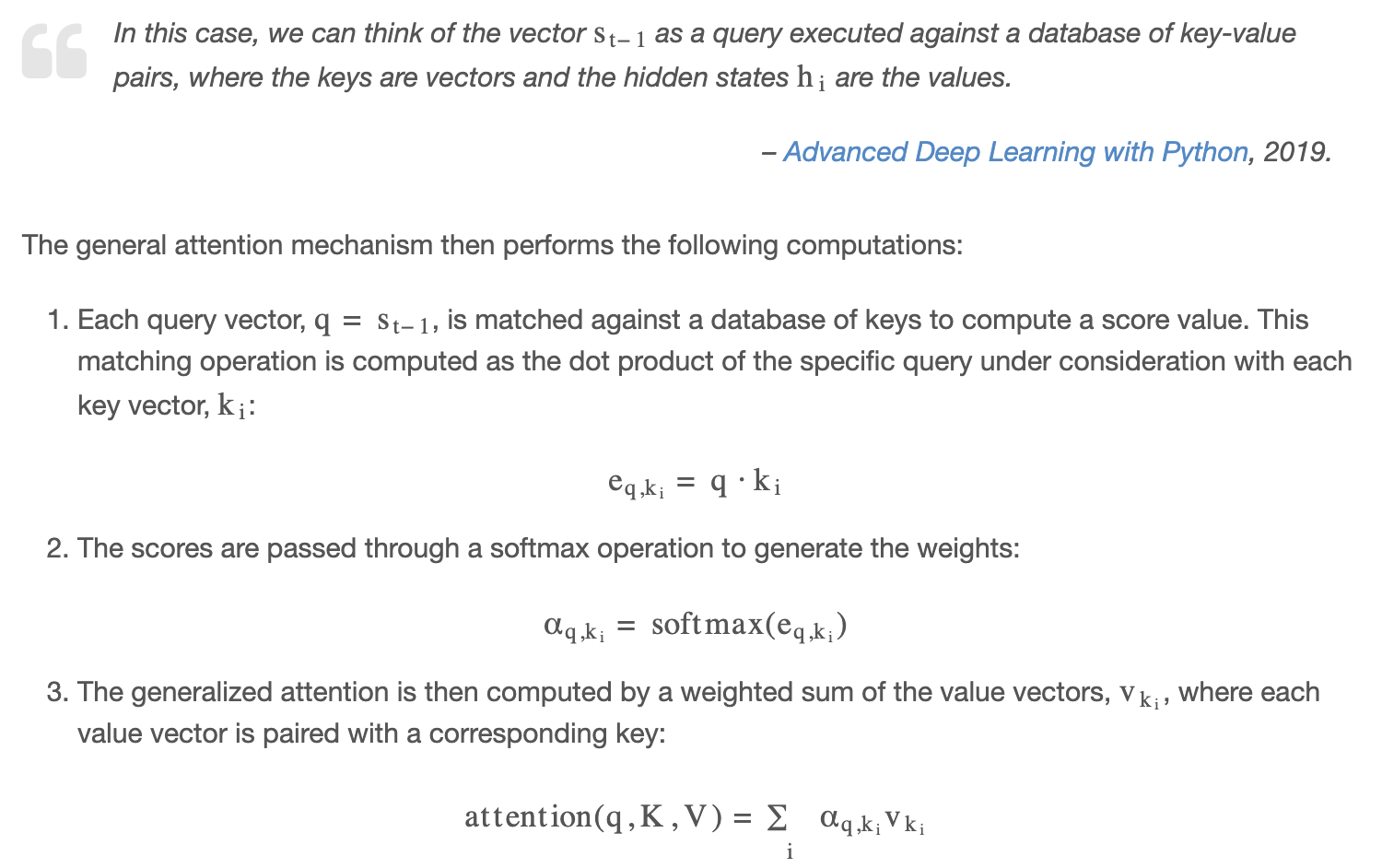

The Attention Mechanism from Scratch

https://machinelearningmastery.com/the-attention-mechanism-from-scratch/

Giải thích sơ về mặt toán học, có code ví dụ về python, khá sát với thực tiễn, xong khi đọc cũng khó hiểu cho các bạn mới

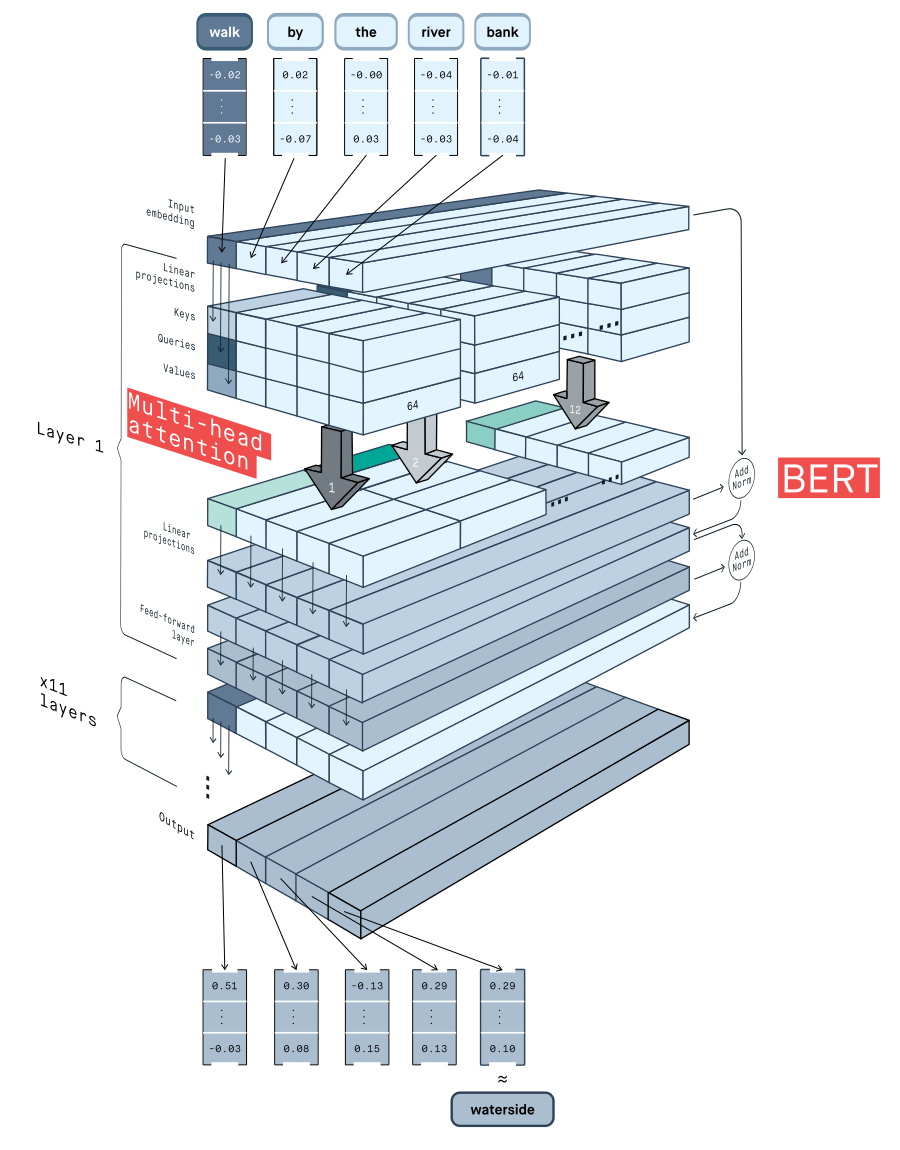

Getting meaning from text: self-attention step-by-step video

https://peltarion.com/blog/data-science/self-attention-video

Giải thích cũng khá dễ hiểu, có video hướng dẫn từng step, và mô hình visual nhìn cũng khá ổn

How Attention works in Deep Learning: understanding the attention mechanism in sequence models

Giải thích từng bước sự tiến hoá của các mô hình để đạt tới Attention method, qua đó chúng ta dễ có cách nhìn sâu sắc hơn về căn nguyên và các bước phát triển

https://theaisummer.com/attention/

Một số ứng dụng dùng mã nguồn gp2, code example nhanh chóng ứng dụng

https://www.datacamp.com/tutorial/an-introduction-to-using-transformers-and-hugging-face

All rights reserved