Data Input Standardization – Quy trình làm sạch và chuẩn hóa dữ liệu trước khi huấn luyện AI Agent

Trong bất kỳ hệ thống AI Agent nào, chất lượng dữ liệu đầu vào luôn là biến số ảnh hưởng mạnh nhất đến độ chính xác của mô hình. Dữ liệu thô khi thu thập từ nhiều nguồn thường chứa nhiễu, ký tự không hợp lệ, định dạng thiếu nhất quán hoặc xen lẫn nội dung không liên quan. Bài viết dưới đây trình bày quy trình chuẩn hóa dữ liệu theo hướng kỹ thuật, kèm theo các đoạn mã Python có thể tích hợp trực tiếp vào pipeline huấn luyện.

Vì sao cần chuẩn hóa dữ liệu trước khi huấn luyện AI Agent

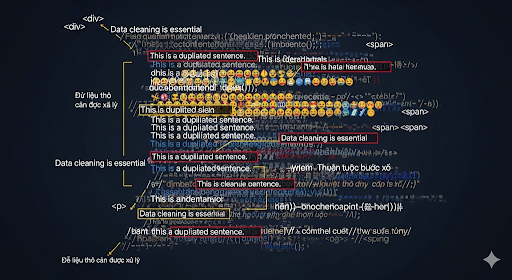

Trong thực tế, 70–80% lỗi của mô hình đến từ dữ liệu “bẩn”, không phải từ bản thân thuật toán. Tập dữ liệu chưa xử lý thường bao gồm văn bản copy từ web, HTML dư thừa, emoji, ký tự mã hóa sai chuẩn Unicode và thông tin trùng lặp. Khi đưa trực tiếp vào huấn luyện, mô hình sẽ học cả những thành phần không mong muốn, dẫn tới kết quả suy luận lệch ngữ cảnh.

Ví dụ dễ thấy nhất là khi huấn luyện chatbot thương mại điện tử: dữ liệu conversational crawl từ mạng xã hội có thể lẫn bình luận spam, icon cảm xúc, hoặc đoạn quảng cáo. Nếu không lọc bỏ đúng cách, AI sẽ phản hồi sai chủ đề hoặc tạo câu trả lời thiếu tự nhiên

Những dạng lỗi phổ biến trong dữ liệu văn bản

Trước khi viết pipeline preprocessing, cần nhận diện rõ các vấn đề thường xuất hiện:

- Ký tự không hợp lệ: emoji, ký tự đặc biệt, ký tự bị lỗi mã hóa.

- Duplicated content: đoạn văn hoặc câu lặp lại nhiều lần.

- Lỗi encoding: thường gặp khi dữ liệu lấy từ các trang web cũ hoặc file CSV không chuẩn UTF-8.

- Stopwords không cần thiết: một số tập dữ liệu cần giữ lại, nhưng nhiều trường hợp nên loại bỏ để giảm nhiễu.

- HTML tag & metadata:

<script>,<style>, comment, inline CSS… - Trộn ngôn ngữ: tiếng Việt xen lẫn tiếng Anh không đúng ngữ cảnh.

Hiểu đúng bản chất lỗi giúp xây dựng pipeline xử lý ổn định và mở rộng khi thêm nguồn dữ liệu mới.

Quy trình chuẩn hóa văn bản dành cho AI Agent

1. Loại bỏ ký tự rác

Sử dụng Regex để lọc các thành phần không thuộc văn bản:

import re

clean_text = re.sub(r"[^a-zA-Z0-9À-ỹ\s.,]", "", raw_text)

Regex trên giữ lại chữ cái tiếng Việt, chữ cái Latin, số và dấu câu cơ bản.

2. Chuẩn hóa định dạng

- Chuyển toàn bộ về chữ thường.

- Chuẩn hóa Unicode nhằm xử lý lỗi font và ký tự không đúng chuẩn.

text = text.lower().encode("utf-8").decode("utf-8")

3. NLP Preprocessing

Bao gồm tokenization, loại bỏ stopwords và chuẩn hóa từ vựng.

from underthesea import word_tokenize

tokens = word_tokenize(text, format="text")

- Tokenization: chia câu thành các đơn vị từ.

- Stopwords removal: giảm nhiễu với các từ không có giá trị ngữ nghĩa.

- Lemmatization: đưa các biến thể động từ về dạng gốc.

4. Xử lý HTML và metadata

Dữ liệu lấy từ web thường chứa hàng loạt tag dư thừa. Có thể dùng BeautifulSoup

from bs4 import BeautifulSoup

text_only = BeautifulSoup(html, "lxml").get_text()

5. Lưu trữ và tích hợp vào pipeline

- Lưu output thành

.json,.csvhoặc đưa vào database. - Index vào ElasticSearch để phục vụ RAG.

- Kết hợp Airflow/Prefect để chạy định kỳ theo batch.

Bộ script tiền xử lý đầy đủ (Python)

import re

from bs4 import BeautifulSoup

from underthesea import word_tokenize

def preprocess_text(raw_text):

# 1. Loại bỏ ký tự không hợp lệ

text = re.sub(r"[^a-zA-Z0-9À-ỹ\s.,]", "", raw_text)

# 2. Chuẩn hóa dạng chữ

text = text.lower().encode("utf-8").decode("utf-8")

# 3. Loại bỏ HTML

text = BeautifulSoup(text, "lxml").get_text()

# 4. Tokenize

tokens = word_tokenize(text, format="text")

return tokens

Script này có thể sử dụng trực tiếp trong ETL pipeline hoặc tích hợp với các bước vector hóa và embedding trước khi huấn luyện.

Lợi ích doanh nghiệp khi chuẩn hóa dữ liệu

- Tối ưu chi phí huấn luyện: mô hình không phải xử lý lượng lớn nội dung rác.

- Tăng độ chính xác: AI học đúng thông tin, không bị nhiễu từ dữ liệu không cần thiết.

- Cải thiện chất lượng phản hồi: đặc biệt quan trọng với chatbot và AI Agent giao tiếp tự nhiên.

- Dễ mở rộng: khi có pipeline chuẩn, việc bổ sung nguồn dữ liệu mới trở nên đơn giản và có kiểm soát.

Kết luận

Chuẩn hóa dữ liệu là một bước bắt buộc trong bất kỳ dự án AI Agent nào. Với bộ script và quy trình trên, bạn có thể xây dựng một pipeline làm sạch dữ liệu ổn định, nhất quán và dễ tái sử dụng. Việc đầu tư vào khâu tiền xử lý không chỉ nâng chất lượng mô hình mà còn tiết kiệm đáng kể tài nguyên tính toán về lâu dài.

Nguồn tham khảo: https://bizfly.vn/techblog/chuan-hoa-du-lieu-dau-vao-truoc-khi-huan-luyen-ai-agent.html

All rights reserved