Chiến lược cập nhật embedding khi dữ liệu thay đổi trong Vector Database

Trong các hệ thống AI Agent, đặc biệt là các pipeline RAG, Agent hoặc Search-as-a-Service dữ liệu không đứng yên. Nội dung bị chỉnh sửa, metadata đổi phiên bản, tài liệu được hợp nhất hoặc loại bỏ. Khi nguồn dữ liệu dịch chuyển, embedding tương ứng trong Vector Database cũng phải được đồng bộ để đảm bảo kết quả truy vấn vẫn chính xác và nhất quán. Bài viết này đi sâu vào các chiến lược cập nhật embedding dành cho developer, giúp bạn thiết kế một quá trình update hiệu quả, có kiểm soát và tối ưu tài nguyên.

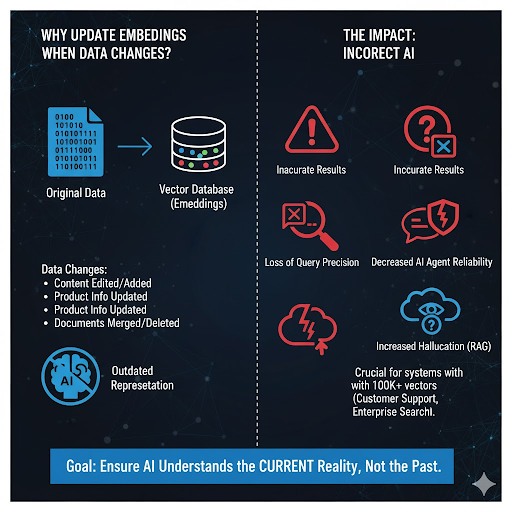

Vì sao việc cập nhật embedding là bắt buộc?

Embedding chỉ phản ánh ngữ nghĩa tại thời điểm vector được tạo. Khi bạn thay đổi nội dung nguồn, embedding cũ sẽ không còn đúng ngữ cảnh. Một số tình huống điển hình:

- Tài liệu được biên tập lại, bổ sung đoạn mới hoặc chỉnh sửa nội dung.

- Mô tả sản phẩm, giá, thuộc tính thay đổi.

- Admin gộp hai bài viết, xóa bản cũ hoặc cập nhật nội dung theo đợt.

Nếu không cập nhật lại vector:

- Kết quả truy vấn trở nên kém chính xác.

- AI Agent dễ trả về thông tin sai thực tế.

- Rủi ro "hallucination" gia tăng khi pipeline RAG không còn bám dữ liệu thật.

Việc này đặc biệt quan trọng trong hệ thống chứa hàng trăm nghìn hoặc hàng triệu embedding như trợ lý CSKH, search nội bộ hoặc nền tảng tri thức doanh nghiệp.

collection.add(

documents=["Nội dung cập nhật embedding"],

metadatas=[{"source": "blog", "version": 3}],

ids=["doc_123"]

)

Chính trường id và metadata là chìa khóa để xác định vector nào cần update khi dữ liệu nguồn thay đổi.

Ba chiến lược cập nhật embedding

3.1. Làm mới toàn bộ (Full Refresh)

Cách đơn giản nhất: xóa toàn bộ vector và tái tạo embedding cho toàn bộ dữ liệu.

Ưu điểm:

- Không cần hệ thống theo dõi thay đổi.

- Mọi vector luôn được làm mới đồng nhất.

Nhược điểm:

- Tốn compute lớn, thời gian xử lý lâu.

- Không phù hợp cho hệ thống có dữ liệu lớn hoặc cập nhật liên tục.

Ứng dụng: dataset nhỏ, tài liệu ổn định, yêu cầu đồng bộ nghiêm ngặt.

Cập nhật từng phần (Incremental Update)

Đây là chiến lược được dùng nhiều nhất. Quy trình:

- Xác định tài liệu thay đổi (thông qua id).

- Xóa vector cũ.

- Tạo embedding mới.

- Upsert vào Vector DB.

Ví dụ:

collection.delete(ids=["product_456"])

collection.add(

documents=["Nội dung đã chỉnh sửa"],

ids=["product_456"]

)

Ưu điểm: nhanh, tiết kiệm tài nguyên, phù hợp hệ thống CMS/eCommerce/CRM.

Nhược điểm: cần có cơ chế detection chính xác.

Versioning (theo dõi nhiều phiên bản embedding)

Không ghi đè embedding, mà tạo vector mới với phiên bản mới và đánh dấu phiên bản cũ là inactive.

collection.add(

documents=["Tài liệu v4"],

ids=["doc_123_v4"],

metadatas=[{"active": True, "version": 4}]

)

collection.update(ids=["doc_123_v3"], metadatas={"active": False})

Ưu điểm:

- Dễ rollback khi cần.

- Có thể so sánh giữa các version.

Nhược điểm: tốn dung lượng lưu trữ.

Ứng dụng: hệ thống nghiên cứu, audit, hoặc các pipeline đòi hỏi truy vết dữ liệu.

Cơ chế phát hiện dữ liệu thay đổi

Không thể để developer tự đoán khi nào nên cập nhật. Bạn cần cơ chế tự động:

Dựa trên timestamp / checksum

- Lưu last_updated_at.

- Sinh checksum nội dung để so sánh.

import hashlib

def hash_content(text):

return hashlib.md5(text.encode("utf-8")).hexdigest()

Checksum khác → cập nhật embedding.

Webhook / Event Trigger

CMS hoặc backend gửi event mỗi khi nội dung thay đổi:

{

"event": "document_updated",

"id": "doc_001",

"source": "blog"

}

Worker xử lý embedding dựa trên event.

Batch job định kỳ

Cron chạy 24h/lần, quét các bản ghi có thay đổi → update theo lô. Đây là lựa chọn phù hợp cho hệ thống lớn, pipeline phức tạp.

Xây dựng pipeline cập nhật embedding tự động

Một quy trình đầy đủ thường có 5 bước:

- Detect: phát hiện tài liệu thay đổi.

- Extract: lấy nội dung mới.

- Embed: tạo vector qua model (ví dụ text-embedding-3-large).

- Upsert/Delete: cập nhật vào Vector DB.

- Log/Monitor: ghi nhận version, thời gian, trạng thái.

Ví dụ Python:

from openai import OpenAI

import chromadb

client = OpenAI()

chroma = chromadb.Client()

collection = chroma.get_or_create_collection("docs")

def update_embedding(doc_id, content):

new_vector = client.embeddings.create(

input=content,

model="text-embedding-3-large"

).data[0].embedding

collection.delete(ids=[doc_id])

collection.add(

ids=[doc_id],

embeddings=[new_vector],

documents=[content],

metadatas=[{"updated_at": "2025-10-15"}]

)

Tối ưu hiệu suất cho hệ thống lớn

Với dataset lớn cần cân nhắc thêm:

- Batch update: gom 500–2000 tài liệu/lần để giảm overhead.

- Async embedding: xử lý qua hàng đợi (Kafka, Celery, RabbitMQ).

- Prioritize hot vectors: ưu tiên cập nhật tài liệu được truy vấn nhiều.

- Caching layer: giảm truy vấn trực tiếp đến vector DB.

- Index rebuild định kỳ (FAISS, Milvus) để tránh phân mảnh.

Chiến lược xóa vector

Việc xóa tài liệu không đơn giản chỉ là "delete":

- Nếu tài liệu bị xóa khỏi hệ thống → xóa vector ngay.

- Nếu chỉ ẩn (soft delete) → gắn metadata active: False.

- Với FAISS/Milvus → cần compact lại index theo chu kỳ.

Kết luận

Cập nhật embedding là một hoạt động trọng yếu trong mọi pipeline AI/RAG. Để giữ hệ thống chính xác, ổn định và tin cậy, developer cần một chiến lược rõ ràng:

- Incremental Update khi dữ liệu đổi thường xuyên.

- Versioning khi cần lưu lại lịch sử.

- Full Refresh cho dataset nhỏ hoặc ít biến động.

Kết hợp thêm một pipeline tự động và cơ chế phát hiện thay đổi sẽ giúp bạn duy trì tính toàn vẹn ngữ nghĩa và đảm bảo chất lượng cho toàn bộ hệ thống AI đang vận hành.

Nguồn tham khảo: https://bizfly.vn/techblog/chien-luoc-cap-nhat-embedding-khi-du-lieu-thay-doi-trong-vector-database.html

All rights reserved