Apache Airflow - Nền tảng tự động hóa pipeline dữ liệu

Đối với các Data Engineer, và thậm chí cả những ai hoạt động trong các lĩnh vực liên quan, chắc hẳn bạn đã từng nghe đến một công cụ mạnh mẽ giúp tự động hóa các luồng công việc dữ liệu. Apache Airflow cho phép bạn dễ dàng quản lý và giám sát toàn bộ quá trình vận hành pipeline của mình. Từ việc theo dõi tiến độ (progress), kiểm tra nhật ký (logs), kích hoạt nhiệm vụ (trigger tasks), cho đến trạng thái hoàn thành (success status), tất cả đều được quản lý trực quan và hiệu quả.

Trong bài viết này, mình sẽ giới thiệu chi tiết về Apache Airflow – cách nó hoạt động, những tính năng nổi bật, và tại sao nó trở thành "trợ thủ đắc lực" của Data Engineer trong việc quản lý dữ liệu hiện đại.

Giới thiệu Apache Airflow

Airflow một công cụ không thể thiếu cho việc quản lý dữ liệu thời đại hiện nay. Nó là là một công cụ mã nguồn mở, được thiết kế để xây dựng (developing), lập lịch (scheduling), và giám sát (monitoring) các workflow định hướng theo lô (batch-oriented workflows). Đây là một giải pháp không thể thiếu để xử lý các pipeline dữ liệu phức tạp, giúp đơn giản hóa việc tổ chức và triển khai các tác vụ tự động.

Airflow được phát triển bởi Airbnb vào năm 2014 và sau đó trở thành dự án của Apache Software Foundation, Airflow nhanh chóng trở thành một trong những công cụ phổ biến nhất dành cho Data Engineer và các chuyên gia dữ liệu.

Không chỉ dừng lại ở việc tự động hóa các pipeline dữ liệu. Khi làm việc với Airflow là tất cả các workflow được viết với code Python một ngôn ngữ rất dễ tiếp cận với người mới. Và điểm nổi bật của nó phục vụ một số mục đích như:

- Dynamic: Các pipeline trên Airflow được cấu hình bởi Python, cho phép tạo các đường ống động.

- Extensible: Framework Airflow chứa các toán tử để kết nối với nhiều công nghệ. Tất cả các thành phần Airflow đều có thể mở rộng để dễ dàng điều chỉnh cho phù hợp với môi trường của bạn.

- Flexible: Tham số hóa quy trình làm việc được tích hợp sẵn bằng cách tận dụng công cụ tạo khuôn mẫu Jinja.

Một trong những đặc điểm cốt lõi của Airflow là việc sử dụng Directed Acyclic Graphs (DAGs) để định nghĩa và quản lý các pipeline, chẳng hạn như:

- Trích xuất dữ liệu từ các nguồn khác nhau.

- Làm sạch và chuyển đổi dữ liệu.

- Lưu trữ dữ liệu vào kho dữ liệu hoặc đẩy sang hệ thống phân tích.

Việc tổ chức này không chỉ giúp bạn mang lại tính logic rõ ràng mà còn giúp đảm bảo độ chính xác và khả năng theo dõi cao trong toàn bộ quy trình.

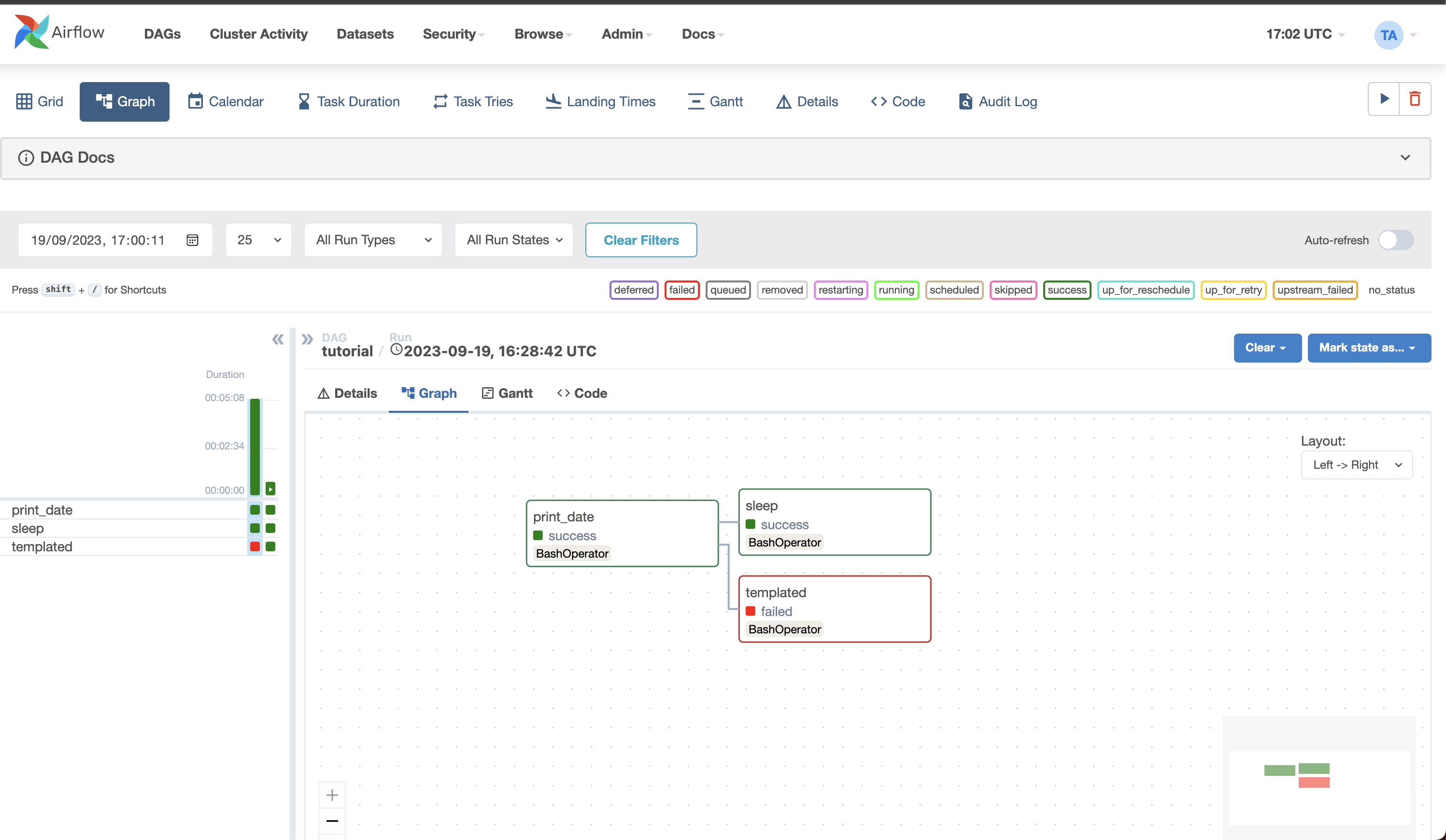

Apache Airflow còn có giao diện web giúp người dùng trong việc quản lý các task như:

-

Giám sát workflow: Dễ dàng xem trạng thái từng task (đang chạy, thành công, thất bại).

-

Theo dõi lịch sử task: Xem chi tiết log và xác định nguyên nhân lỗi.

-

Tích hợp lập lịch: Theo dõi và lên lịch chạy DAGs một cách dễ dàng, từ việc chạy hàng ngày, hàng giờ, cho đến chạy theo sự kiện. Ngoài ra Airflow tích hợp với nhiều dịch vụ, công cụ và hệ thống, bao gồm:

-

Cloud Services: AWS, Google Cloud, Azure.

-

Hệ quản trị cơ sở dữ liệu: PostgreSQL, MySQL, BigQuery, Snowflake.

-

Công cụ ETL/ELT: dbt, Spark, Hadoop.

Điều này giúp bạn dễ dàng đưa Airflow vào quy trình xử lý dữ liệu hiện có, tận dụng tối đa khả năng kết nối và mở rộng của nó.

Vai trò của Airflow trong ETL

Airflow là công cụ lý tưởng cho việc quản lý quy trình ETL (Extract, Transform, Load). Với nền tảng Python mạnh mẽ và cấu trúc DAG, nó giúp bạn tự động hóa, theo dõi và tối ưu hóa các pipeline ETL một cách hiệu quả.

Dưới đây mình sẽ ví dụ một job đơn giản về quy trình ETL sử dụng airflow trích xuất dữ liệu thời tiết rồi đẩy vào kho dữ liệu.

Giai đoạn Extract (Trích xuất dữ liệu):

- Lập lịch tự động: Airflow có thể tự động hóa việc trích xuất dữ liệu định kỳ, ví dụ: thu thập dữ liệu hàng giờ từ một API OpenWeather

- Tích hợp đa nguồn: Airflow dễ dàng kết nối và thu thập dữ liệu từ nhiều nguồn khác nhau bằng cách sử dụng các operator.

- Theo dõi và quản lý lỗi: Nếu quá trình trích xuất thất bại, Airflow sẽ ghi log chi tiết và hỗ trợ cơ chế retry để đảm bảo task hoàn thành. Giai đoạn Transform (Chuyển đổi dữ liệu)

- Xử lý dữ liệu: Với PythonOperator, Airflow cho phép bạn tích hợp các tập lệnh Python để làm sạch và chuyển đổi dữ liệu.

- Tích hợp: Đối với các pipeline lớn, Airflow có thể tích hợp với các tool xử lý dữ liệu khác như DBT. Một công cụ rất phổ biết hiện nay bạn có thể tham khảo thêm bài viết giới thiệu về DBT tại đây.

- Quản lý phụ thuộc: Airflow đảm bảo rằng các task được chạy đúng thứ tự, ví dụ: task làm sạch dữ liệu phải hoàn thành trước khi bắt đầu chuyển đổi dữ liệu. Giai đoạn Load (Tải dữ liệu)

- Tải dữ liệu tự động: Airflow cung cấp các operator để tải dữ liệu lên kho lưu trữ như S3, BigQuery hoặc Snowflake.

- Quản lý hiệu suất: Với kiến trúc mở rộng linh hoạt, Airflow xử lý tốt các batch dữ liệu lớn mà không làm gián đoạn pipeline.

- Thông báo và báo cáo: Sau khi tải dữ liệu, Airflow có thể gửi thông báo (email, Slack) để xác nhận quá trình thành công hoặc cảnh báo khi xảy ra lỗi.

Tại sao là Airflow?

Apache Airflow sở hữu một cộng đồng người dùng lớn và ngày càng phát triển mạnh mẽ, đảm bảo rằng bạn luôn nhận được sự hỗ trợ kịp thời khi gặp vấn đề. Một số lý do khiến Airflow trở thành công cụ lý tưởng cho các quy trình ETL và quản lý workflow bao gồm:

- Khả năng mở rộng vượt trội: Airflow dễ dàng thích ứng với mọi môi trường làm việc, từ các dự án nhỏ đến hệ thống phức tạp.

- Tự động hóa toàn diện: Airflow cho phép xây dựng các pipeline end to end một cách tự động.

- Quản lý và giám sát hiệu quả: Giao diện web trực quan giúp người dùng dễ dàng quản lý.

- Khả năng tích hợp mạnh mẽ: Airflow hỗ trợ nhiều công cụ phổ biến cũng như các dịch vụ đám mây hiện nay.

- Linh hoạt và tùy chỉnh cao: Với Python, Airflow cho phép bạn xây dựng các pipeline phù hợp với các yêu cầu cụ thể của tổ chức, từ quy mô nhỏ đến những quy trình phức tạp.

Tại sao không phải là Airflow?

Mặc dù Airflow là một công cụ mạnh mẽ, nhưng nó không phải lúc nào cũng là lựa chọn phù hợp cho mọi trường hợp sử dụng. Dưới đây là một số hạn chế của Airflow:

- Không phù hợp cho các quy trình làm việc dựa trên sự kiện thời gian thực: Airflow được thiết kế để xử lý các quy trình batch định kỳ. Dù có API CLI và REST để kích hoạt workflow, nhưng Airflow không được tối ưu hóa cho các luồng công việc chạy liên tục hoặc phát trực tuyến thời gian thực. Để xử lý dữ liệu real-time.

- Phụ thuộc nhiều vào việc viết mã: Triết lý của Airflow là “workflow as code” (quy trình làm việc được định nghĩa bằng mã). Do đó, người dùng cần kiến thức lập trình để khai báo và tùy chỉnh pipeline mặc dù đã có giao diện web hỗ trợ người dùng.

Tổng kết

Bài viết trên mình đã cung cấp một cái nhìn tổng quan về Apache Airflow, từ ưu điểm, hạn chế cho đến các trường hợp sử dụng điển hình. Trong các bài viết tiếp theo về airflow, mình sẽ đi sâu hơn vào cách tạo pipeline trên Airflow và cũng có thể mình sẽ ra thêm seri về việc kết hợp sử dụng dbt với airflow đang rất phổ biến hiện nay!

All rights reserved