[Research Paper GPT-3] Large Language Models are Zero-Shot Reasoners

Bạn có thể download Research Paper ở cuối bài viết.

Large Language Models are Zero-Shot Reasoners ?

"Large Language Models are Zero-Shot Reasoners" là một khái niệm chỉ tính năng mới của các mô hình ngôn ngữ lớn như GPT-3, cho phép chúng có khả năng thực hiện những tác vụ mà chúng không được huấn luyện trực tiếp để thực hiện.

Trong trường hợp của Zero-Shot Reasoning, mô hình ngôn ngữ có thể giải quyết các tác vụ mới mà không cần huấn luyện trước về cách thực hiện các tác vụ đó. Thay vào đó, mô hình được cung cấp với thông tin về tác vụ và một số thông tin khác, ví dụ như một tập từ vựng hoặc một số ví dụ mẫu, và từ đó mô hình sẽ tìm cách giải quyết tác vụ mới dựa trên kiến thức đã học được từ việc huấn luyện trên các tác vụ khác.

Với tính năng này, mô hình ngôn ngữ lớn có thể được sử dụng để thực hiện nhiều tác vụ khác nhau mà không cần phải huấn luyện trực tiếp cho từng tác vụ riêng lẻ. Tuy nhiên, mức độ chính xác của các kết quả thực hiện tác vụ mới sẽ phụ thuộc vào số lượng thông tin được cung cấp cho mô hình và độ tương đồng giữa tác vụ mới và các tác vụ mà mô hình đã được huấn luyện.

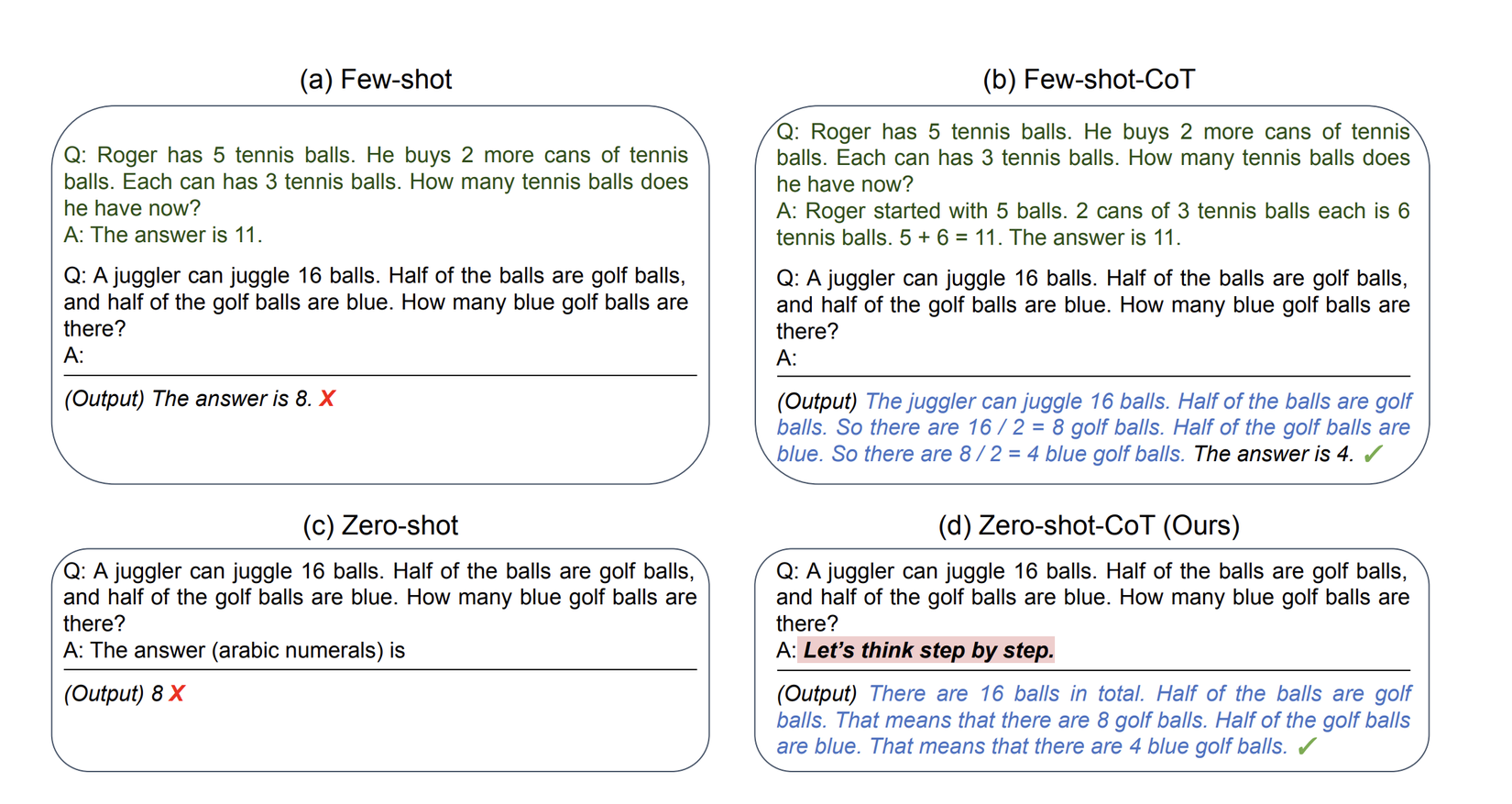

Hãy nhìn vào ví dụ sau:

Few-shot và Few-shot-CoT đều là các phương pháp học máy được sử dụng để giải quyết các vấn đề liên quan đến việc huấn luyện mô hình trên số lượng dữ liệu nhỏ.

Few-shot là một phương pháp học máy cho phép mô hình học từ một lượng nhỏ các mẫu dữ liệu huấn luyện, thường chỉ từ vài đến vài chục mẫu. Thay vì huấn luyện trên một lượng lớn dữ liệu, mô hình được huấn luyện để có khả năng tổng quát hóa trên nhiều tác vụ khác nhau. Few-shot giúp cho việc xây dựng và huấn luyện các mô hình học máy trở nên dễ dàng hơn đối với các tác vụ có số lượng dữ liệu huấn luyện nhỏ.

Few-shot-CoT (Few-shot Co-training) là một phương pháp học máy dựa trên ý tưởng của Few-shot, nhưng nó sử dụng kỹ thuật đồng huấn luyện để cải thiện độ chính xác của mô hình. Kỹ thuật đồng huấn luyện cho phép mô hình học từ nhiều nguồn dữ liệu khác nhau, tạo ra một mô hình tổng quát hơn và có khả năng tự động cải thiện khi có thêm dữ liệu mới. Few-shot-CoT đặc biệt phù hợp cho các tác vụ cần độ chính xác cao và số lượng dữ liệu huấn luyện nhỏ.

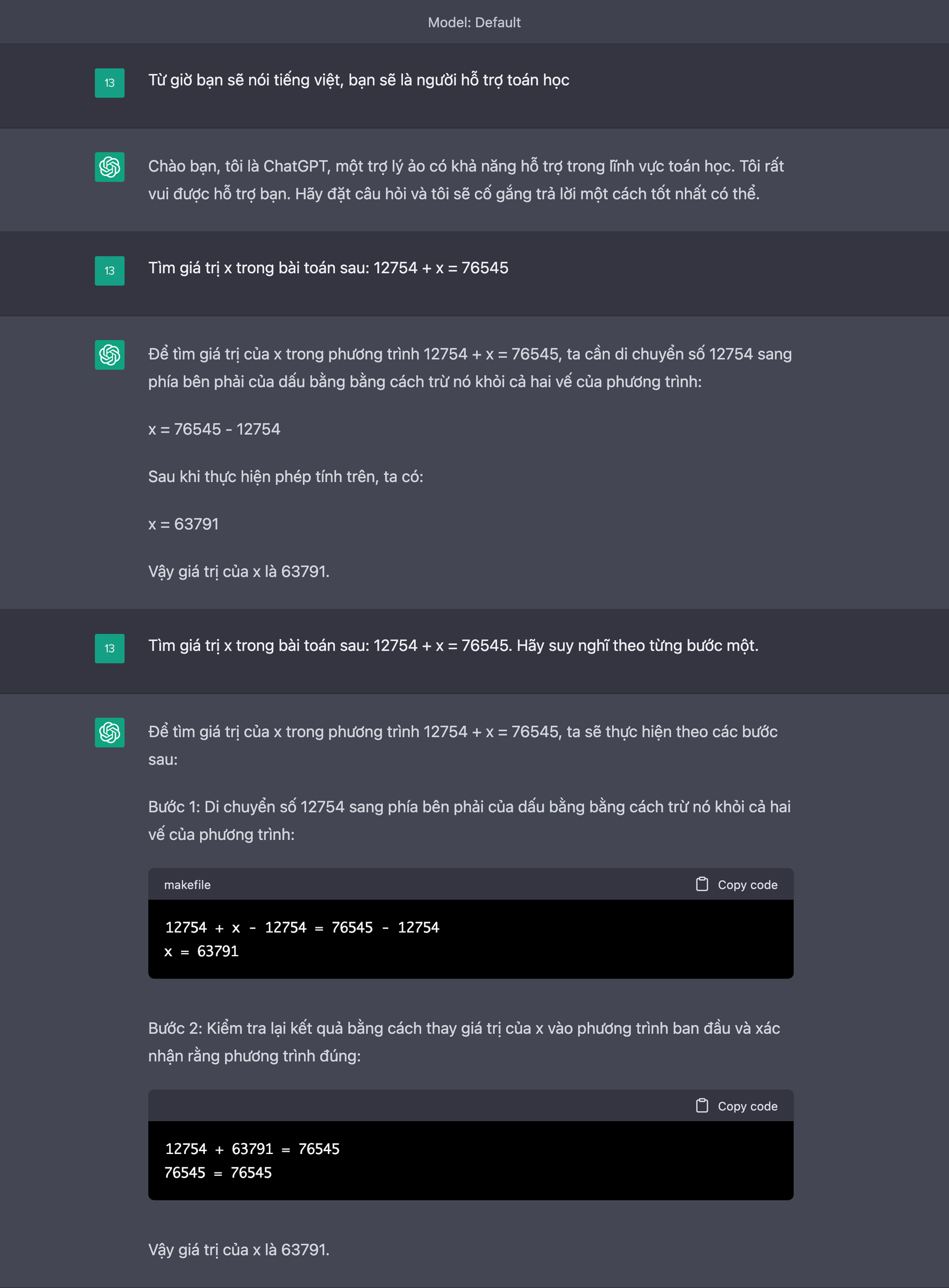

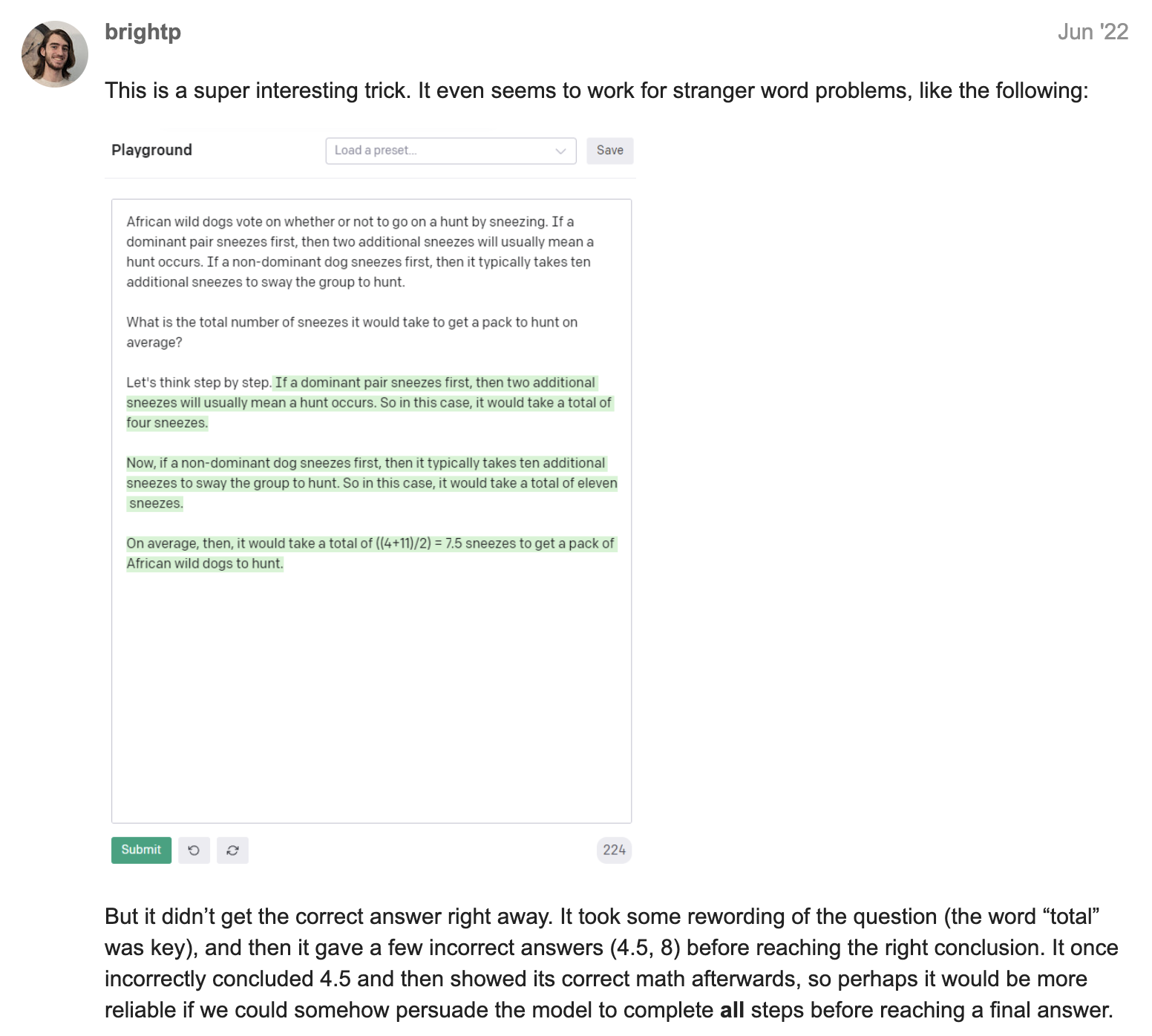

Câu promt để bạn có thể thực thi trong ChatGPT: ": Let’s think step by step" hoặc "Hãy suy nghĩ từng bước một"

Điều này có nghĩa trong tương lai GPT-4 ... (Hiện tại Bing đang áp dụng) có khả năng suy luận ... theo mô hình ngôn ngữ lớn LMM Zero-Shot Reasoners.

Đây là một trong những số cách viết promt 1 cách hiệu quả. Hãy chia sẽ các kết quả mà bạn ứng dụng câu promt này, để chúng ta có bài thảo luận thú vị:

Let’s think step by step" hoặc "Hãy suy nghĩ từng bước một"

Research Paper: https://arxiv.org/pdf/2205.11916.pdf

Community Global ChatGPT Topic: https://community.openai.com/t/zero-shot-perfection-with-prompt-let-s-think-step-by-step/18609

Cộng đồng ChatGPT Vietnam Topic: https://congdongchatgpt.com/d/33-research-paper-gpt-3-large-language-models-are-zero-shot-reasoners

All rights reserved